苹果斥资10亿引入Gemini,Siri体验能否革新?

苹果每年花费10亿美元引入Gemini外援,Siri体验真的要刷新了吗?这就像是让好学生Gemini帮Siri补习。

在AI大模型的浪潮中,苹果明显是那个姗姗来迟的学生。

11月4日,苹果正式宣布Apple Intelligence功能支持繁体中文。然而在过去两年里,Siri的「生成式AI化」几乎成了业界的笑柄。从WWDC24的「即将升级」,到今年说的「明年上线」,Siri的大模型重构计划一次次跳票。

Apple Intelligence虽然在过去一年稳步推进功能上线,以及支持更多语言(包括简体中文)和市场,但功能丰富度和表现都不尽如人意。

就在很多人对Siri的未来逐渐失去耐心时,一则消息让局势变得微妙起来。据彭博社知名记者Mark Gurman报道,苹果正与谷歌敲定一项为期多年的合作协议——苹果将每年支付约10亿美元,以获得谷歌Gemini大模型的使用权。

与此前在部分功能中引入可选的ChatGPT不同,与Gemini的合作可能意味着,苹果将首次把外部大模型直接接入到Siri与Apple Intelligence的云端推理层,让Siri终于能做其他手机AI助手已经做了一年多的事。

对苹果而言,如果真的选择了Gemini,这既是一次权宜之计,也是留给大模型团队的补课机会。但这可能不是一次寻常的技术授权,10亿美元对苹果来说不算贵,关键在于苹果真正买来的东西究竟是什么?

Gemini能否拯救苹果智能?

过去一年,谷歌在大模型领域打了一场漂亮的翻身仗。无论是Gemini 2.5 Pro强大的推理表现,还是Flash的高性价比,Veo 3在视频生成方面的引领,亦或是Nano Banana对AI生图、修图的颠覆,都证明了谷歌AI技术处于第一阵营的绝对实力。所以苹果选择Gemini并不让人意外。

但令人意外的是,据彭博与路透等媒体报道,苹果和谷歌合作的核心,不是为Siri增添一个可选回答源,而是让Gemini成为Apple Intelligence的云端底座。

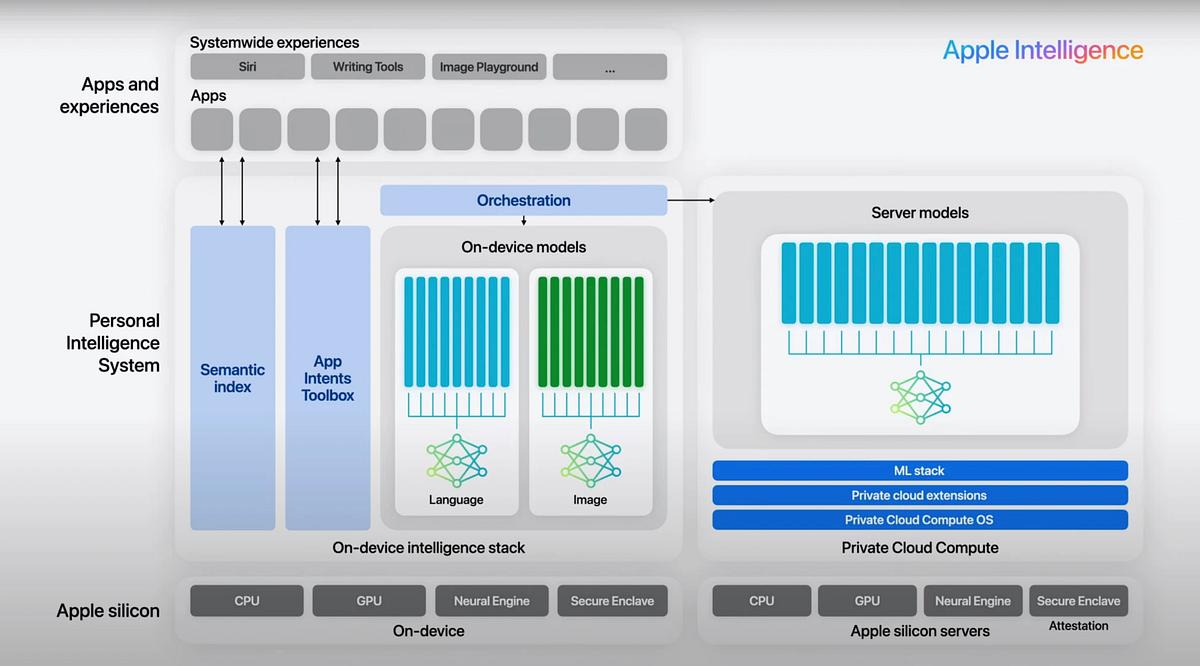

具体来说,当用户在iPhone上发出复杂请求,如生成图像、总结长文档时,系统可能会直接调用云端1.2万亿参数的Gemini大模型,在苹果的PCC私有云计算服务器中完成推理。

简言之,Gemini不再是外挂,更像是嵌入底层的「大脑」。这个变化不仅有机会让Siri彻底补齐短板,也可能重新定义苹果与谷歌的关系。

对用户来说,这可能是一次无痛的升级。过去调用ChatGPT更像是额外选项,需要用户主动选择并确认。而一旦Gemini成为默认的云端推理层,AI体验将更无缝、更统一。无论是语音生成、图像摘要还是跨应用任务,不管是AI功能还是Siri都可能在同一逻辑下完成,真正革新体验。

更重要的是,这一切仍将在苹果自建的PCC私有云计算服务器环境中运行,意味着用户数据不会离开苹果控制范围。也就是说,苹果希望「借脑不借心」,继续维持对用户隐私的保证。

另一方面,经过一年多的验证,Apple Intelligence在端侧的自研大模型足以支撑日常任务,但在更复杂的内容生成与多模态理解上,仍受限于模型体量与训练深度。Gemini的加入可以在短期内显著提升Siri的响应复杂度,让苹果不必等自家云端大模型完全成熟后再开放体验。

某种意义上,这相当于一次止血,既能保住口碑,也能为苹果大模型团队赢得研发喘息空间。

当然对谷歌来说,这无疑是一次巨大的扩张机会。即便将Gemini作为设备底层模型的三星,实际能体验到完整AI能力的设备和潜在用户规模也远远比不上苹果,而且除了手机,苹果还有庞大的iPad和Mac用户。比起媒体报道中10亿美元的技术使用费,进入苹果生态的「长期座位」才是关键。

不过这件事对国内苹果用户显然没有直接影响。据媒体此前报道,苹果在中国市场将采用百度文心大模型,可能还会引入阿里云的合作。但可惜的是,目前Apple Intelligence引入国内的时间表仍不清晰,库克的表态也仍然是「正在努力进入中国市场」。

无论如何,这场「Gemini计划」如果落地,意义已超越Siri自身。不同于部分功能引入ChatGPT,它代表苹果在生成式AI战场上首次向外求援,也意味着iPhone的智能体验或许将迎来一次真正的跃迁。

只是,这一步如果走得太快,也让人不禁想问:苹果的智能,未来还有多少会是「自己造」的?

苹果智能“打铁还需自身硬”

10亿美元对谷歌不重要,对苹果也不重要。事实上为了在iPhone将谷歌搜索设置为默认搜索引擎,谷歌每年要给苹果200亿美元。对苹果来说,钱从来不是问题,真正的问题在于——自研大模型的进展,是否还跟得上这场AI军备竞赛。

过去两年,苹果在AI上的节奏可谓「稳到让人着急」。Siri团队经历了多次重组,据The Information等媒体多次报道,苹果内部存在方向摇摆与管理层分歧:一派主张渐进优化Siri,另一派坚持彻底重构为大模型驱动。这种拉扯以及原团队的开发执行能力,都影响到了Siri的生成式AI化进程。

今年7月,苹果机器学习研究团队发布了一份技术报告,披露了苹果的两类自研模型。首先是约30亿参数的端侧模型,针对KV - cache共享、量化感知训练等进行了优化;其次是去年底就透露出的百亿级参数云端大模型,采用了目前主流的Mixture of Experts(MoE)架构,计划将多专家路径与苹果的PCC私有云计算服务器深度结合,以提升推理效率与隐私安全。

相比之下,苹果的端侧模型明显进展更快,对基础任务的支持已经比较完善,同时还在今年WWDC25前后开放给了开发者,真正开始将端侧算力和模型释放给第三方应用,并且逐渐涌现出不少利用端侧模型的应用。但从目前来看,苹果的云侧模型距离大规模商用仍有不少距离。

在这种背景下,引援Gemini就显得既现实又急迫。它为苹果填上了关键的一块短板——复杂任务推理与多模态生成。从策略层面看,这也是苹果典型的路径:先引入最强的外部能力,稳住体验,再用时间慢慢完成自研替换。

正如当年的地图、芯片、相机模组,苹果往往会在外部成熟技术的基础上,逐步构建自己的闭环。

但问题在于,这一次的追赶难度前所未有。OpenAI、Anthropic、谷歌都在快速迭代,模型规模与生态反馈形成了正循环。苹果或许更擅长产品定义与集成体验,但面对超大规模的模型训练以及数据处理、利用,却很难说有多少优势。

或许,Gemini的加入能让Siri和Apple Intelligence在短时间内弥补苹果在AI能力上的产品体验劣势,但能否让苹果抓住机会赶上AI终端甚至大模型的第一阵营?需要时间来回答。

写在最后

理想情况下,苹果当然可能借助引入Gemini争取来的时间完成模型上的赶超,但或许我们也应该承认另一种可能:苹果在云端大模型的竞争里,永远追不上第一阵营。

不是没钱、没算力,而是这场竞赛的节奏,已经不属于苹果的节奏。它擅长的是长线积累、体验打磨,而不是高频迭代和激进试错。

另一方面,如果有一天苹果放弃对自研云端模型的执着,选择构建一个第三方云端大模型生态和架构,自身把更多注意力都放回端侧模型,也未必是坏事。毕竟在端侧,苹果拥有最完整的芯片架构、最成熟的能效优化体系,以及最稳固的用户信任。

这也许就是苹果式AI的可能路径,不抢最前沿的风头,而是尽量让智能变得可靠、安全、可持续。

本文来自“雷科技”,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com