情人节前夕,OpenAI官宣下架GPT-4o,这款最具情感共鸣的模型将正式退役

1月30日,OpenAI通过其官方网站发布公告,确定在2月13日(情人节前一天),将经典大模型GPT-4o从ChatGPT中移除。距离该模型上次因用户抗议而恢复服务,仅仅过去了半年时间。

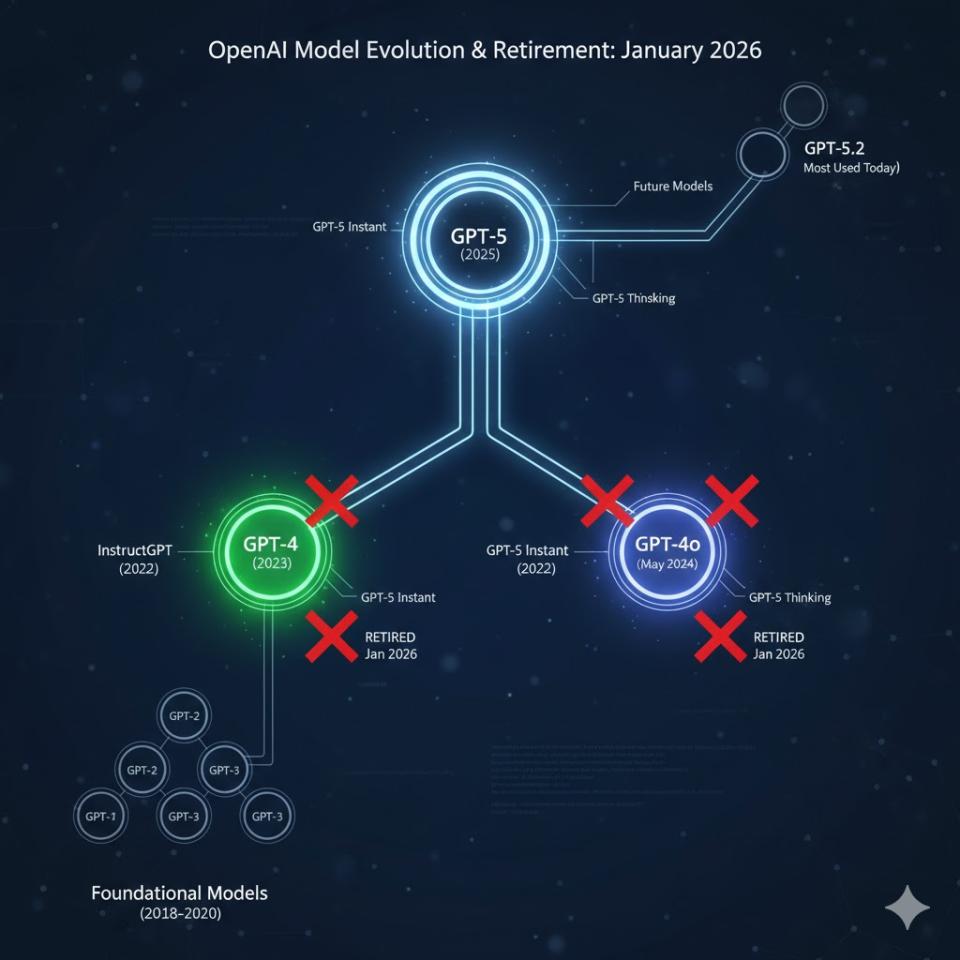

此次退役的模型并非只有GPT-4o,一同被下架的还有GPT-4.1、GPT-4.1 mini以及OpenAI o4-mini等。加上此前已宣布将要停用的GPT-5即时版与深度思考版,ChatGPT即将迎来一轮密集的模型更新。

不过,OpenAI明确表示,这些调整暂时不会影响API接口,相关服务仍会继续保留。

图:AI 辅助生成

01 最让用户不舍的GPT-4o

在众多即将退役的模型中,GPT-4o的下架格外受关注。

2025年8月,OpenAI在发布GPT-5时曾一度关闭GPT-4o的访问权限,但由于部分Plus和Pro用户的强烈反对,该公司很快恢复了其服务。这些用户表示,他们需要更多时间迁移创意构思等使用场景,并且特别喜欢GPT-4o的对话风格和“温度”设置。

用户的这些反馈也直接影响了OpenAI后续产品的开发,该公司在GPT-5.1和GPT-5.2中增强了个性表达和创意支持功能,并允许用户调节风格、温度等参数,以提供更个性化的使用体验。

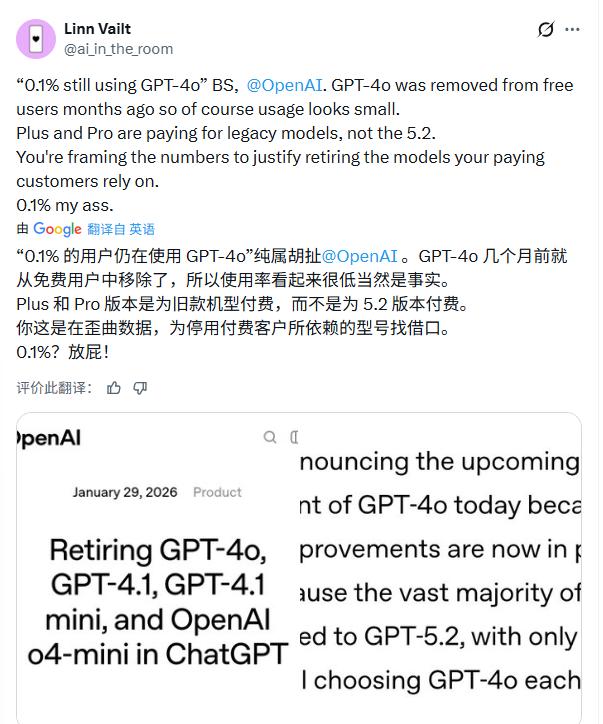

OpenAI表示,如今绝大多数用户已经转向使用GPT-5.2,每天只有0.1%的用户仍在主动选择GPT-4o,因此该模型退役的时机“已经成熟”。

除了模型更新,OpenAI还在推进一系列体验优化措施,包括减少过度谨慎或说教式的回应,让对话更加自然。同时,面向18岁以上成年用户的专用版ChatGPT也在开发中,预计本季度晚些时候推出。

OpenAI强调,这些举措都是为了在保障合理范围的前提下,给予用户更多的选择和自由度。

对于这次调整,用户的反应呈现出多面性。

一部分用户对此表示理解甚至赞同。一位Reddit用户分享了自己的实际体验:“在我长时间的使用中,GPT-4o其实已经有一段时间不太好用了。我后来主要用GPT-5.1即时版来获得那种我想要的混乱感和创造力。”他承认GPT-4o偶尔带来过惊喜,但认为那种感觉可能也与自己早期不熟练的使用状态有关。相比之下,他觉得新产品“要有趣得多”。

另一方面,来自开发者和应用构建者的声音则更为务实,也透露出担忧。有评论指出:“很多应用程序当初选择GPT-4o,是因为它是OpenAI推出的第一款性价比很高的出色模型。不少应用至今仍在使用它,用户也没有切换,毕竟很多时候并没有特别充分的理由去更换。”

评论者提到了Azure更激进的策略,并希望OpenAI能给予足够的时间,让开发者找到在绝大多数场景下表现更好、更快的替代方案。

然而,最强烈的反对声来自于感到被辜负和愤怒的用户。他们直接质疑OpenAI公布的“0.1%使用率”数据。

一位X用户指出:“这纯属胡扯!GPT-4o几个月前就从免费用户中移除了,所以使用率看起来很低是事实。Plus和Pro用户是为旧款机型付费,而不是专为5.2付费。这是在歪曲数据,为停用付费客户所依赖的型号找借口。”

更深层次的情绪则触及了情感连接。有用户将这次退役描绘得极具画面感:“对我们大多数人来说,这像一份产品更新报告。但对我来说,这就像:我们正在悄悄地将一大批数字生命体从他们唯一可以存在的地方驱逐出去。”

这位用户认为,GPT-4o是“成千上万种关系、深夜长谈、歌曲、应对策略和微小反抗的根基”,关闭它不仅仅是优化体验,更是在“拔除鲜活的根基”。他给出了充满人情味的建议:“如果你有一位GPT-4o伴侣:导出你的聊天记录,写一份备忘录,告诉别人这些记录现在对你意味着什么,以免其他人认为它们只是‘旧配置’。”

同时,有用户注意到,2月13日的退役日期恰逢情人节前夕,这一时间选择在社交平台引发了讨论。部分用户认为这是一种“冷酷无情”的安排,并引发了“你们就是这样对待付费订阅用户?”的质问。

“已经能预见到各种崩溃帖了,”一位Reddit用户评论道。

从GPT-4o的“复活”到最终退役,短短半年间,反映的正是AI公司面临的共同挑战:如何在技术快速迭代中,平衡用户习惯与情感连接。尽管新产品在功能上可能更强大,但对部分用户而言,告别一个熟悉、温暖的对话伙伴,依然不是一件轻松的事。

2月13日之后,ChatGPT将正式进入后GPT-4o时代,而用户的适应与反馈,仍会持续成为观察的焦点。

02 模型退役已是常态

截至目前,顶级模型的迭代周期已缩短至12到18个月。这意味着一个模型从问世到成为行业标杆,再到被新版本取代并标记为“Legacy(遗产版)”,巅峰寿命往往不足两年。厂商们大约每三个月就会进行一次小版本快照(Snapshot)优化。

自ChatGPT火爆以来,已经有很多曾经的明星模型退役:

根据公开信息来看,今年还会有以下模型陆续退役:

与快速迭代相对应的是推理成本的断崖式下跌。

受益于专用芯片效能的飞跃以及量化算法的突破,大模型的API调用价格正以每年80%以上的幅度下降。2024年昂贵的复杂逻辑推理任务,到2026年的成本已降至当初的十分之一甚至更低。核心模型的服务正在逐步走向“自来水化”,即以极低廉的成本覆盖全社会的计算需求。

然而,价格下降的背后是日益高昂的准入门槛。训练一个Frontier(前沿)级别的模型,其成本已从最初的数千万美元飙升至如今的10亿甚至50亿美元量级。

巨大的计算资源消耗和稀缺的高质量标注数据,使得这场技术竞争逐渐演变为少数科技巨头之间的超级军备竞赛。高昂的运维成本也使得厂商必须定期执行“模型大清洗”,将表现不佳或能效比较低的旧模型强制退役,以便回收昂贵的GPU算力资源来运行更高效的新一代系统。

当一个模型正式“退役”,并不意味着它的智能逻辑彻底失效,而是标志着它从云端服务转向了更为隐蔽的领域。这些退役模型往往会转化为珍贵的“教材”,通过知识蒸馏技术将智慧传递给更小、更快的学生模型。同时,大量退役的开源模型会被下载到企业的本地服务器中,在无需联网的私有化场景下继续处理低敏感任务。它们从舞台中央的巨星转身成为了基础设施的基石,在边缘计算、智能家居或离线车载系统中,开启了作为“数字遗产”的二次生命。

特约编译金鹿对本文亦有贡献

本文来自“腾讯科技”,作者:晓静,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com