为什么英伟达H20的性能“抽签”会大卖?

根据SemiAnalysis芯片行业咨询公司的最新预测,英伟达公司专门为中国市场提供的H20芯片,有望在当前财年大幅提升该公司在中国区的业绩。

该机构预测,英伟达预计今年将交付超过100万个新的H20芯片。仅这款芯片就将贡献超过120亿美元(约合870亿人民币)的利润按单个芯片1.2万美元-1.3万美元计算。

值得注意的是,在去年的财务报告中,英伟达中国区的收入达到了103亿美元。也就是说,如果SemiAnalysis预测实现,仅H20显卡的销售额就会超过上一财年英伟达中国区的整体收入。

今年年初,国内公司对H20持观望态度,H20的性能大幅下降。现在,凭借英伟达的生态优势,再加上华为升腾910B一直供不应求,即使性能“抽签”,H20也逐渐变得火热起来。

01 H20的接受度逐渐提高。

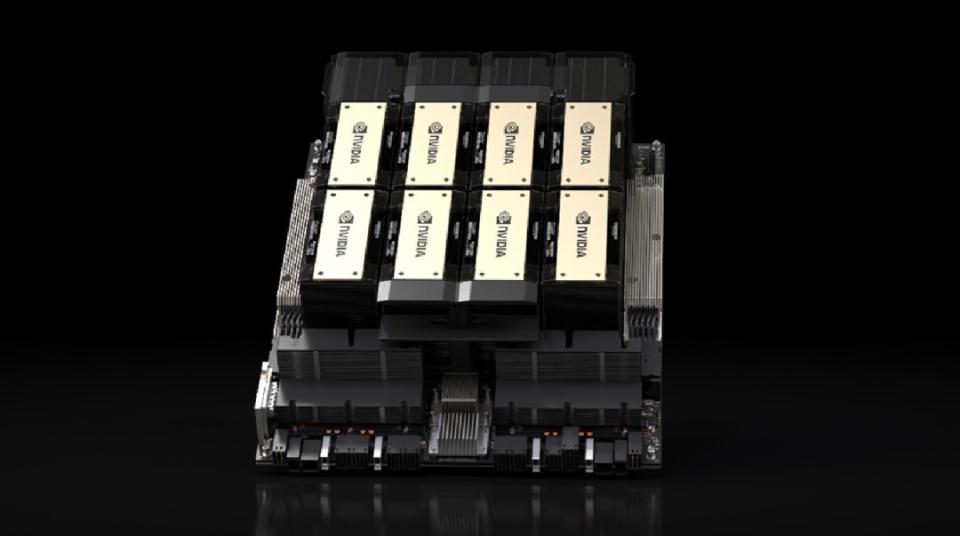

今年2月,在中国市场接受预订之初,经销商给企业客户的价格为150,000美元(约110,000元人民币),一台配备8张H20计算卡的服务器售价约为150万元。

现在,一位经销商告诉《IT时报》记者,目前一台配备8台H20的服务器价格约为120万台。

业内人士告诉记者,包括百度、阿里、腾讯、字节在内的大型互联网公司是H20的主要需求者。这位人士说:“因为他们可以合规进口,除了H20,他们别无选择。

尽管H20在性能上不如英伟达达。 H100,其AI算率不到后者的15%,但H20成为企业的无奈选择,因为华为升腾910B在国产芯片中最接近英伟达顶级芯片,供应一直紧张。

今年1月,《IT时报》报道称,一些国内厂商将在今年第一季度获得H20,但大多数中国公司仍在观望,因为这些“特别版”的AI芯片性能大幅下降。半年后,H20芯片在中国的接受度逐渐提高。

《IT时报》记者注意到,7月9日,万马科技在投资者关系活动中表示,目前公司利用英伟达H20建设计算率集群,建设无人云服务项目。该公司进一步表示,如果未来合规问题能够得到解决,将考虑使用英伟达A/H100,并与国内供应商合作进行测试。如果满足客户需求,未来不排除使用国产AI芯片。

然而,在6月24日发布的公告中,万马科技表示,全资子公司优卡科技将在江苏常州建设自动驾驶云服务建设项目,总体规划服务器1个SU,共计31个NVIDIA。 H20 服务器。

7月10日,一位投资者在互动平台上向弘信电子提问:“英伟达H20下半年在中国区爆炸。作为一级代理商,公司最近有没有订购H20芯片?”

对此,弘信电子回应称,作为英伟达中国区的精英合作伙伴,公司全资子公司安联通拥有英伟达芯片获得的渠道优势,为用户提供H20计算率业务是安联通业务的大力发展方向之一。

记者注意到,自2023年4月以来,弘信电子战略性布局了两大业务:AI计算服务器硬件R&D制造和AI计算租赁。本月,弘信电子花费2.93亿元购买英伟达合作公司北京安联通科技有限公司股份。

02 生态成为国产芯片的束缚

业内人士告诉《IT时报》记者,H20芯片之所以能在中国市场站稳脚跟,很大程度上是因为它的生态系统优势,包括AMD。、英特尔和国内竞争对手很难与之匹敌。

虽然H20的性能不如顶级型号,但是对于国内大企业来说,选择H20芯片对当前生态系统的影响相对于整体工业化来说更小,因此成为一种更具吸引力的选择。

业内人士进一步透露,去年腾讯购买了不少AMD芯片,但实际利用率并不高,甚至在今年年初一度寻找“出手”。

目前,生态仍然是国内芯片制造商亟待突破的一大束缚。中国工程院教授、清华大学计算机系教授郑纬民在最近的100名中国信息化会议上表示,国产AI芯片的核心问题是生态系统不完善。他认为,虽然国产AI芯片在硬件性能上取得了显著进展,但由于软件生态系统不成熟,用户体验不佳。

什么是好生态?郑纬民认为,如果一个原本在英伟达平台上开发的人工智能软件能够轻松移植到国内系统中,那就意味着生态系统是好的。

郑纬民指出,如果国内AI芯片生态系统得到改善,即使只能达到60%的海外芯片性能,客户也会愿意使用。

03 从基本大模型转变为推理。

今年年初,山海引擎COO彭璐在接受《IT时报》采访时表示:“就大模型训练而言,H20基本上是无法使用的。H20配置更适合推理,不适合模型训练。当时,彭璐认为,从市场应用的角度来看,大型模型创业公司很少购买大量的推理率,除了一些可能用于推理培训的大厂商,因为他们更注重模型培训的竞争力。

在过去的几个月里,彭璐观察到国内计算率市场发生了很大的变化。他指出,目前国内致力于基础大模型的厂商数量正在减少,导致对大规模计算能力的需求减弱。相反,小集群的需求增加了。“中型集群的需求基本消失了。”这也使得H100等高端设备的价格在今年春节后不断下降。

记者了解到,今年年初,两家小经销商与英伟达合作,最初的目的是用H20建立“万卡集群”。然而,随着时间的推移,实际的部署并没有达到预期的规模。据知情人士透露,这两家经销商建立的最大集群是128台服务器的千卡集群。“但是千卡集群在今天的环境下是租不到的。”

彭璐进一步表示,国内计算能力需求正在从大规模模型培训转变为推理需求,尤其是企业对私有部署的推理需求越来越大。随着开源模型能力的提高,公司发现这些模型可以通过微调来满足特定的任务需求,无需投入巨资培训超大规模模型。这一趋势促进了推理市场的升温,公司专注于建立一个小模型来完成特定的任务。

彭璐说:“但是现在我们还没有看到像我们这样的IDC公司大量进入H20,主要还是有几家大厂在购买。

本文来自微信微信官方账号“IT时报”(ID:vittimes),作者:贾天荣,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com