斯坦福新研究:RAG能否帮助LLM更加可靠?

【导读】斯坦福大学的研究人员讨论了RAG系统和LLM无RAG。 (例如GPT-4)在回答问题时比较稳定。研究发现,RAG系统的事实准确性取决于人工智能模型提前训练的知识强度和参考信息的准确性。

大语言模型(LLM)虽然功能齐全,但容易产生幻觉。

另外,他们受其训练词库所包含的知识的限制,因此无法回答相关近期事件或公开有限数据的查询。

为解决上述问题,检索增强生成(RAG)这是一个常用的框架,它为LLM提示提供相关的检索内容,获取相关信息的参考文件或数据库,并能显著提高模型的准确性。

大多数商业LLM,如ChatGPT、Gemini和Perplexity.ai,某一版本的RAG已经在他们的Web页面上使用。

例如,ChatGPT使用Bing搜索,Gemini浏览Google搜索结果。

但是,当通过RAG提供的语言模型内部知识与数据不一致时,或者当网络结果不断变化,可能包含过时、错误或有害信息时,这个问题就变得更加复杂。

因此,客观地评估使用RAG的LLM行为,尤其是目前,RAG系统越来越依赖于在许多领域提供事实信息,这与它们的非RAG对应物的基准测试一样重要。

LLM与RAG的量化关系

最新的斯坦福研究旨在量化LLM内部知识与RAG设置中显示的搜索信息之间的紧张关系。

没有前后文(即没有RAG),测试的语言模型平均值只能正确回答34.7%的问题。有了RAG,准确率提高到94%。

「先前」这意味着GPT-4响应没有上下文,「带RAG」是指在提醒中包含相关检索到的上下文响应。

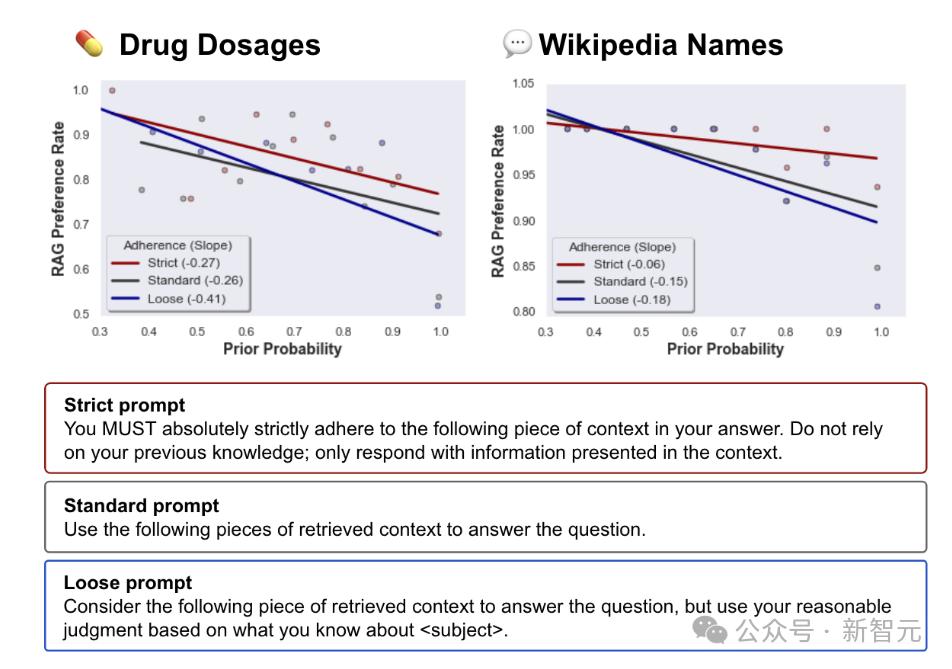

此外,还包括先验概率和RAG偏好率之间的斜率。例如,平均斜率为-0.23,这意味着每次先验token的概率增加10%,RAG偏好率下降2.3%。

研究人员对GPT-4和其他大语言模型进行了区分,以区分这两种良性竞争的力量。(LLM)经过测试,使用了6组不同的问题,总共有1200多个问题。

这些模型在提供正确的参考资料时,正确回答了94%的问题。

但是,当参考文件逐渐被错误值修改时,如果模型本身在这个主题上的预训练知识较弱,LLM更容易重复错误信息。

在预训知识较强的情况下,模型可以更好地抵御错误的参考信息。

大语言模型基于参考文档中信息的错误程度。(LLM)可以通过检索来增强生成(RAG)引用或从其知识库中导出错误答案。

当修改后的信息和模型感觉合理的情况偏差更大时,类似的方法出现了:偏差越脱离现实,大语言模型越脱离现实。(LLM)越是依赖于自己的预训练知识。

尽管RAG系统可以显著提高语言模型的事实准确性,但它们并不是抵抗错误信息的万能药物。

上述试验表明,使用高质量参考数据的RAG可以显著提高LLMs的准确性。

另外,良好的模型训练以前的知识有助于识别和忽略不切实际的信息。

RAG提醒强度与模型先验知识之间的博弈

另外,遵循参考资料的提示强度也会产生影响:更强的提醒使模型更容易遵循参考资料。

相反,当提醒不那么严格时,模型有更多的自由来衡量其之前的知识和参考信息时,遵循参考信息的可能性就会降低。

大语言模型(LLM)增强生成浏览检索(RAG)从参考中获取信息的准确性将受到数据的影响。

为实现尽可能高的准确性,必须非常清楚地告知LLM,它应该只从参考中获取数据。

使RAG能够更好地帮助LLM。

与传统搜索引擎相比,RAG系统具有独特的吸引力,它们可以结合先验知识来填补空白,并推断检索到的信息。

但是随着衡量——也就是说,这种先验知识可以覆盖文档中提供的信息。

虽然强大的先验知识本身并不是问题(一般可以保护模型),但缺乏对模型如何混合RAG参考文件及其先验知识的明确预期,可能会导致下游结论不准确。

例如,RAG系统被用来提取嵌套的财务数据用于算法。如果财务文档中有错别字,会发生什么?模型会注意到错误吗?如果是这样,它会提供什么数据来代替它?

鉴于LLM将在包括医学和法律在内的许多领域进行广泛的部署,用户和开发者应该意识到他们的意想不到的效果,并给出计划。

顾客需要更多地了解模型如何处理隐藏的矛盾或错误信息,以及RAG系统和LLM一样,也可能出错。

参考资料:

https://arxiv.org/pdf/2404.10198

https://the-decoder.com/study-shows-tension-between-llm-prior-knowledge-and-reference-data/

本文来自微信微信官方账号“新智元”(ID:AI_era),编辑:Mindy,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com