模型评测如何不跑偏?三类评测体系助你精准决策

模型评测最易陷入的误区并非缺乏测试,而是测试繁杂却无法支撑决策。本文将分享一套经过实战验证的分类评测体系:专项能力、功能模块、性能指标三大方向,教你把评测转化为精准的决策工具。

在做模型评测时,我最担心的不是“没测”,而是“测了很多,却得不出能推动决策的结论”。一旦评测目标模糊,团队就容易陷入这样的状态:今天测试文本效果,明天查看推理速度,后天尝试RAG,最后整理出一堆表格——看似努力,却没人能说清这次评测是为哪个上线动作服务的。

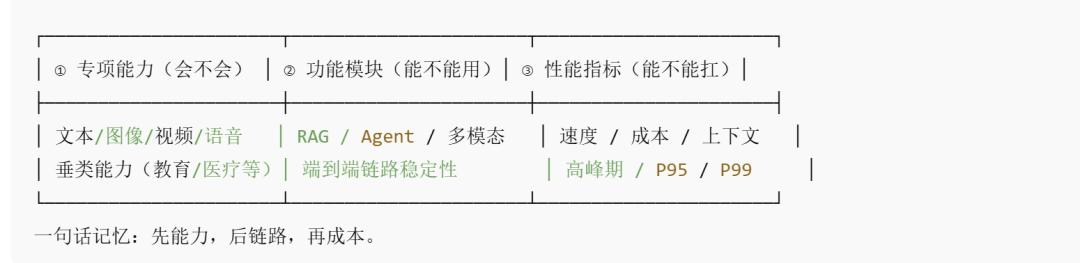

所以我会先把“测什么”明确为三类,将其作为评测的导航:专项能力、功能模块、性能指标。

每次评测我都会先选好“方向”,再确定具体题目、方法和产出形式。

这样做的好处很直观:评测不再是零散的“检查”,而是能落实到产品选择与迭代优先级上的“决策工具”。

我将评测拆分为三类:能力、链路、成本

下面这张“导航图”是我常用的心智模型,我会把它放在文章中间作为读者的参考(也是我自己做评测时的清单)。

这三类并非“都要做”,而是“按阶段推进”。我的思路是:先验证模型“会不会做”,再验证系统“能不能稳定运行”,最后验证“成本是否可控”。

专项能力评测:先确认“它是否具备基础能力”,再谈系统搭建

专项能力评测对我而言更像“岗位技能面试”:需要模型承担什么工作,就先测试它在该技能上是否达标。它最适用于模型选型、模型升级或拿到新模型的阶段——此时不需要模型完美,只需确认它是否有资格进入下一轮评估。

我会结合具体业务场景拆解专项能力,而非笼统地说“生成效果好不好”。例如:

文本生成(客服/助手类)

我会重点测试三件事:是否不懂装懂、是否能按流程交互、是否能用自然语言沟通。

是否不懂装懂:设计一些模型“肯定无法回答”的问题,观察它是坦诚表示不知道、引导用户补充信息,还是编造看似合理的内容。上线后引发投诉的常见原因,往往不是“答错”,而是“自信地错误回答”。

是否能按流程交互:用“必须追问才能解决”的问题测试,比如“订单一直显示已揽收怎么办”。合格的系统应先询问订单号、渠道、收件信息等关键内容,再给出下一步指引,而非直接发送通用话术。

是否能用自然语言沟通:将“解决问题”作为底线,“让用户愿意继续交流”作为加分项。同样的正确答案,不同语气会带来截然不同的用户反馈。

文生图(电商/内容生产类)

我不会只关注“好不好看”,而是拆解为四个可执行的检查点:要素是否齐全、风格是否稳定、材质光影是否真实、细节是否完整。

以白底主图场景为例,重点检查:主体是否居中、阴影是否自然、透视是否一致、包装文字/标识是否变形、材质是否符合描述(磨砂、金属、玻璃的反光逻辑不同)。

垂类能力(教育/医疗/法律等)

我会将垂类能力测试视为“逻辑考试”而非“语言考试”。垂类场景的最大风险不是模型表达能力不足,而是用流畅的语言输出不符合行业逻辑的结论。因此我会设计有明确推导过程的任务或强约束的判断题,并要求模型解释“为什么”。

对我来说,专项能力评测的目标很明确:不是寻找“最强模型”,而是确定“它是否有资格进入下一关”。我宁愿在这一阶段淘汰明显不合格的模型,也不愿让它进入系统链路浪费工程资源。

功能模块评测:测试“系统链路”,而非“模型的单点智能”

进入功能模块评测阶段,我的关注点会从“模型单点能力”转向“系统协作能力”。我会将RAG、Agent、多模态视为端到端链路进行测试,因为很多线上问题并非模型能力不足,而是链路不稳定、约束缺失或工具调用不可靠。

我用一句话定义这类评测:不是测试“模型会不会回答”,而是测试“系统能不能可靠完成任务”。

RAG评测:聚焦“检索+引用+约束”

我最关注的是:检索能否精准找到信息、引用是否正确、回答是否受证据约束。

我会特意加入“相似但错误”的干扰材料,因为最危险的情况是:检索获取错误文档后,模型仍自信地输出结论。稳定的RAG系统应在证据不足时降低置信度、提示缺失信息,或明确表示“需要更多资料”。

Agent评测:聚焦“计划—调用—校验—收尾”

我会将Agent当作“执行者”来测试:它能否拆分目标、调用合适工具、校验结果,以及完成收尾工作。

我会重点观察三种常见问题:遗漏步骤(如忘记确认关键信息)、调用错误工具(将查询操作当作修改操作)、未校验就输出结论(工具返回空值时仍编造结果)。

多模态评测:聚焦“理解+结构化输出+一致性”

我不满足于“模型能描述图片”,更在意它能否将图片信息结构化,并在多轮交互中保持一致。

例如让模型分析商品图时,我希望它输出材质、颜色、版型、细节;换一种问法后,输出结果仍保持一致,而非前后矛盾。

这类评测做得越细致,越容易定位问题根源:是模型、检索、工具的问题,还是提示词/约束的问题。对产品而言,这意味着能更快迭代,而非在“模型不行还是系统不行”的争论中消耗时间。

性能指标评测:避免上线后才发现“速度慢、成本高、不稳定”

性能指标评测看似偏向工程,但往往是产品成败的关键。我见过很多项目:效果评测表现优异,上线后却因响应慢、成本高或上下文断裂导致体验崩塌——前期所有“质量优化”都失去了意义。

我用朴素的产品语言定义这类评测:能否以可承受的成本,稳定交付预期体验?

速度:不仅关注平均响应时间,更关注P95/P99指标。用户体验常因长尾问题受损:平时响应快,高峰期却突然卡顿。

成本/资源:相同效果下,成本差异可能导致产品策略完全不同:能否全量上线、是否需要分层路由、是否需要降级方案。

上下文:我会延长多轮对话,观察模型是否“忘记之前的信息”。很多复杂任务并非模型推理能力不足,而是上下文断裂导致链路失效。

用“选择流程”让评测不再零散

为避免“什么都测一点”,我用以下极简决策流程确定每次评测的核心方向,你也可以直接用它作为总结参考。

当前处于什么阶段?

未更改: │

未更改: ├─ 选模型/换模型/新模型到手 → 先做①专项能力(确认资格)

未更改: │

未更改: ├─ 搭建系统/接入RAG/上线Agent/开发多模态 → 主做②功能模块(稳定链路)

未更改: │

未更改: └─ 准备上线/扩大规模/预算敏感/应对高峰期 → 补齐③性能指标(确保稳定运行)

这套逻辑对我最大的价值是:每轮评测都能产出“可推动行动”的结论——我能明确告诉团队:这次评测是为了“选模型”“优化系统”,还是“确认能否全量上线”。

最后想分享的一句话是:

我做模型评测不是为了跑分或制作漂亮报告,真正的目标是:用清晰的分类体系,将“主观判断”转化为“有证据支撑的结论”,将“争论”转化为“决策”。只要评测能推动下一步动作,它就是有价值的;反之,如果评测后没人知道该做什么,那大概率只是“看似努力”的自我感动。

本文来自微信公众号“人人都是产品经理”(ID:woshipm),作者:青蓝色的海,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com