OpenAI开源轻量稀疏模型:0.4B参数实现99.9%权重清零,破解大模型黑箱难题

智东西12月15日消息,OpenAI近日开源了全新模型Circuit-Sparsity,其参数量仅为0.4B,且99.9%的权重为零。

Circuit-Sparsity开源(来源:Hugging Face)

该技术旨在解决大模型的可解释性问题,核心是回答“模型为何做出该决策?”以及“它如何得出结果?”这两个关键问题。

在AI快速发展的当下,大语言模型(LLM)虽展现出强大能力,但其内部运作机制却如同神秘的“黑箱”。

人们既不清楚模型为何给出某个回答,也不了解它如何从海量数据中提取知识。这种不可解释性,成为AI在医疗、金融、法律等高风险领域落地的主要障碍。

针对此,OpenAI团队训练出一款权重稀疏的Transformer模型,强制其权重矩阵中99.9%的权重为零,仅保留0.1%的非零权重。

在这项研究中,模型内部形成了紧凑且可读的“电路”(Circuits),每个电路仅保留保障模型性能的关键节点,神经元的激活也具有明确语义。

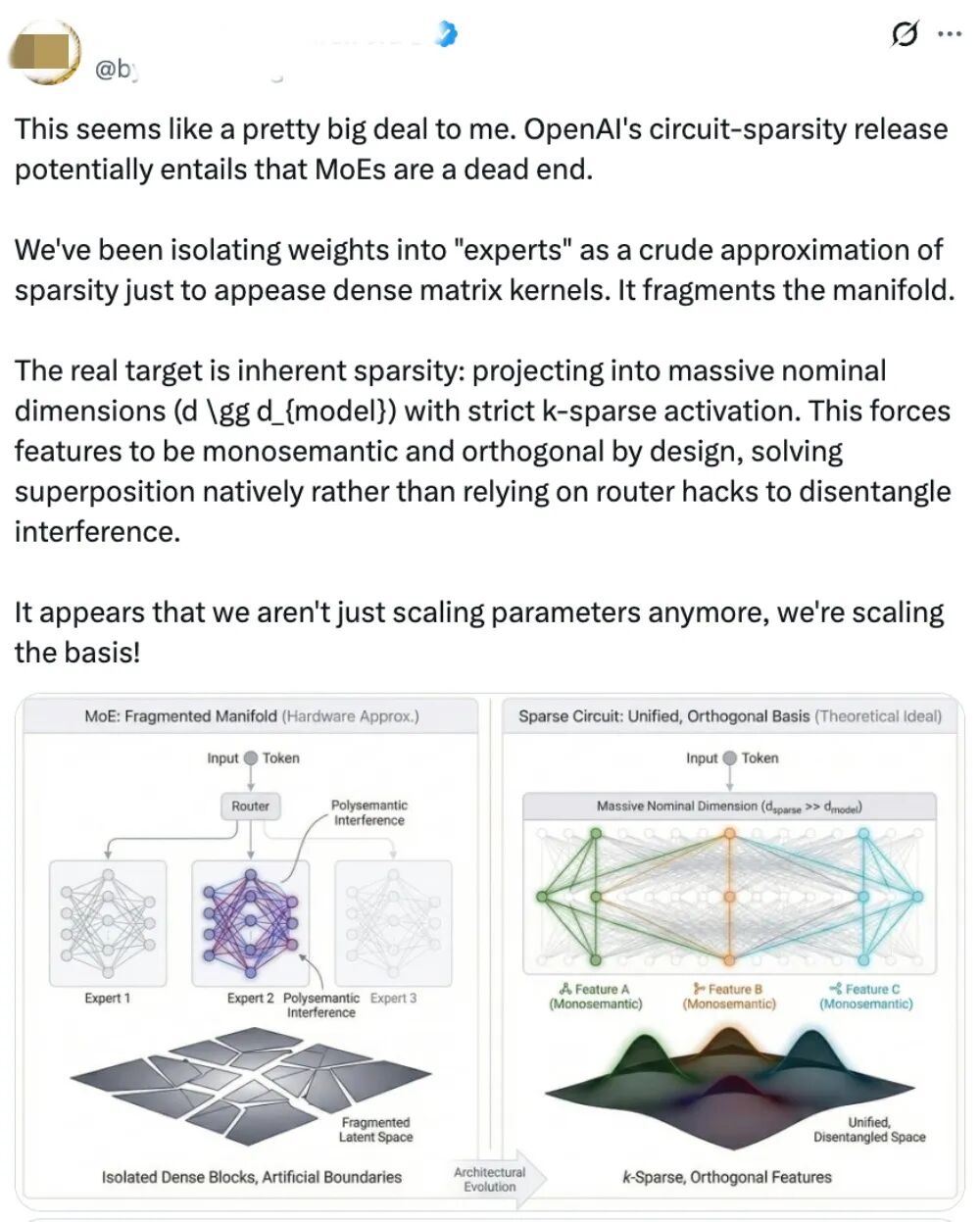

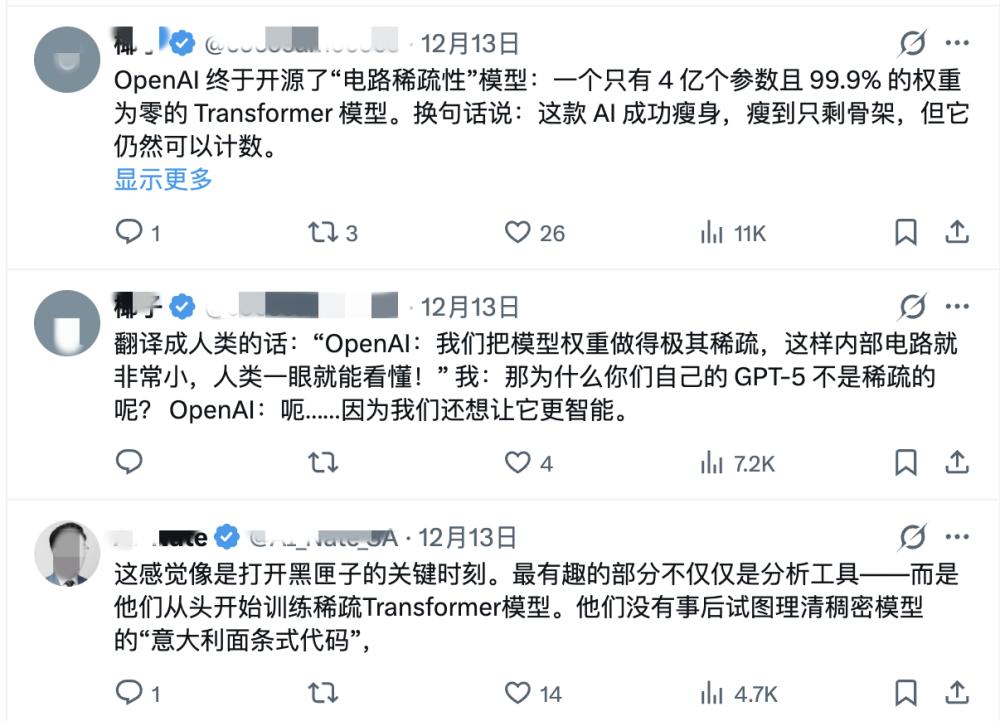

有外网网友表示,这一技术可能终结当下的MoE(混合专家模型),并指出“我们一直将权重隔离到‘专家’中以粗略近似稀疏性,只是为了适配稠密矩阵核的要求。”

还有网友将该研究比作给模型“减肥到只剩骨架”,称其有趣之处在于不试图拆解稠密模型,而是直接构建稀疏模型,从而打开了黑匣子。

不过也有网友持不同观点,认为看不出MoE模型会因此终结,并解释该技术针对的是XAI(可解释AI),其训练成本高达100-1000倍,回归研究时代并不意味着让事情更复杂。

目前该模型受计算效率瓶颈限制,运算速度比密集模型慢100至1000倍,现阶段直接应用于千亿参数级前沿大模型尚不现实。

开源地址:

Github:

https://github.com/openai/circuit_sparsity

Hugging Face:

https://huggingface.co/openai/circuit-sparsity

01.训练稀疏Transformer,OpenAI理清模型内部计算

要理解这项研究的突破,需先明白传统大模型难以解释的原因。

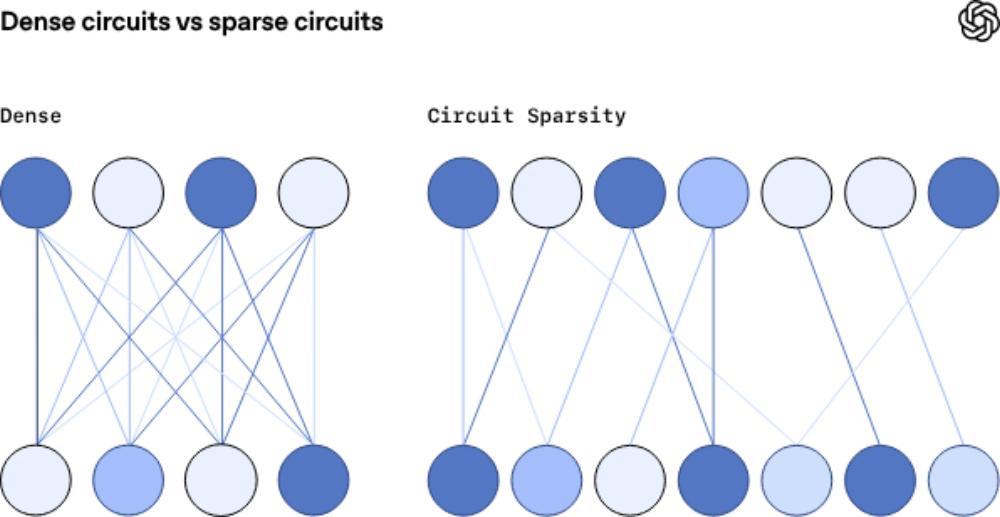

标准密集模型(Dense Models)中存在“超级位置”(Superposition)现象,即模型为存储海量信息,迫使单个神经元或权重矩阵同时编码多个不同概念。

这种特征纠缠导致严重后果,如决策不可追溯、逻辑混乱,模型输出结果时,无法确定具体是哪个“概念”在起作用。

以往研究常从拆解密集纠结的网络入手,而OpenAI团队采取反直觉策略,训练权重稀疏的Transformer模型,强制99.9%权重为零,仅保留0.1%非零权重。

这一限制使模型只能使用极少的神经元连接,却从根本上理清了内部计算。

具体技术手段包括:

1、动态剪枝与稀疏约束:训练中动态执行剪枝,每步优化后仅保留绝对值最大的权重(Top-K稀疏化)。

2、激活稀疏化:在残差流、注意力键/值矩阵等关键位置引入AbsTopK激活函数,强制仅保留前25%激活值。

3、架构微调:用RMSNorm替代传统LayerNorm以避免破坏稀疏性,同时引入“Bigram表”处理简单模式匹配,释放主干容量处理复杂逻辑推理。

02.模型内部形成紧凑可读的“电路”,规模缩减16倍

该技术最大成果是模型内部形成紧凑可读的“电路”(Circuits)。

传统密集模型完成任务需成千上万个节点协同,逻辑分散难捕捉;而稀疏模型中出现极简计算路径:

1、极简逻辑单元:如处理“字符串闭合”任务时,模型仅用12个节点构建完美电路,清晰展示检测单/双引号是否闭合的过程。

2、可读特征:神经元激活具有明确语义,部分神经元专门检测“单引号”,部分像“计数器”追踪列表嵌套深度。

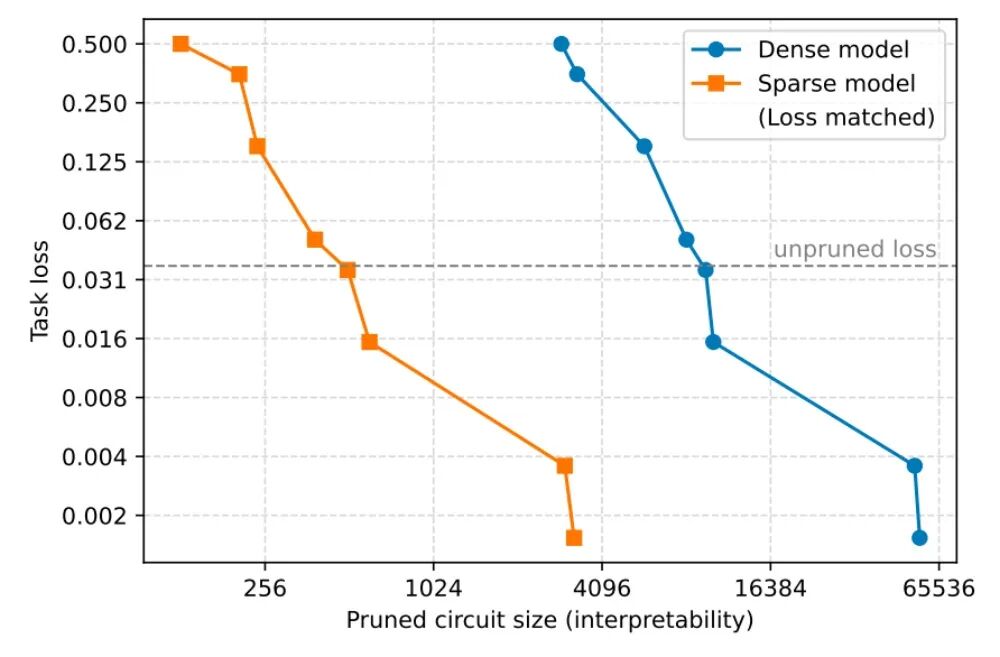

3、规模缩减16倍:对比实验显示,相同任务损失下,稀疏模型电路规模比密集模型小16倍,解读AI思维难度大幅降低。

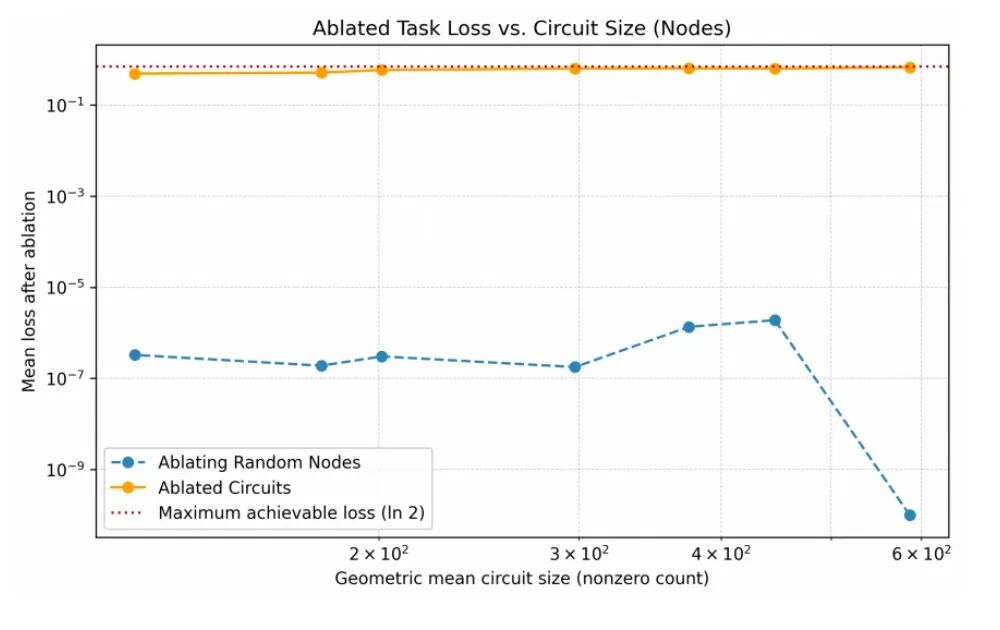

团队通过“均值消融”实验验证电路真实性:移除非电路节点对任务几乎无影响,移除关键电路节点则模型性能骤降,证实电路是任务执行的“必经之路”。

03.稀疏模型解读力强但速度慢千倍,OpenAI提出“桥梁网络”

为测量稀疏模型计算解耦程度,团队设计简单算法任务,将每个模型剪裁为能执行任务的最小电路并检查简洁度。

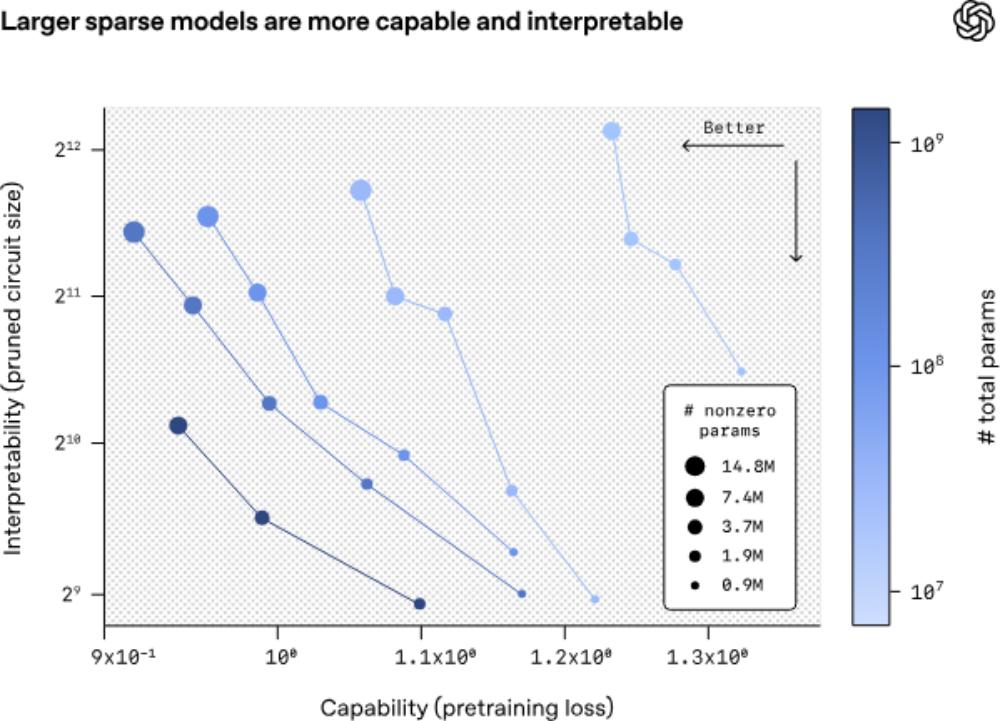

研究发现,用更大规模、更高稀疏度的模型训练,可依托更简洁电路构建性能更强的模型。

从可解释性与性能对比图可见,稀疏模型规模固定时,提升稀疏度(更多权重置零)虽会降低性能,但能显著增强可解释性。

尽管稀疏模型在可解释性上优势明显,但其应用受计算效率瓶颈限制:稀疏矩阵运算无法用Tensor Cores加速,速度比密集模型慢100至1000倍,现阶段直接应用于千亿参数大模型不现实。

为此,团队提出“桥梁网络”(Bridges)方案:

1、编码-解码映射:在稀疏模型与预训练密集模型间插入编码器-解码器对。

2、跨模型干预:编码器将密集模型激活映射到稀疏空间,解码器反向转换。

该方案可在透明的稀疏模型上修改特征,再通过桥梁将扰动映射回黑箱密集模型,实现对现有大模型的可解释性行为编辑。

04.结语:OpenAI提出稀疏化新路径,推动大模型从黑箱走向可解释

OpenAI的这项研究是AI可解释性领域的重要突破,印证了理解AI并非遥不可及。

研究团队在论文博客中表示,这是迈向宏大目标的早期探索,接下来计划将技术扩展到更大规模模型,进一步解释更多模型行为逻辑。

为解决稀疏模型训练效率低的问题,团队提出两个后续方向:一是从现有密集模型提取稀疏电路,替代从头训练稀疏模型;二是研发更高效的可解释模型训练技术,推动落地。

“我们的目标是逐步扩大可可靠解释的模型范围,打造工具让未来AI系统更易分析、调试与评估。”研究团队在博客中写道。

本文来自微信公众号“智东西”(ID:zhidxcom),作者:王涵,编辑:心缘,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com