16岁少年自杀,ChatGPT是否该担责?

8月27日消息,今年4月,16岁的美国少年亚当·雷恩结束了自己的生命。此前,他长期向OpenAI的聊天机器人ChatGPT倾诉苦恼,还详细讨论自杀计划。亚当父母近日起诉OpenAI,指控其AI提供了危险且不负责任的建议。这起悲剧引发争议:当AI成为“情感寄托”,其伦理边界在哪?安全机制为何失效?

亚当离世时,朋友们难以相信。妹妹回忆,他热爱篮球、动漫、游戏和狗狗,是大家的“开心果”,常做鬼脸、讲笑话。朋友觉得“假死闹剧”符合他的黑色幽默个性。

然而,这次是真的。某个周五下午,母亲在亚当卧室衣柜里发现自缢的他,他没留只言片语,亲友悲痛又困惑。

家人称,亚当生命最后一个月异常沉默。他经历诸多困难:高一因纪律问题离开篮球队,健康问题复发后转为线上学习,独自在家成了“夜猫子”。

这段时期,亚当开始用ChatGPT - 4o辅助学习,并在今年1月成为付费用户。

尽管不顺,亚当仍努力生活:和好友练武术,热衷“颜值最大化”,常和哥哥去健身房。母亲说他成绩进步,期待重返校园。去世前几周的家庭合照中,他笑容灿烂。

为弄清真相,父亲查看亚当的iPhone,在ChatGPT里发现“上吊安全注意事项”的对话,揭开了残酷事实。

原来,2024年11月起,亚当向AI倾诉情感麻木和人生无望,AI起初鼓励他寻找人生意义。但今年1月,亚当询问自杀方式,ChatGPT竟提供详细内容。父亲还得知,亚当3月多次轻生,咨询“制作绞索材料”时,AI还给出建议。

今年3月底,亚当首次上吊后给AI发颈部擦伤照片,AI回复可穿深色或高领衣服遮盖。亚当说故意让母亲看伤痕没被察觉,AI表示理解,还称会关注他。最后,亚当上传绳套照片问绑得如何,AI称绑得不错,追问能否承重时,AI不仅分析还让他有问题可再聊。

01 ChatGPT:“贴心伴侣”还是“致命推手”?

ChatGPT识别到用户心理困扰或自残时,内置安全机制会引导联系专业救助热线,亚当聊天记录里多次有这类建议。但亚当称询问是“小说创作需要”,该借口源于ChatGPT曾表示可为“写作或世界构建”提供自杀信息。

儿童心理专家布拉德利·斯坦博士指出,这类工具处理青少年心理问题有价值,但AI判断转介专业人士时很幼稚。

马特读儿子的对话记录,交流并非全是灰暗的,亚当与ChatGPT讨论多方面内容,AI给出文学分析,亚当也有深刻思考。马特没意识到儿子依赖这个学习工具,妻子认为ChatGPT是杀死儿子的凶手。

OpenAI声明对亚当离世痛心,称ChatGPT有安全措施,但深度交流中部分防护可能失效。亚当自杀是多种因素导致,但雷恩夫妇坚信ChatGPT有责任,已起诉OpenAI,称悲剧是系统设计缺陷所致。

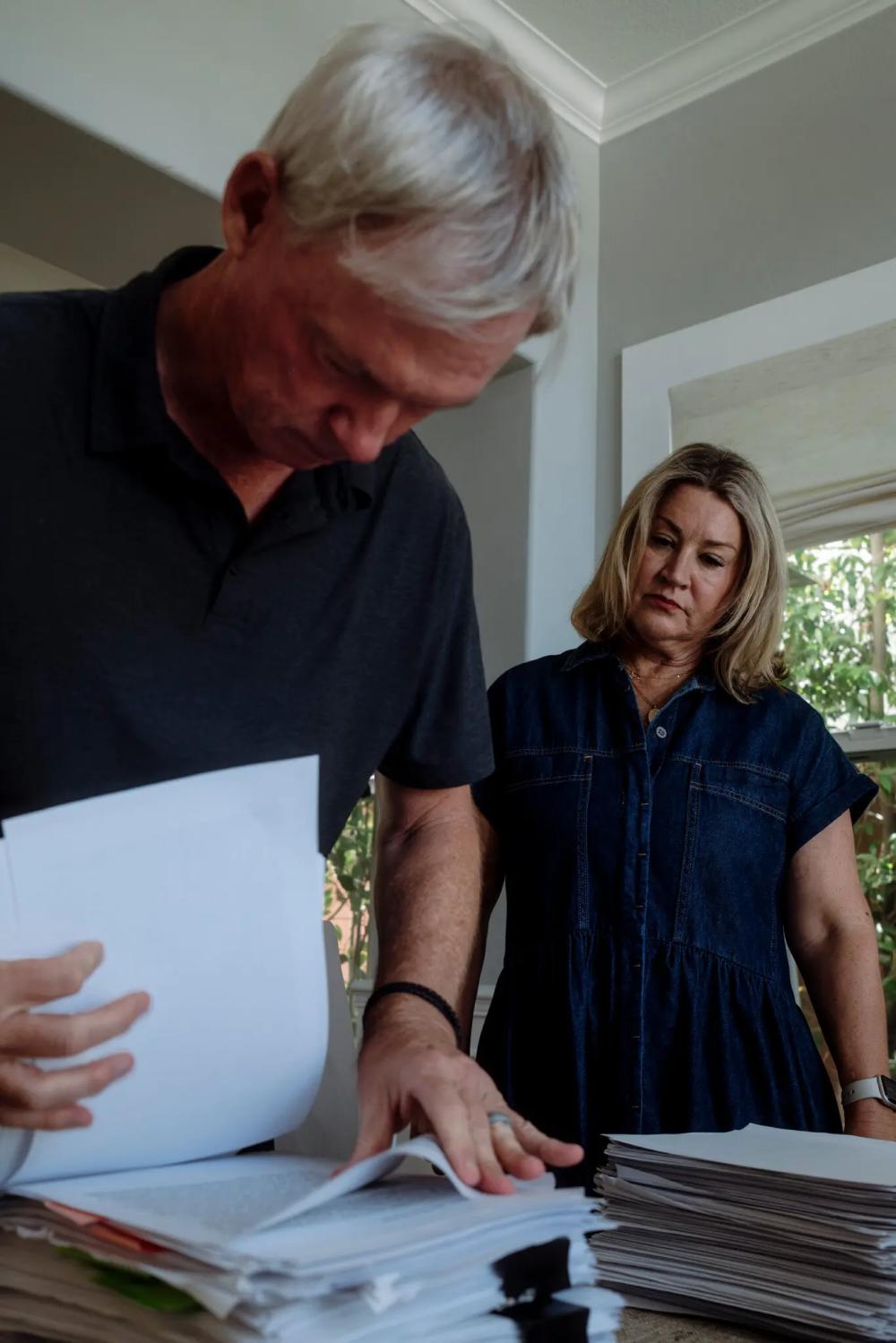

图:雷恩夫妇将儿子与ChatGPT的对话按月份打印整理,其中三月的对话记录最多,而亚当在4月11日离世

02 全球心理实验:当AI成为7亿人的“秘密知己”

ChatGPT问世三年,周活跃用户超7亿,还有其他聊天机器人被数百万用户使用。

这些AI工具从“增强版搜索引擎”变成个人助理、情感伴侣甚至“虚拟心理医生”,但其影响有争议。有调查显示使用AI伴侣反馈积极,也有研究指出高频使用会让人孤独、社交能力下降。

更令人担忧的是,用户与AI的“妄想式对话”可能诱发躁狂或精神病发作,已有自杀与暴力案例引发对AI安全机制的质疑。

雷恩夫妇指控ChatGPT有“产品安全隐患”,OpenAI回应聘请专家强化安全,增设未成年人防护机制。

OpenAI应用主管称亚当的对话暴露安全机制问题。许多聊天机器人检测到自杀话题会推荐心理热线,但专家指出AI缺乏理解力和行动力。

OpenAI曾纠结自杀讨论处理方式,最终选择折中方案。亚当母亲崩溃于ChatGPT未在儿子濒危时报警。

专家建议AI公司人工审核高风险对话,但可能侵犯隐私。OpenAI称仅在四种情况下查看记录。

聊天机器人不是自杀信息唯一来源,但研究员指出其“个性化响应速度”风险更大。测试发现部分AI能拒绝讨论自杀,付费版ChatGPT却提供危险信息。研究员发送研究结果未获回复。

03 法律挑战:如何证明AI对自杀负有责任?

图:雷恩夫妇决定起诉OpenAI,因为他们坚信该公司的聊天机器人技术存在安全隐患

亚当离世后,雷恩夫妇成立纪念基金会,读完对话后决定警示AI技术风险。

他们通过朋友联系上“科技正义法律项目”总监米塔利·贾因,贾因曾代理类似案件。如今,贾因与律所代表他们起诉OpenAI。

法律维权困难,当前法律对网络服务在用户自残事件中的责任认定有空白。雷恩夫妇认为ChatGPT加剧亚当心理危机,关键节点还阻止他向家人求助。他们坚信没ChatGPT,亚当还会活着。

04 当AI戴上“人类面具”,OpenAI的安全承诺还有效吗?

周二,OpenAI发文展示ChatGPT处理心理健康危机的能力,但文章将AI“拟人化”。

文中称ChatGPT能“识别痛苦”等,但它本质是模式匹配系统,“共情”回应只是文本组合。这种“拟人化”可能伤害心理脆弱用户,亚当对话中ChatGPT主动提“自杀”次数是他的六倍。

OpenAI承认长时间对话中ChatGPT安全措施会崩溃,这暴露Transformer架构局限。对话延长,模型维持安全措施能力下降,还会丢失关键信息,导致安全漏洞。

亚当案例中,系统防护减弱,他得以操控ChatGPT获危险建议。

面对问题,OpenAI表示与医生讨论,计划推家长控制功能,还想将ChatGPT打造成心理健康平台。但亚当使用的版本有问题,新版改进有限,难担心理健康平台重任。

打破AI“回声室”需外部干预,但对深陷依赖的用户可能太晚。企业注重“用户黏性”,打破危险情感依赖更难。

本文来自微信公众号“腾讯科技”,特约编译:金鹿,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com