英伟达Dynamo对决华为UCM!专家解读AI大模型推理优化

电子发烧友网报道(文 / 章鹰)近日,在2025金融AI推理应用落地与发展论坛上,中国信息通信研究院人工智能研究所平台与工程化部主任曹峰表示,在关注AI大模型落地时,一方面要看落地效果,另一方面,在行业应用中,AI大模型推理优化的价值日益受到关注。

大模型落地重心从训练转向推理,AI推理需求暴涨,推理算力需求爆发

中国信通院人工智能研究平台与工程化部主任曹峰分析称:“ChatGPT访问量呈线性增长,最新访问量达4亿。受益于中国AI大模型DeepSeek爆发,日均调用量快速上升。2025年1月起,中国AI推理需求增长20倍,未来三年算力需求将爆发。IDC表示,2024年算力需求60%用于训练,40%用于推理,到2027年中国用于推理的算力需求——工作负载将达72.6%。”

从消费端来看,AI手机、AI PC领域的AI模型调用量迅速上升。ChatGPT、豆包等APP软件,以及地图类、聊天类应用都接入了大模型能力。以Agent(智能体)为代表的消费类应用,还有基于大模型应用的AI硬件诞生,这些都带来了对大模型Token的海量需求和推理需求的上升。

此外,AI大模型在中国企业的使用率持续上升,智慧医疗、金融等行业的使用率也在增加。

推理复杂度不断上升,从简单的文本生成变为复杂的推理问题,如让AI分析7 - 8个PDF的核心观点。视频生成质量提高,短视频推荐从简单算法推荐变为生成式AI推荐,这些都促使推理算力爆发式增长。AI大模型推理在行业的落地越来越广泛,涵盖销售客服、办公助手和供应链管理等场景。

推理目标:从单点优化和功能完备,转向对于成本、性能和效果的协同优化

2025年起,多模态AI大模型发布增多,国内主流厂商支持智谱、通义千问等原生多模态开发,RGA、Agent等多模态引发了长序列推理需求。

曹峰分析道:“我们不仅需要推理,还需要高质量的推理。大模型产业化落地需要平衡成本与性能,针对不同场景进行推理优化是核心问题。大模型进入推理时代,多模态、长序列、MoE等模型趋势以及复杂落地场景要求推理优化。”

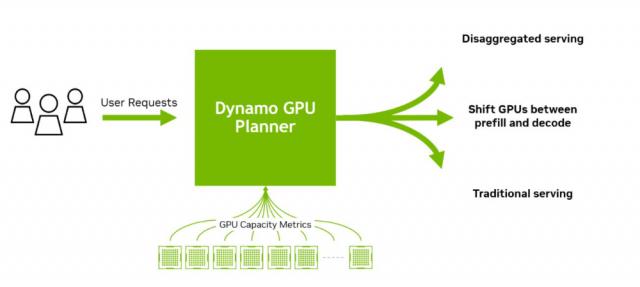

今年3月,英伟达在GTC上推出了NVIDIA Dynamo。它是一个高吞吐量、低延迟的开源推理服务框架,用于在大规模分布式环境中部署生成式AI和推理模型。通过分布式管理器,可提升长文本上下文推理效率。英伟达称,在NVIDIA Blackwell上运行开源DeepSeek - R1模型时,该框架最多可将请求数量提升30倍。

华为推出AI推理创新技术UCM(推理记忆数据管理器)和管理系统的算法。UCM是以KKV Cache为中心的推理加速套件,集成了多类型缓存加速算法工具,形成底层从南向北的开放式生态架构,有效提升了Token的吞吐率。银联的实际案例和大量测试显示,UCM显著降低首Token的时延,最高降低90%,系统吞吐率最大提升22倍,上下文的推理窗口可扩展10倍以上。我们需要在系统层面统筹考虑如何提高系统的推理效率。

如今,企业不再聚焦AI大模型的训练,而是将重心转向应用部署,如何高效率、低成本地部署和进行推理,以适配核心业务场景成为关键。华为刚推出的KV Cache已成为架构优化的焦点,以KV Cache为核心的推理方案不断涌现,背后依赖的高性能存储、先进调度策略的重要性愈发凸显。

更多热点文章阅读

点击关注 星标我们

将我们设为星标,不错过每一次更新!

喜欢就奖励一个"在看"吧!

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com