奥特曼:o1只是“GPT-2推理模型”;黄仁勋:我会加速你50倍

AI界最具影响力的两个人,同时出现在一个活动中:

OpenAI 奥特曼CEO,这意味着o1满血版将在接下来的几个月发布。

黄仁勋,英伟达创始人,这意味着新一代Blackwell架构GPU可以加速o1推理50倍。

奥特曼把O1在推理模型中的地位在语言模型中比较GPT-2阶段。

在过去的几年里,人们将会看到“GPT-4推理模型”,但最近几个月将会有很大的改善,新范式的进步曲线十分险峻。

L2的“推理者”和L1的“聊天机器人”很不一样。我们还没有找到如何使用这些模型,也没有决定继续为APP添加哪些功能。

但最令人兴奋的是L3“智能体”会来得很快。

有些医学教授看到这里,已经在考虑离职了。

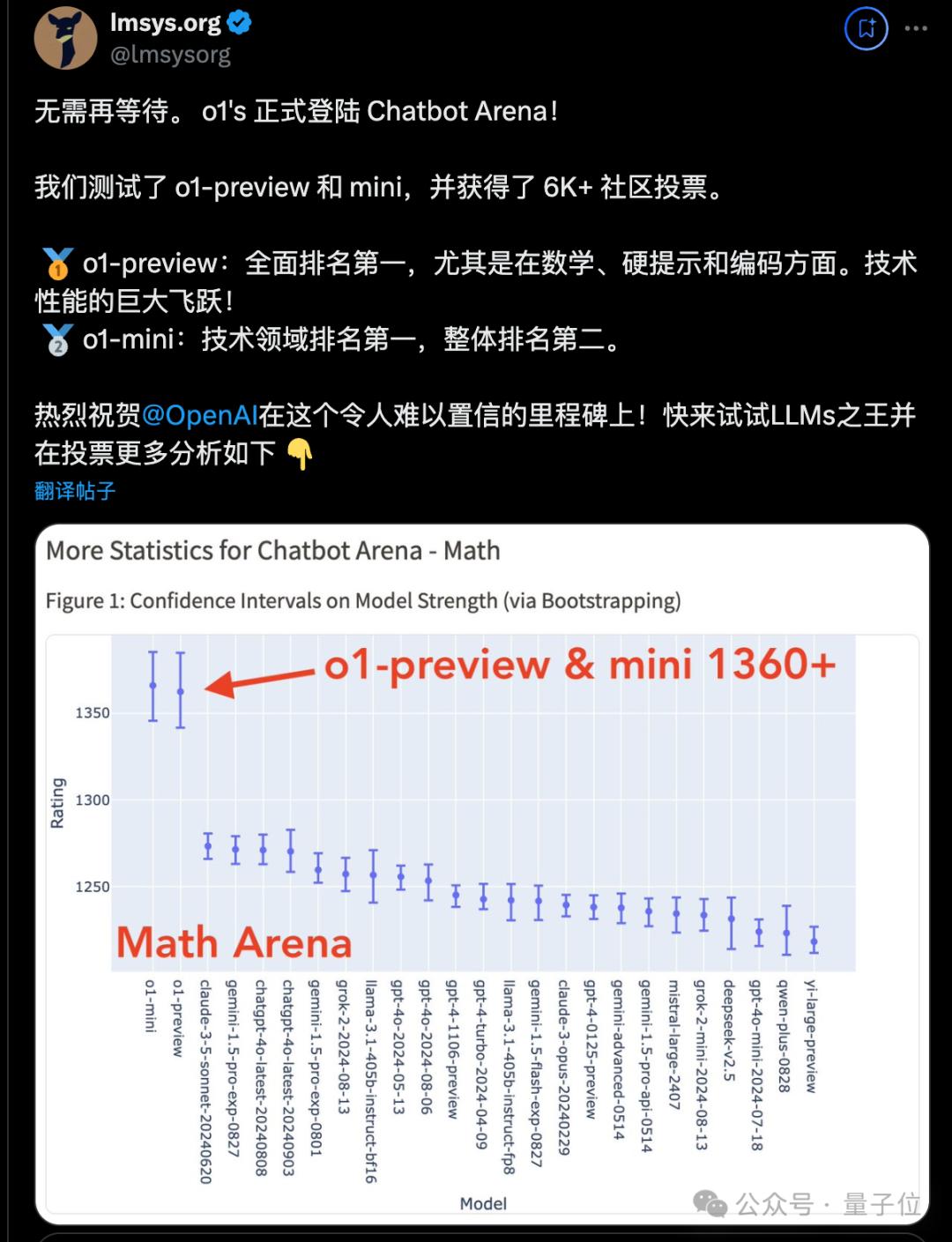

换句话说,o1系列正式登上Lmsys大模型试炼场,首次结果清算,断崖式的数学任务领先。,唯一的缺点就是答案有点慢。

对于这一点,老黄的看法是:

英伟达最新的Blackwell架构GPU将推理性能提高了50倍,这意味着o1模型的响应时间可以从几分钟缩短到几秒钟。

上述内容来自T-Mobile金融市场日,T-Mobile刚刚与OpenAI签署了一个大订单,合作建立了一个AI支持的客户服务系统。

然而,在这次活动中,除了几家公司的合作外,两位行业领袖还围绕AI的现在和未来分享了更多值得关注的内容。

对o1在数学、代码之外的任务表现如何,请看下面由o1主导、量子位协助整理的原文精翻。

奥特曼:OpenAI的秘诀是信念和专注。

主持人:首先祝贺大家推出o1模型,或许你可以把这个新模型介绍给观众,因为它真的很神奇。

Sam Altman:是的,我们对此非常兴奋,这也是我们长期以来一直在努力的方向。GPT系列模型在“系统1”类型的思维中表现出色,但我们真正想要的是一个可以推理的系统。

如果人工智能能够解决更复杂的问题,它的价值将是巨大的。你已经在GPT-4模型中看到了一些线索,但o1是第一个可以进行高级推理的系统。你可以得到非凡的结果,无论是复杂的编程挑战、数学问题还是科学问题。我们相信,随着时间的推移,它将像GPT系列一样重要,解锁一系列新的、有意义的使用场景。

主持人:您曾经公开表示,我们现在看到的是预览版,而且它会迅速迭代,未来几个月会发生什么?

Sam Altman:我认为现在的新推理模式类似于我们处于GPT-2阶段。在接下来的几年里,你会看到它的发展。 GPT-4 相当高。即使在接下来的几个月里,你也会看到显著的进步,随着我们从o1-preview升级到o1的官方版本。

在这些新范式出现的时候,我认为有很多有趣的事情,其中一个就是改善曲线很危险。有些模型目前无法解决的问题,也许几个月后就可以解决,几个月后就可以解决了。首先,我们将看到一套全新的使用方法,而不仅仅是聊天界面。建立这个功能需要一些时间,其他人也需要时间,顾客也需要时间来适应。它与GPT模型有很大的不同。

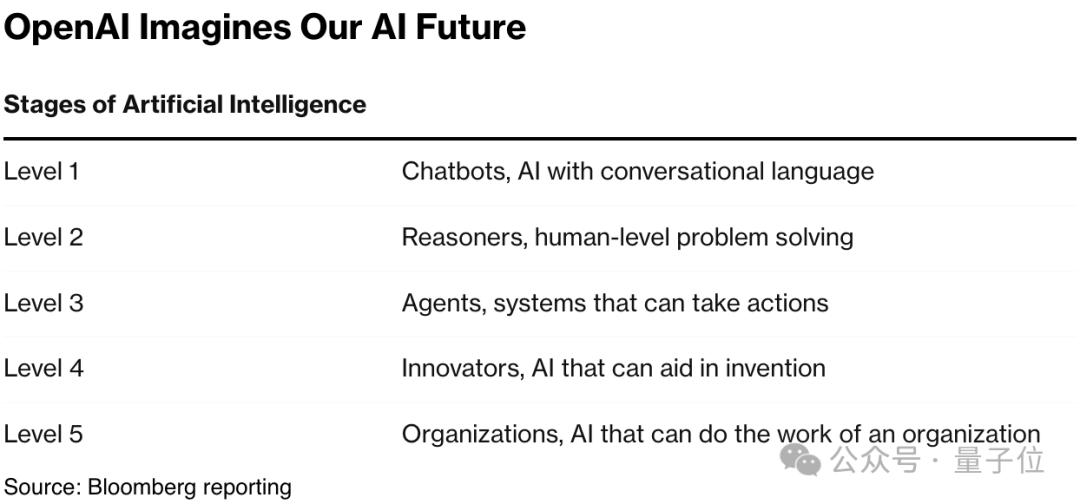

提到AI的五个等级:L1是聊天机器人(ChatBot),L2是我们刚刚到达的推理者。(Reasoner),L3是智能体(Agent),L4是开创者(Innovator),L5是一个完整的组织,可以发现新的科学信息。(Organization)。

从L1到L2花了一段时间,但我认为L2最令人兴奋的事情之一是它能够相对快速地实现L3。我们预计这项技术最终会带来非常有影响力的智能体。

(省略一段商业互吹)

主持人:稍微改变一下话题,为什么? OpenAI 能领先吗?每个人在这一领域都做了哪些不同的事情,让你能以这种速度开发这些模型?

Sam Altman:首先,谢谢你的赞美。这是一个非常好的评价。我们建立在之前大量工作的基础上。人工智能是一个古老的领域,我们长期以来一直在为它提供优秀的想法。想想人类历史上人们为了发现半导体、制造芯片、建立网络和这些大型数据中心所需的各种工作,我们只是在这些工作之上做了自己的一小部分。

但是我们尽最大努力做到最好,我们努力有一个非常专注的研究计划。我认为其他研究计划的错误之一是他们没有足够的信念和专注力。有些东西一旦发挥作用,就很容易复制。

因此,我认为成功的两种形式是,如果我们不成为一个优秀的快速跟随者,复制OpenAI或其他成功企业所做的事情,我不会以负面的方式说这话,因为我认为许多企业只是在等待看到什么是有效的,然后在改进和实施方面做得非常好。

不试图推动前沿,这是非常困难的。很多人需要在复杂的环境中有信念和专注力,这是最好的前进方式。这是我们努力做到的。

我们真的相信深度学习,我们真的相信从现在的位置到AGI和更远的道路,但我们愿意根据我们在这个过程中学到的东西来纠正。我们将继续努力,尽最大努力做下一件事,相信随着时间的推移,这将产生福利效应。

对于我们来说,这的确是有效的,方法就这么简单。

黄仁勋:年轻人将拥有伴随一生的机器人

(省略一大段商业互吹和T-mobile业务内容)

主持人:刚和Sam在一起 Altman谈到了AI的快速发展,其中之一就是AI需要极低的延迟和快速的响应时间。因为 AI 它正在从传统的文本形式转变为即时响应视频、面部情绪和与虚拟图像的互动,这需要很高的响应速度。未来的AI工作负荷需要在客户网络附近的计算能力。

黄仁勋:的确,我们现在将无线计算AI计算融入到一个结构中。我们建造的这台计算机延迟极低,CUDA延迟极低,可以处理时间敏感事务,提供高质量的语音服务。

我们没有意识到的是,全球无线网络非常冗余。冗余的原因是当有人需要的时候,他们必须提供高质量的服务。但是当没有人需要的时候,那些基础设施就闲置了,可以重复使用。

所以,当我们能够被软件定义、加速、处理AI的时候,我们现在就把整个网络转化为需要的时候其他机会的过剩容量。这将是电信行业的巨大新增长机会。

主持人:我很喜欢。在我们让你离开之前,我们还有几分钟的时间,让我们换个话题,谈谈你兴奋的事。

英伟达有一个不可思议的角度,因为所有处于AI前沿的人都在和你合作。当你思考如何真正改变人们生活中最具变化性的技术时,是什么让你感到兴奋?你认为AI会如何影响我们所有人?

黄仁勋:我们都会有大量的数字助手和我们一起工作。我非常喜欢这个想法。我会有一台电脑。随着时间的推移,它会和我一起工作,变得越来越聪明,理解我,帮助我实现我的目标。我喜欢我自己的R2-D2和C-3PO(星球大战中的机器人)。

我的R2会一直跟着我。对于许多年轻人来说,他们将拥有自己的R2,并与他们共度一生。R2可以是数字版本,也可以是物理版本。每个人都可以拥有这些惊人的助手,帮助我们度过生活,无论你是科学家、工程师、思想家还是普通人。

(对老黄对机器人的看法,马斯克也跑到评论区发表赞同。)

黄仁勋:最近,Sam提出了一个观点,认为这些AI的推理能力会变得更聪明,但是这需要更多的计算能力。当前,ChatGPT中的每一个提醒都是一条路径,未来将有数百条路径。它将进行推理,加强学习,并尝试为您创造更好的答案。

这就是为什么推理性能在每个人的Blackwell架构中提高了50倍。通过提高推理性能50倍,现在回答特定提示可能需要几分钟的推理模型可以在几秒钟内回应。因此,这将是一个全新的世界,我对此感到兴奋。

主持人:您如何看待能源消耗的变化?它是AI最受关注的一个方面,即碳足迹。

黄仁勋:为了降低能源消耗,我们必须使用AI。如今,我们知道,与使用传统的超级计算机相比,气候和天气预测的能源效率要高一万倍。摩尔定律的确走到了尽头,我们必须采用一种新的方法来解决这些计算问题。

我举的一个例子是,我的小狗不懂牛顿物理,也不懂球会以什么轨迹运动。众所周知,世界上第一台超级计算机是为了模拟导弹的轨迹而建立起来的。然而,经过一些训练,狗可以很容易地从空中抓住球,有时它们仍然在空中翻转。那么他们是怎么做到的呢?这是同样的想法。

所以,我们教AI不要用物理、动力学、流体力学等方法来计算天气,而要教它预测。也许逻辑关系还没有完全理解,但是它的预测非常出色。只是想知道明天的天气会怎样。这个例子就是这样。对于无线电网络,我们要做同样的事。了解电磁基本物理,了解电磁波束如何反射、映射,如何处理不同的环境,了解波束成型的物理原理。

但是,当你运营互联网时,你只是试图以更低的能耗、更高的吞吐量和更低的成本提供更好的服务质量。因此,你不需要立即模拟基础物理,只需要使用AI即可完成。这种模拟是通过理解第一原理来进行的,然后使用 AI 通过模拟这一基本理解原则,可以大大降低能源消耗。

训练模型确实需要大量的能源,这是人们需要意识到的。但是,目标不是训练模型,而是使用模型,这样可以节约大量的能源。

One More Thing

黄仁勋还在Salesforce同期举办的另一次活动中分享了这一观点:

技术进入正反馈循环,AI正在设计下一代AI,进度达到摩尔定律的平方。

也就是说,在接下来的一到两年里,我们会看到的。惊人的,出乎意料的进步。

视频回放:https://www.youtube.com/watch?v=r-xmUM5y0LQ&t=5145shttps://www.youtube.com/watch?v=kfe3ajUYSdc

本文来自微信微信官方账号“量子位”(ID:QbitAI),作者:梦晨,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com