七十三年前,香农为大型发展埋下了一颗种子。

AI 考古学,追溯到祖师爷头上。

当今 AI 在大语言模型领域爆红(LLM),它的原理是香农提出的?

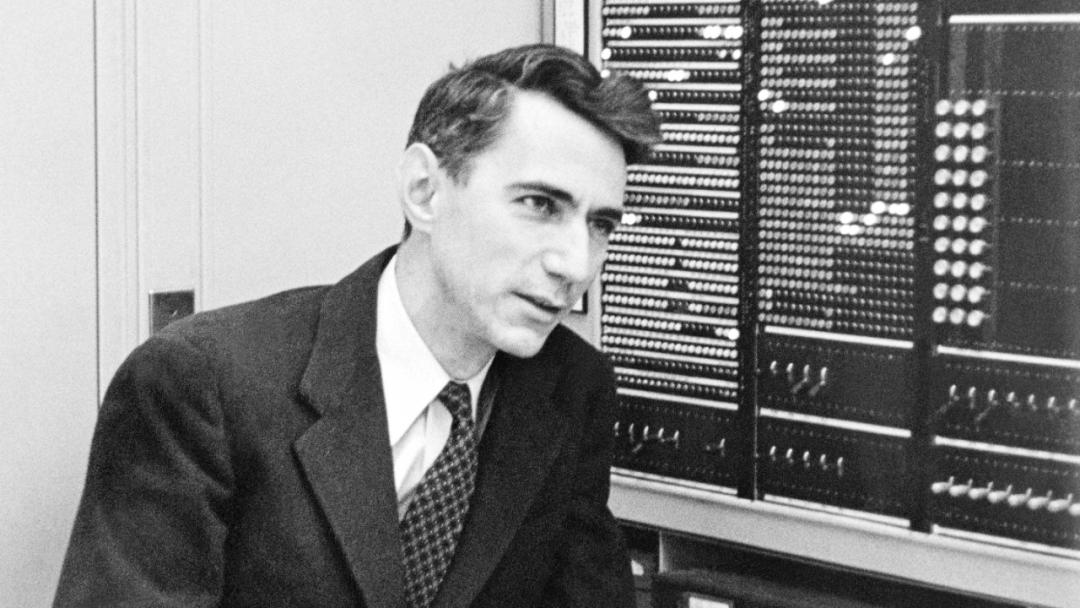

今日,普林斯顿大学教授承担了严峻的责任(Sebastian Seung)抛出这样一个观点:1951 2008年,在贝尔实验室(总部位于新泽西州 Murray Hill)克劳德的工作・香农提出了预测下一个单词的问题,这已经成为目前的大语言模型(LLM)种子。

如今,许多看似时尚前沿的概念实际上已经被提出了几十年。即使在计算机科学等新兴领域,例子也并不少见。这一观点及其提及 Murray Hill 引发热议,图灵奖获得者,Meta 首席科学家 LeCun 表示,新泽西州 Murray Hill、Florham Park 和普林斯顿都「诞生」做了很多有影响力的工作。

LeCun 还列出了许多著名的研究成果:

- Hopfield 网络(美国科学家) Hopfield 与此同时,我在贝尔实验室和普林斯顿大学工作。

- ConvNets

- Boosting/Adaboost

- 非负矩阵分解

- svm算法(SVM)和核机

- 结构化预测

- 计算学习理论 / VC 大量的理论内容

所以说在这其中,香农给现在通向了现在。 AGI 这个大模型起了个头,是怎么回事?

讨论中提到的 IT 祖先克劳德・香农论文是这样的《Prediction and Entropy of Printed English》。

论文链接:https://www.princeton.edu/~wbialek/rome/refs/shannon_51.pdf

该研究于 1951 年 1 每月发表在期刊上《The Bell System Technical Journal》到目前为止,已经被各界学者引用超越。 4000 次。

在这篇论文中,香农主要讨论了如何估算语言熵。(entropy)和冗余度(redundancy),并且提出了一种新的方法。

其中:

语言熵是检验每个字母平均值产生的信息量的统计参数。如果语言最有效地转化为二进制数字(0 或 熵表示每个字母平均所需的二进制数字数量。

由于语言的统计结构(如字母频率、特定字母的后续趋势等),冗余度衡量了文本的限制。

当你定义熵和冗余时,你可以选择应用这些概念。在他的文章中,香农给出了两种估计英文熵的方法。冗余,或者对英语文本施加的约束数量,导致其整体熵减少。比如,规则「i before e except after c」,以及 q 必须始终跟 u 事实上,依赖关系使英语更加冗余。我们不能编造词汇的语法规则、词性和事实也使英语变得冗余。

有时候英语的冗余其实是有益的,因为不然你怎么能分辨出你在嘈杂的房间里说了什么?冗余允许人们在只有一些信息来源时推断他们所说的话。例如,如果你听到了「Turn phat mufic down!」,人能很好地猜测演讲者的意思。

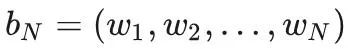

一种可以用来计算英文熵的方法 N-gram。

给予自然语言 L 足够长的字符序列 S,调查所有长度为 N 的子字符串

定义 N-gram 熵(Entropy)FN 如下。

当已知前 N - 1 在一个字母中,我们可以对下一个字母的熵进行统计。随着 N 熵的增加接近 H,这就是英语熵。下面是香农文章中计算的值。FN 是当已知前 N - 1 字母时和第 N 与字母有关的熵。计算 FN 很难统计数据 O (26^N),因为有那么多 N 字母序列。请注意,F0 只是字母集的最大熵,每个字母的概率都是一样的。

27 一个字母的序列,空格也被认为是一个字母。空格几乎总是可以添加到没有空格的单词序列中。因此,空格基本上被认为是多余的。如果考虑空格,计算出的熵值会更低。只有在没有统计数据的情况下,也就是 在加入空格之后,F0的熵会更高。它只是增强了另一个可能的符号,这意味着更多的不确定性。

香农建议的另一种策略是计算与英语中每个单词相关的熵,然后取加权平均值。香农使用类似的函数估计超过 8000 单词熵。他得到的每一个单词的熵值 11.82 bit,由于每个单词都有平均值 4.5 字母,所以每个字母的熵是 2.62 bit。这个在上表中 Fword 给出。

我们已经讨论了如何从熵中计算冗余。当所有符号都有相同的概率时,最大的冗余等于 - (log2 (1/26)) = 4.7 bit / 字母。所以,使用公式 1 - H/Hmax,我们可以估计英语的冗余程度。香农最初估计这个值 50%,这意味着大约一半的英语字母是多余的!

在同一篇文章的后面,我们讨论了一种非常巧妙的计算英语熵的方法。它结合了更多的英语特点,如统计方法无法清晰解释的思路和前后文本。

然后就是现在我们在这里 NLP 经常提到的概念:假设人类可以根据之前对这种语言的理解来猜测单词或句子中的字母。香农的巧妙想法是利用这种自然冗余度来评价指标... 人的思想。

他要求受试者逐一猜测句子中的字母。假如受试者猜对了,那么他 / 于是她继续猜测下一个字母。如不是,请告知受试者下一个字母。这是一个句子 129 69%的字母 被猜对了。也就是说,英语的冗余大约是多余的。 69%。假定我们只能再现那些错误的字母, 31%。然后我们可以通过复制重新开始猜测的受试者来恢复原始语句。显然,受试者可以正确猜测。 69% 还有他的符号 / 剩下的她都有了 31%,所以他 / 她可以只使用大概 31% 再现原始文本的信息。

实际上,受试者需要的信息略高于 31%。他 / 她需要了解他 / 他会猜到错误的字母在哪里,所以实际上冗余可能会少一些。从理论上讲,这是一个很好的例子,但实际上并非如此。句子与受试者的抽样误差会导致严重的失真。即便如此,这个例子也有助于显示一个冗余的实际例子,并且明确了如何编码英文。人类生来就有语法,不需要建立英语统计语法来计算其熵。

对英语冗余进行统计计算有许多实际应用。ASCII 保留每一个字符 8 二进制数字。但是,考虑到一些计算将英语熵定为大概。 1 位 / 字母,这是非常低效的。也就是说,理论上有一种压缩方案,其压缩效果是 ASCII 的 8 倍。现代化的计算机显然有足够的内存,所以这种低效率并不重要,但是 Huffman 压缩和 Lempel-Ziv 在存储文本时,压缩算法可节省大量空间。

一般而言,当我们说英语是冗余的时候,他们指的是大量的同义词使我们的字典变得凌乱。在信息论意义上,冗余是对字母的检验。 / 语言中使用符号效率的指标。英语是一种冗余的语言,不一定是坏事。除了效率之外,我们的语言不仅可以口语写作,还会带来很多问题。在嘈杂的房间里,我们也希望能被理解,我们希望单词的发音与意思相对应,我们希望能快速发音。信息只是英语分析的一小部分。

一个很有意思的例子可以说明一种语言在统计上能有多好的描述,也就是英语 n 阶级相似,这是香农最著名的论文。《A mathematical theory of communication》里提到的。假如一只猴子知道英语中的字母 n-gram 频率(其中 n 非常大),它能写出可靠的英文文本吗?另外,这只猴子「懂」英语吗?如果 N-gram 猴子在一扇门后面,而人类在另一扇门后面,第三方观察者能分辨出哪一只是猴子吗?这一问题让人想起了人工智能图灵测试,它没有简单的答案。

然而,今天的大模型原理是通过学习大量的文本数据来预测下一个单词或下一个段落的概率,从而使计算机更好地「理解」并产生人类语言。

AI 你明白了吗?很难说。但是你能猜对吗?看看现在的 ChatGPT,在人们心中已经有了答案。

那也不禁让人感慨,香农的确领先于他的时代。

参照内容:

https://x.com/SebastianSeung/status/1807395697718604225

https://news.ycombinator.com/item?id=35813991

https://cs.stanford.edu/people/eroberts/courses/soco/projects/1999-00/information-theory/entropy_of_english_9.html

本文来自微信微信官方账号“机器之心”(ID:编辑:泽南,杜伟,36氪经授权发布,almosthuman2014)。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com