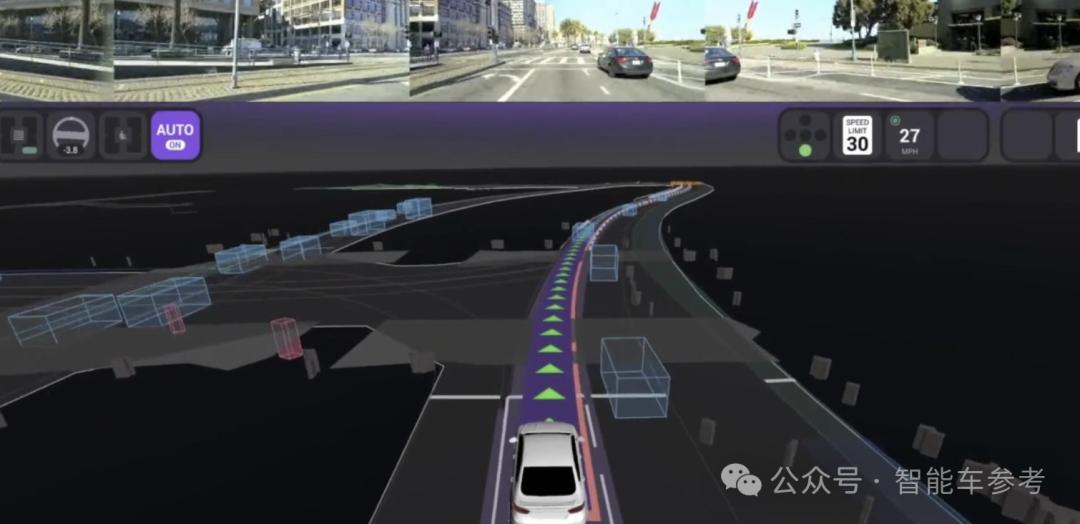

清华学生再次登Nature研究:三种解决自动驾驶“稀疏灾难”的方法

清华同学,自动驾驶最新研究成果再次登陆Nature。

去年,Nature杂志罕见地将封面“模拟效率提高2000倍”给自动驾驶研究——这也是这个团队的成就,成为自动驾驶圈热议的重大突破,智能汽车参考也详细介绍了。

在Nature子刊上发表了这项新研究《Nature Communications》,关注更底层、更核心的AI技术难题:

稀疏灾难。

讨论了什么?

有点“高深莫测”,稀疏是什么东西,怎么会成为自动驾驶的灾难?

严格的定义如下:

安全关键事件在高维变量空间中的稀疏程度。

通俗地说就是,在用于给AI司机的训练数据中,真正有用的并不多。。

比如汽车公司和自动驾驶公司经常说自己有几百万公里的实测里程,或者模拟测试里程超过1亿,但都避免了关键问题:

在这些信息中,真正提高系统能力的关键是什么?

举例来说,自动驾驶在平直无车的高速公路上检测数百万公里,可能没有在城市中遇到一个“鬼探头”那么大。

关键场景的查漏补缺,业界通常称之为“长尾场景”。

现在一般有两种解决方案,一种是大力创造奇迹,尽可能多的汽车,尽可能多的道路,期望最大限度地覆盖各种罕见的交通状况,让自动驾驶能力从量变积累到质变飞跃。

事实上,包括现在已经成为行业共识的端到端技术体系,本质上仍然是通过这种思维解决问题,只是将整个自动驾驶过程中更多环节的权限移交给AI。

另一种是在有限的计算率和参数限制下,用人为手写的规则,在自动驾驶的极限前提下,通过降级或刹车来覆盖自动驾驶的“安全壳”。这是目前大多数量产智能驾驶的方法,但缺点是显而易见的:系统决策僵硬僵化,泛化性差,感觉更差。

不知道大家有没有注意到,无论是哪种方式,也没有在AI算法层面分析“稀疏”的本质,自然无法提出有针对性的解决方案。

在论文开头,作者直接指出了这一问题:

虽然在公共道路上积累了数百万英里的检测里程,但自动驾驶仍然很难有效处理频繁发生的“安全关键事件”。可以商业使用的L4永远不会落地。

因此,“稀疏”被称为“自动驾驶灾难”。

新研究处理稀疏度灾祸方法是打开AI黑箱,尝试用数学来表达稀疏的本质,并提出三种相应的解决方案。

怎么办到的

具体而言,作者认为传统中比较重视。安全性关键事件的概率分布,实际上并不是核心。

相反,真正的挑战在于如何定义高度复杂的场景。安全性关键条件的稀有性,例如,不同的天气条件,不同的道路基础设施,以及道路使用者的行为差异…

这些安全的关键情况可能会因为各种原因而发生,比如误识别未知物体,或者误预测周围行人的运动轨迹...这些事件发生的概率很低,大多数可用数据只包含罕见的事件信息。

因为罕见事件的珍贵信息可能会被广泛的正常数据所掩盖,所以深度学习模型实际上很难有效地学习这些安全关键事件。

重点来了。深度学习的本质是通过优化目标函数对具有特定分布的数据的期望,从而获得神经网络的最佳参数。

为解决这一优化问题,最常用的方法是基于梯度下降,在每一个训练步骤中使用一批数据。蒙特卡洛估计来估算梯度。

但是,随着安全关键事件的罕见性增加,估计方差会呈指数级增长,造成“稀疏灾难”。

有三种解决方法。

首先是有效地训练使用更多罕见的事件信息。

这种方法侧重于数据,专门利用与罕见事件相关的数据来不断提高系统能力。但是定义和识别罕见事件就没那么简单了。因为它依赖于特定的问题目标函数,受到安全关键事件时空复杂性的影响。更重要的是,学术界仍然缺乏理论基础来指导罕见事件的数据利用。

对这一安全验证任务,团队以前试图通过密集深度加强学习。 (D2RL) 处理方法(即登上Nature封面的研究),实验结果显示,D2RL 能显著降低策略梯度估计的方差,这就是处理方差。 CoR 这是一个重要步骤。

其次是提高机器学习模型的泛化和推理能力。实际上,作者在这里讨论的就是AGI问题,目前在自动驾驶领域最先进的尝试就是端到端模型。

人类可以在有限的经验下学会驾驶(通常不到100小时的练习),所以未来的AI可能会克服它,而不依赖大量特定的任务数据。 CoR。AI需要同时具备自下而上的推理(感知数据驱动)和自上而下的推理(认知期望驱动)能力。

可参考大型语言模型 (LLM) 以及视觉语言模型 (VLM) 该方案通过运用完全监管微调、情景学习、思路链等技术,展现了其基本模型的优异泛化和推理能力。

第3种方法,是通过减少安全关键事件的发生,减轻CoR对整个系统的影响。

说白了,就是尽量减少系统对情景和目标的错误检测。有很多具体的方法,比如结合传统的深度学习模式和强化学习思想,训练AI“预防性驾驶”能力、多传感器车路协同融合,车云一体化方案等等。

三种处理 CoR 潜在的问题方法,从不同的角度出发。但作者强调,这些方法并不相互排斥,结合起来会有很大的潜力。

意义何在?

CoR的影响不仅仅局限于感知阶段,而是渗透到自动驾驶的每一个过程中,一步一步积累起来。一旦出现极低概率的安全关键情况,可能会导致严重后果。

例如,单帧中物体的分类错误可能不是什么大问题,而是一系列帧。(clips)这类事件的发生概率远低于任何单一错误的发生概率,因此,其中多个物体分类错误可能导致严重的错误识别和错误判断, CoR 问题越来越严重。

从轨迹预测的角度来看,一个小小的预测错误可能会导致报告或遗漏,从而导致过于谨慎的驾驶决策或过于自信的决策导致事故。因此,行为预测模型必须有效处理容易发生CoR的罕见事件。

在决策阶段,由于过去现实世界数据的缺乏和随机性,深度学习模型很容易受到CoR的影响,这可能会导致战略梯度估计的严重差异。

自然,由于CoR的出现,理论上自动驾驶的安全系数需要数亿公里才能评估出来,这是脱离实际的,效率低下的,这也是为什么模拟测试成为主流的原因。但问题是,目前很多方法仅限于处理目标有限的短场景,无法捕捉现实世界安全关键事件的所有复杂性和多变性。

所以CoR虽然不是一个看得见、摸得着的bug,但是危害深深地渗透到自动驾驶的每一个环节。

这项新研究最大的意义在于解释了CoR的数学性质,并提出了几种可能的解决方案。

介绍了作者团队

这项研究由美国密西根大学和清华大学的研究人员共同完成。

一个作品,通讯作者刘向宏现任美国密歇根大学讲座教授、Mcity主任(由密歇根大学主导的智能交通模拟城市项目)博士。

作为滴滴前首席科学家,他在国内最为熟悉。

刘向宏1993年毕业于清华大学汽车工程系,2000年在威斯康星大学麦迪逊分校获得博士学位。

作为交通工程领域论文引用率最高的学者之一,刘教授发明了SMART-Signal系统,该系统在2012年获得了美国国家专利,并在明尼苏达州和加州得到了广泛的应用。

本文共同作品,通讯作者封硕,现任清华自动化系助理教授,曾经是刘向宏教授的Traffic 作为博士后、研究员的Lab。

清华大学自动化系获得封硕本科和博士学位,研究方向为优化控制、互联、自动驾驶评估和交通数据分析。

从封硕和刘向宏教授团队过去公布的成果和研究方向来看,他们不断推进自动驾驶安全验证评估和模拟测试的优化和完善。

例如,我们之前报道的D2RL,就是通过强化学习方法的目的来生成高价值的数据,从而提高模拟测试的效率。

有趣的是,无论是自动驾驶还是智能汽车行业从工程实践出发,还是大学学者从数学原理上抽象总结,都指向了AGI。、端到端,数据驱动路径。

所以端到端会是自动驾驶的最佳解决方案,还是会是自动驾驶的“历史的终结”?

本文来自微信微信官方账号“智能汽车参考”(ID:AI4Auto),作者:贾浩楠,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com