字节大模型大降价,百度、阿里能抵抗吗?

作者|谢涵

编辑|陈秋

操作|陈小妍

另镜(ID:DMS-012)

去年3月,在OpenAI推出GPT-4一天后,华为、百度、阿里、腾讯、科大讯飞、商汤等国内众多龙头企业迅速布局了AI大模型跑道,但备受期待的字节跳动AI大模型业务并未向公众公布具体战略。

一年多后,字节跳动终于宣布,5月15日上午,字节跳动旗下云服务平台火山发动机在北京举行了一场巨大的新闻发布会。火山发动机总裁谭待在新闻发布会上正式宣布,为字节跳动自主研发的大型豆包提供服务。

根据火山发动机总裁谭待的说法,经过一年的迭代和市场验证,豆包模型正在成为国内使用最多、应用领域最丰富的大型模型之一,目前每天处理1200亿Tokens文本,生成3000万张照片。

据发布会披露的数据显示,豆包用户数量正在迅速增加,月活用户数已达2600万,建立了超过800万个智能体。

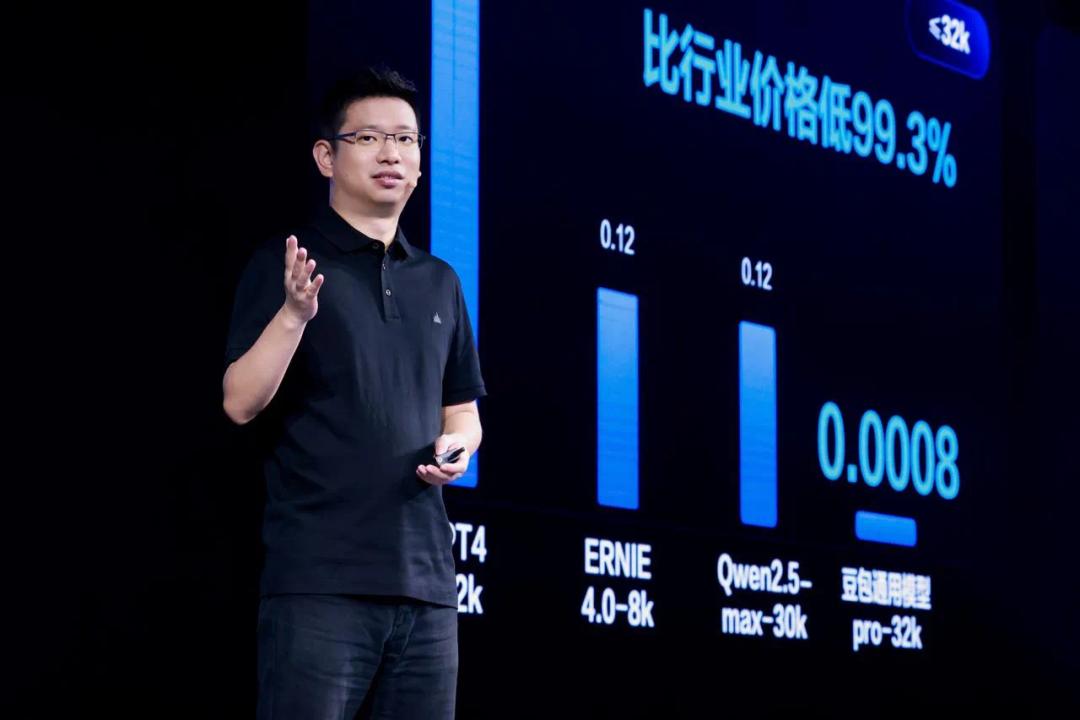

与目前国内外最新的32K主力模型相比,GPT4的价格在0.42元/千Tokens左右,百度文心一言和阿里最新的通义千问2.5价格接近0.12元/千Tokens,而豆包通用模型pro-32k版推理的输入价格仅为0.0008元/千Tokens,低于行业99.3%。

就长文本而言,阿里和百度目前还没有跟进长文本128k,GPT4-Turbo的价格在7分钱/千Tokens左右,豆包通用模型Pro-128K模型的价格在0.005元/千Tokens之间,比行业低95.8%。

这是什么概念?很多人都读过《三国演义》,总共有75万字。按照火山引擎公布的价格,一元钱就能买到125万Tokens的豆包主模,大概有200万个汉字,也就是说三国演义的字数只需要1元钱就可以处理。

说起低价策略,火山引擎总裁谭待在发布会当天下午的群访中向另镜等媒体解释说:“我们对技术还是有信心做出这个定价,这是最重要的,而不是我们用亏损做到这一点,亏损是无法接受的。”

我们在技术上有优化成本的手段,比如分布式推理、混合调度等。未来我们可以继续以这个价格服务行业,亏损和收入是不可持续的,所以我们不会这么做。能力最强的主模价格低于行业。简单来说,就是因为我们能做到,也需要做到。

应用程序必须生态繁荣,市场面临相当大的不确定性。试错成本要降得很低,这样大家才能普遍使用。无论是大企业还是开发人员,都可以使用,所以市场的声音是我们应该降低成本的关键。

谭待表示,随着大型模型技术的不断进步,企业和开发者都在积极实践大型模型,各种情况准备就绪。今年,大型模型技能的提高和应用是一个非常重要的阶段。我们判断,未来一年,从POC阶段到真实生产体系,大型模型将会越来越多。

一年前,字节跳动完成了自主开发的大模型。豆包大模型的原名是云雀,这是中国第一个通过算法备案的大模型之一。它在内部被亲切地称为豆包。

在过去的一年里,豆包被广泛用于字节内50多项业务的AI创新,包括抖音、头条、西红柿小说等产品。同时,火山发动机也通过邀请测试与不同领域的头部客户进行了基于豆包模型的深度创新,包括手机、汽车、金融、消费、互娱等领域。

拉响价格战

谭待在新闻发布会上首次阐述了字节跳动在模型中的战略布局,如何迅速占领中国市场。

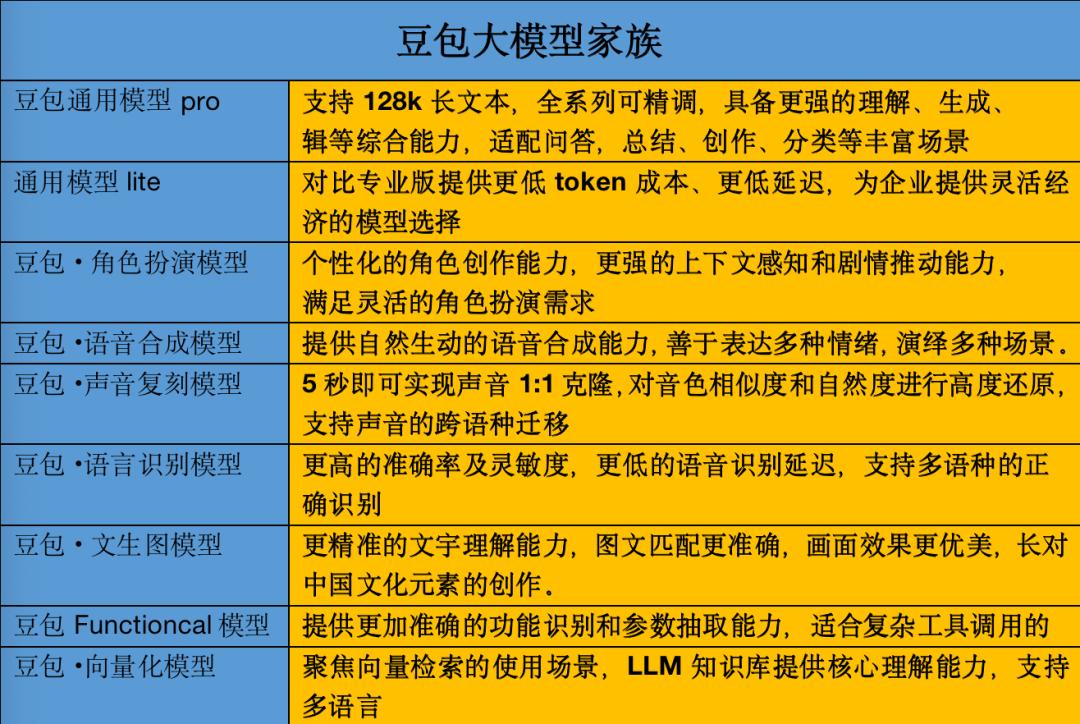

首先,这个节跳动自研豆包模型提供了一个多模态能力模型家族,目前主要包括通用模型pro。、通用模型lite、九种模型,如语音识别模型、语音合成模型、文生图模型等。在这些模型中,通用大模型支持128k长文本,还包括轻量级大模型和当前非常流行的文生图等垂类大模型。可以看出,虽然对外宣布较晚,但是低价策略和矩阵玩法足以撼动行业格局。

第二,在市场定位方面,字节跳动抛出了一张王炸牌,那就是卷起行业价格战。价格定位不仅比国外GPT4低很多,而且比百度文心和阿里通义的话低很多。

谭待表示:“只有大量使用,才能打磨出好的模型,大大降低模型推理的产品成本。企业市场上豆包的主要模型价格只有0.0008元/千Tokens,0.8%可以处理1500多个汉字,比行业便宜99.3%。”谭待表示,大模型将以更低的成本助推企业加快业务创新。

谭待认为,降低成本是促进大模型快速进入“价值创造阶段”的一个关键因素。大豆包模型的定价明显低于行业价格:以pro-32k版为例,大豆包模型的输入价格仅为0.0008元/千Tokens。而且市场上同规格模型的定价一般为0.12元/千Tokens,是大豆包模型的150倍。

第三,依托50多条内部业务线和前期大模型,字节大模型从早期预训练战场迅速进入情景融合和商业化阶段。

发布会当天,火山发动机与中国电动汽车百人会、吉利汽车、长城汽车、捷途汽车、赛力斯、智己汽车等20多家厂商合作,宣布成立汽车大型生态联盟,致力于为消费者带来汽车全场景AI的新感受。

与此同时,火山引擎和OPP、vivo、荣耀、小米、三星、华硕宣布成立智能终端大型联盟。OPPO小布助手、荣耀智能办公智能助手、小米“小爱同学”、华硕笔记本豆丁AI助手等应用已经接入火山引擎大型服务。

技术路线的背后

目前,豆包模型已在智能终端、汽车、金融、社交娱乐、在线教育、电子商务零售、科研、公司服务和法律行业九个领域进行实践。

不同领域的数据与垂直模型有很大的不同,大模型背后的技术难度可想而知。

火山发动机副总裁、字节跳动开源委员会负责人张鑫指出,大模型的出现使AI从“快思维”进入了“慢思维”阶段,从图形界面到自然语言,从代码到提示/图纸的开发模式,从“碎片化”到“统一”的R&D模式,从Copilot到Agent的效率感受四大变化。

然而,面对变革带来的新发展机遇,公司面临着交互不善于深度推理、知识不可追溯、实时更新成本高等挑战。当数据驱动的大型商业应用落地时。

面临上述新的挑战,火山引擎提出了四个破局方案。

张鑫分享说,首先要做好提示词工程的良好实践,掌握这个最高杠杆的技能;其次,从知识库建设和检索两个角度,构建企业大脑,做好检索和增强生成。(RAG);

第三,依靠知识地图能力增强大模型,实现知识和数据的一体化翅膀;最后,任务拆解的大模型是通过prompt推广、知识增强、调用插件、循环迭代等方式工程化的。

张鑫指出,基于四大破局方案,火山发动机通过沉淀良好的实践,推出了面向业务人员的一站式大型服务平台火山方舟和专属AI应用创新平台HiAgent,全面帮助企业实现大型破局的标准化、敏捷化和自动化。

谭待表示,火山引擎致力于成为AI时代最开放、最先进的云服务平台。新升级的火山方舟2.0不仅提供了丰富的生态资源,如Tiktok、今日头条的搜索和内容插件,还提供了足够的计算资源和完美的灵活性,保证了客户业务的稳定性。

火山发动机算法团队还将支持豆包大模型的企业客户,分享模型优化和数据处理的实践经验,与企业客户一起探索AI转型的智能未来。

2023年6月,大型服务平台火山方舟正式发布。该平台提供模型调整、推理、评估等全方位功能和服务,提供丰富的插件生态和AI应用开发服务,通过安全可信的方案和专业的算法技术服务,全方位保证企业Al应用的落地。

火山方舟2.0,大大提升了模型效果、核心插件、系统性能和平台感受,帮助企业推动大模型的价值创造。

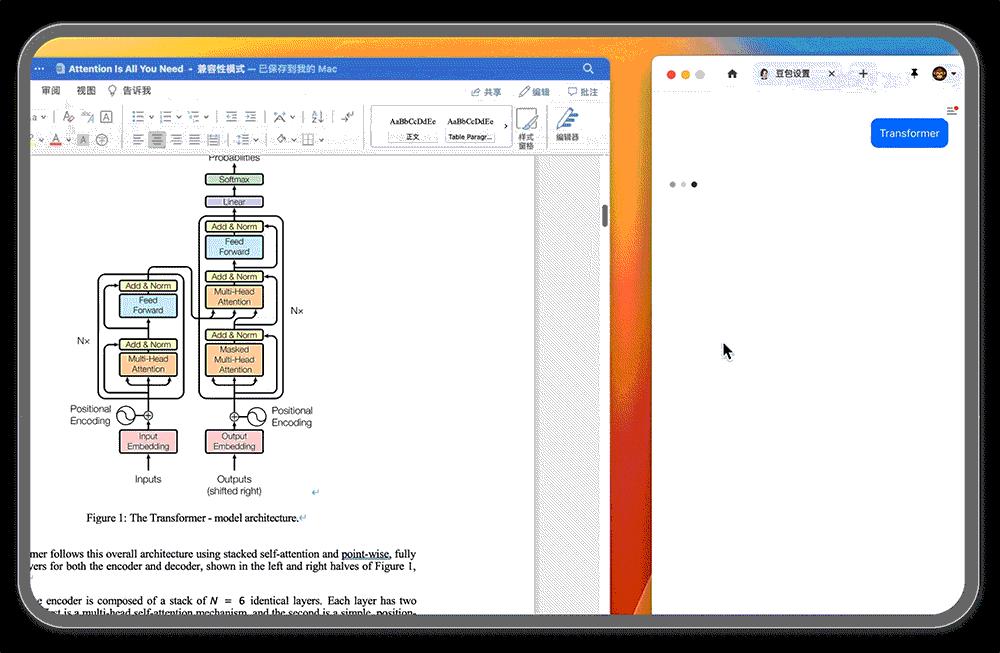

在本次发布会上,字节跳动还发布了新一代AI应用,搭建平台按钮,连接大模型和用户场景的按钮。无论用户是否有编程基础,基于大模型的各种Bot都可以在按钮上快速搭建,Bot可以发布到各种社交平台、通信软件或网站等其他渠道。

目前,按钮标准版已集成在火山发动机大型服务平台“火山方舟”上,提供企业级SLA和高级特色。招商银行、海底捞火锅、超级猩猩、狩猎等公司已经在按钮上建立了智能体。

此外,在本次发布会上,火山方舟还强调,2.0产品将进一步丰富插件生态,更新后的平台将推出三个插件-联网插件、内容插件和RAG知识库插件,这些插件凝聚了字节跳动的内部优势。

总结

近来,大型海外模型密集迭代,5月14日凌晨,OpenAI首次出现「春季新产品发布会」事实上,最新一代旗舰大型GPT-4o已经发布。与以前只会打字的语音助手和翻译相比,它变得更加智能,可以跨越语音、文字和视觉,超低时延,感知人类的情绪。

更加令业界震惊的是,它实际上是免费的,付费可以获得五倍的应用容量。价格方面,GPT-4o的价格是GPT-4-turbo的一半,而GPT-4-turbo的速度是GPT-4-turbo的两倍,速度限制也是5倍。

仅仅过了一天,5月15日凌晨,谷歌2024 I / OpenAI全面反击OpenAI大会,其中包括Geminini。 1.5 GeminninininiPro正式开通。 Advance用户,前后文窗口扩展到200万token,Gemma2.00推出开源模型、Imagen33文生图像模型、与Sora模型Veo相比,视频生成。

在中国,硝烟弥漫,各大互联网技术企业都在加快迭代大模型版本,寻找实现商业化的方法。字节发布了自研豆包模型,这也意味着国内大模型竞争的初步竞争格局已经基本形成。

在设计上,豆包大模型更倾向于拟人、贴近用户、个性化,其中一个主要特点就是可以直接从抖音中找到短视频来回答比较具体的问题。

未来,个性化设计、系统承载能力、模型训练能力、多模态性能和推理成本将成为每个企业不断跨越困难的问题。

目前,中国的大模型市场环境还处于起步阶段,正在努力扩大外部客户。许多客户仍处于与许多企业合作和接触的阶段。在早期阶段,互联网公司会更容易受到外界的关注,因为它们具有技术积累和流量生态的优势。然而,最终,任何能够领先于商业实现的道路仍然需要真正解决客户需求的能力。

2024年,国内大模型逐渐转变为行业大模型竞争,在模型框架、开发者工具、基本大模型、部署和推理工具等维度上开源和闭源并存。随着手机和汽车制造商相继发布芯片或模型,支持端侧AI推理,AI落地端侧也成为重要布局。

值得注意的是,2月份,抖音前CEO张楠从抖音转岗剪影,开始推出新的AI图片和视频产品。

5月初,张楠交出了转岗后的第一份工作——支持图片和视频产生的即梦AI,但官网显示还处于内部测试阶段。视频生成能力的初始版本,非会员只支持生成3秒。

谭待在本次发布会上直言,企业真正做好大模型落地并不容易。有三个关键挑战:第一,是模型效果,要处理复杂的问题,必须有一个好的基础大模型。二是推理的成本,只有极低的成本服务,才能使大型模型得到广泛应用。三是落地难度,需要更多的工具、插件、平台和应用,帮助企业在更多的场景中轻松落地大型场景。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com