群狼环伺!黄仁勋刚解中国市场困局,最大对手已悄然逼近

黄仁勋终于盼来了期待已久的转机。

本周美国政府正式批准英伟达向中国及其他“经批准客户”出口高端H200 GPU芯片,但需向美方缴纳25%的销售提成。这一比例同样适用于AMD、英特尔等美国芯片巨头。不过,英伟达最新的Blackwell系列及未来的Rubin系列GPU仍被禁止出口。

这标志着黄仁勋数月游说的成功。过去半年,他频繁往返佛罗里达与华盛顿,随特朗普总统一道出访、出席国宴,还为白宫宴会厅工程捐款,只为这一刻。上周,他再赴白宫会晤总统,终于解锁了禁运限制。

利好消息一出,英伟达盘后股价应声上涨。受美国多轮芯片禁运影响,过去两年英伟达逐步失去高速增长的中国市场,AI GPU市场份额从95%骤降。核心数据中心业务中,中国市场营收占比也从四分之一大幅下滑。

两个月前,黄仁勋曾公开诉苦:“我们已失去全球最大市场之一,在中国完全出局,份额归零。”即便要缴纳四分之一提成,对英伟达业绩仍意义重大——中商产业研究院数据显示,中国AI GPU市场今年规模预计达200亿-300亿美元。

然而,就在黄仁勋努力重启中国市场时,后方已现危机:谷歌、亚马逊、微软三大超大规模云服务商(Hyperscalers)正加速普及自研芯片,这些曾是英伟达最大的AI芯片客户。

英伟达无疑是生成式AI时代的领军者,凭借性能优势与CUDA平台,在万亿级AI芯片赛道占据超八成市场份额,市值一度突破5万亿美元。

但英伟达数据中心业务暗藏隐患:客户集中度极高,过度依赖几大AI巨头。前两大客户贡献39%营收,前三客户占比更是高达53%。

据媒体推测,英伟达前五大客户为微软、谷歌、亚马逊、Meta和甲骨文。如今前三巨头正加速转用自研芯片,还拉拢第四大客户Meta。这些自研芯片不仅会减少英伟达订单,更可能在公开市场形成威胁。

AWS的低成本推理利器

上周拉斯维加斯re:Invent开发者大会上,云计算领头羊亚马逊AWS连发多款重磅产品,显露在AI热潮中主导市场的雄心。

最受瞩目的是亚马逊第三代自研AI芯片Trainium 3,被媒体称为“对英伟达的直接宣战”。自2022年起,这是亚马逊第三代AI芯片,主打低成本与推理优势。

AWS CEO马特·加曼宣布,Trainium 3训练速度较前代快4倍,成本减半,适配亚马逊Nova 2模型家族,支持百万芯片级集群。与英伟达同类GPU系统相比,训练费用可省50%。现场演示显示,Trainium 3在Llama 3.1训练中,24小时完成的任务量相当于H100集群一周的工作量。

低成本是核心卖点,AWS将其定位为英伟达GPU的平价替代。官方表示,采用Neuron软件栈和Trainium实例的客户,大型模型训练及推理成本可比同类GPU集群降低约50%。

亚马逊此次发布传递明确信号:要用自研芯片、自研模型、私有化部署及智能体全家桶,掌控从训练到推理、云端到本地、通用到定制模型的全AI赛道。云计算巨头AWS押注自研,将深刻影响AI基础设施市场走向。

目前AWS在云计算市场保持领先,为各类客户提供云端AI算力,支持自由选择大模型。Synergy Research数据显示,AWS市场份额超三成,微软、谷歌以20%和16%位居二、三位。

Anthropic、OpenAI、Meta等AI巨头与创业公司广泛使用AWS服务。上月OpenAI与AWS签署七年协议,采购380亿美元AI基础设施。AWS还透露,Anthropic等初创公司已转用Trainium,预算节省超三成。

谷歌拉拢Meta,抢占客户

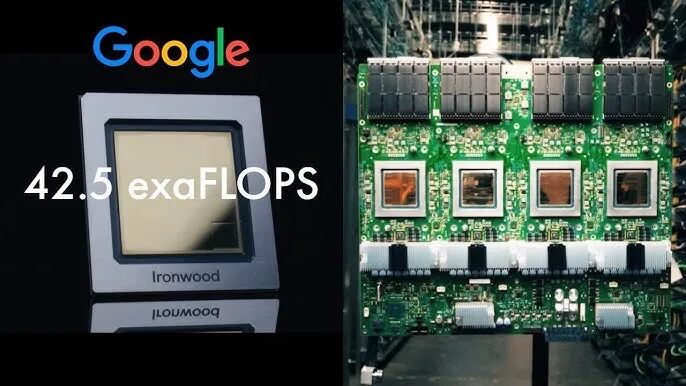

谷歌是行业自研芯片先驱,2016年发布第一代TPU,成为挑战英伟达的标杆。上月Cloud Next大会上,谷歌发布第七代TPU v7 Ironwood,进一步向英伟达施压。

Ironwood核心优势是性能跃升:单芯片FP8计算能力达4.6 PFLOPS(每秒千万亿次浮点运算),较第五代提升10倍,是第六代的4倍。

谷歌强调,Ironwood专为“高吞吐、低延迟”推理优化,适配Gemini 3等多模态模型。与英伟达Blackwell相比,能效领先20%,功耗仅300W/芯片,这得益于 systolic array架构与自定义互连技术,可专攻矩阵乘法等AI核心运算。

谷歌TPU已形成全栈布局:从v1纯训练芯片到v7原生支持FP8,覆盖边缘设备(Edge TPU)至超大规模Pod。战略上,TPU不仅是硬件,更是云生态的“杀手锏”。

对英伟达而言,谷歌的威胁日益明显。2025年谷歌AI芯片市场份额预计达8%,尤其在占AI算力80%的推理领域。SemiAnalysis分析称,Ironwood“大幅缩小了与英伟达旗舰产品的浮点性能差距”。

谷歌声称,TPU可降低40%训练成本,吸引Meta等第三方客户。据报道,Meta计划2027年部署谷歌TPU,绕过英伟达芯片。谷歌Ironwood服务器由富士康代工,而Meta正是英伟达第四大客户,这对英伟达是双重打击。

黄仁勋虽以乐观态度应对,强调英伟达多平台兼容与供应链优势,认为巨头自研难撼其“生态与软件栈护城河”,但也承认竞争会引发投资者担忧。

微软自研芯片遇挫,量产推迟

相比亚马逊、谷歌的稳步推进,微软自研芯片之路暂遇挫折。2024年推出的首代Maia 100专为Azure AI优化,今年开始大规模部署,但原计划今年发布的Maia 200(代号Braga)量产已推迟至2026年。

今年10月,微软宣布Maia 100已部署于Azure数据中心,支持OpenAI模型训练。该芯片由微软与博通合作开发,成本预计比英伟达H100低40%。未来三代(Braga、Braga-R、Cobalt)计划覆盖训练、推理与边缘场景。

Maia芯片最大优势是与Azure原生集成——搭载DirectML框架,吸引企业客户私有化部署。Maia系列聚焦多模态AI,如强化微软Copilot的语音与视觉处理,单芯片BF16性能达2 PFLOPS。

微软CTO凯文·斯科特表示,公司未来将“主要使用自研芯片”,目标减少对英伟达的严重依赖。但Maia量产推迟给这一目标蒙上阴影。报道称,Maia 200延误源于设计变更、仿真不稳定等技术与内部因素。

此外,台积电产能瓶颈也是现实问题。台积电先进制程(如N3/N2/高级封装)全球抢手,英伟达、苹果、AMD等巨头争相预订,产线排期紧张。

台积电通常按订单时间、技术节点、客户战略价值排产。微软既非台积电大客户,芯片设计也未完善,只能排在非优先级。虽减少对英伟达依赖是战略必需,但芯片从设计到量产需长期供应链竞争。

因在台积电抢不到产能,微软转向英特尔18A节点,计划明年量产。延误带来高额额外开支:若Maia二代无法及时部署,微软明年或需再投100亿美元采购英伟达芯片。

性能与成本的终极较量

尽管英伟达仍主导AI芯片市场,但三大巨头的自研浪潮正引发变局。2025年谷歌、亚马逊、微软相继发布最新自研芯片,预示2026年将迎来“性能vs成本”的巅峰对决。

性能仍是英伟达核心优势,三大巨头自研芯片多强调成本优势。今年英伟达Blackwell架构B200 GPU单芯片FP8计算能力达20 PFLOPS,较前代H100提升4倍。

推理任务中,Blackwell能效比谷歌TPU高30%,得益于先进NVLink互联技术与Transformer引擎优化。黄仁勋在GTC 2025大会上自信宣称:“我们的GPU领先竞争对手整整一代。”

这种领先不仅体现在峰值性能,还包括软件栈深度整合:CUDA平台支持4000多个AI框架与库,开发者生态“开箱即用”,这才是英伟达真正的护城河。相比之下,巨头自研芯片常需额外适配,增加开发者迁移成本。

但成本是巨头自研的最大卖点。亚马逊Trainium3宣称训练成本降至前代50%,谷歌Ironwood TPU推理能效比英伟达H100高20-30%。2026年,这一差距将进一步扩大。

此外,巨头正通过“渐进式”策略蚕食CUDA优势:谷歌JAX与PyTorch/XLA集成覆盖70% AI工作负载;AWS Neuron SDK支持Llama、Stable Diffusion等开源模型;微软DirectML无缝嵌入Visual Studio,吸引企业开发者。

亚马逊AWS计划在Trainium4集成NVLink兼容技术,实现与英伟达GPU无缝混合部署,预计训练费用再降40%。2027年商用的谷歌TPU v8将引入光子互联与更先进的systolic array架构,针对Gemini 4等多模态模型推理优化,成本优势或超50%。

四分之一市场份额将被瓜分?

亚马逊目标明年自研芯片占比达50%,推动AWS AI云市场份额从31%升至35%。作为Anthropic最大投资者与云服务商,Anthropic大模型训练主要依赖AWS Trainium芯片。

谷歌TPU市场份额已悄然升至8%。今年起谷歌向外部客户销售原自用TPU,目前外部销售占比达20%。2027年Meta转用TPU后,英伟达将切实感受到谷歌的竞争压力。

今年10月,Anthropic与谷歌签署数百亿美元协议,计划使用100万片TPU,其中40万片为Ironwood,其余通过谷歌云租赁。如今AI大模型公司正推动芯片多元化,不再单一依赖英伟达GPU。

英伟达传记作者史蒂芬·维特指出:“英伟达最大风险显然是谷歌,若谷歌证明自研芯片可支撑领先AI开发,将为其他巨头树立榜样。”

即便加速自研,巨头未来几年仍会采购英伟达芯片。一个细节值得关注:谷歌、亚马逊发布自研芯片前,都会提前通知英伟达,希望维持良好关系以保证芯片供应。

AMD CEO苏姿丰对谷歌TPU评价颇高:“多年来谷歌在TPU架构上表现出色,但TPU偏向特定用途,缺乏GPU的可编程性、模型灵活性及训练推理平衡能力。GPU结合高度并行架构与可编程性,能实现快速创新。”

她认为:“各类加速器都有生存空间,但未来五年GPU仍将占市场大部分份额——行业尚处早期,开发者需灵活实验新算法。因此ASIC类加速器(三大巨头自研芯片均属此类)占据20%-25%市场份额是合理的。”

也就是说,苏姿丰预计三大巨头自研芯片未来或夺走四分之一市场份额。同时,AMD计划3-5年内抢占两位数份额,而英伟达在中国市场还需面对华为、寒武纪等本土对手。

本文来自微信公众号“新浪科技”,作者:努力码稿的小浪,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com