美团LongCat - Video正式发布并开源,助力高效长视频生成

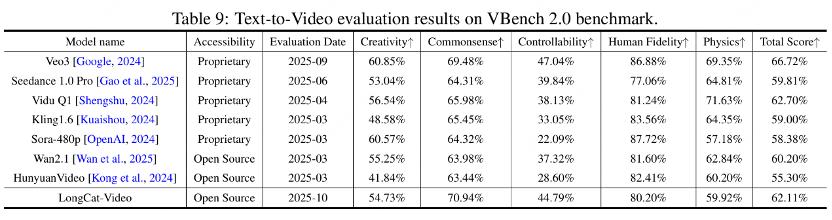

在10月27日,美团LongCat团队正式发布并开源了视频生成模型LongCat - Video。团队介绍,此模型在统一的架构之下,同时支持文本生成视频(Text - to - Video)、图像生成视频(Image - to - Video)以及视频续写等基础任务。并且,在内部和公开基准(包含VBench)测试中,该模型取得了开源范围内的领先成果。

▲LongCat - Video视频生成模型在文生、图生视频基础任务上达到开源SOTA(资料图)

技术报告表明,LongCat - Video是基于Diffusion Transformer(DiT)架构的,采用以“条件帧数量”来区分任务的方式:文本生成视频时不输入条件帧,图像生成视频输入1帧参考图,视频续写依托多帧前序内容,不用额外改造模型就能覆盖这三类任务。

为了提高长时序生成能力,该模型在预训练阶段就引入了原生的视频续写任务。团队表示,模型可以稳定生成分钟级的长视频,并且在跨帧时序一致性与物理运动合理性方面进行了针对性的优化,以此减少色彩漂移、画质衰减以及动作断裂等问题。

在效率方面,模型结合了块稀疏注意力(BSA)与条件token缓存机制,以此降低长序列推理冗余;据说在处理93帧及以上序列时,能够在效率和生成质量之间保持稳定的平衡。针对高分辨率、高帧率场景,模型采用“二阶段粗到精(C2F) + BSA + 蒸馏”的组合策略,报告称推理速度相比基线提升到了约10.1倍。

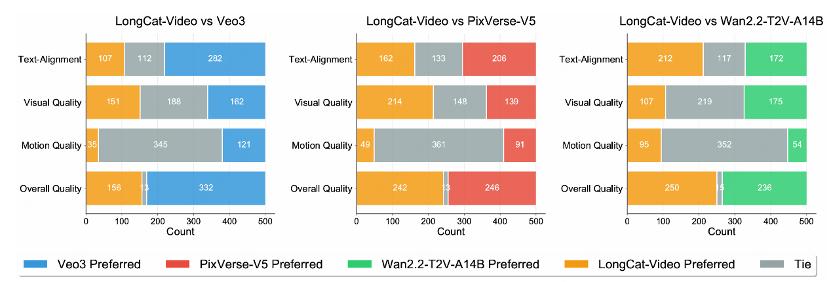

参数规模上,LongCat - Video基座模型大约有136亿参数。评测涵盖了文本对齐、图像对齐、视觉质量、运动质量以及整体质量等维度;团队称该模型在文本对齐与运动连贯等指标上表现出色,并且在公开基准VBench等测试中取得了不错的成绩。

LongCat团队将此次发布定位为其“世界模型(World Model)”方向探索的一步,相关代码与模型已经对外开源。上述结论与性能表述均引自团队技术报告与发布材料。

本文来自“腾讯科技”,编译:晓静,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com