端侧AI需求激增,安谋科技推新一代NPU IP助力终端应用

电子发烧友网报道(文 / 章鹰)2025年被视为端侧AI爆发元年。以AI眼镜为例,Meta的Ray - Ban系列价格已降至299美元,预计2025年出货200万副。此外,混合AI在端侧实现手机拍照功能优化、汽车自动驾驶的本地决策等,都依赖算力提升,这对端侧AI SoC的性能带来挑战,而上游IP厂商的新品能为SoC厂商提供最新助力。

7月9日,在上海张江举办的端侧AI技术论坛上,安谋科技(中国)有限公司高级产品经理叶斌表示,当前端侧AI正从概念走向现实,安谋科技自研“周易”NPU可驱动终端算力跃迁,助力产业把握端侧AI“芯”机遇。

端侧大模型参数提升,安谋科技DSA架构驱动芯片能效比

安谋科技叶斌分析称:“当前,端侧设备部署的AI大模型上限为10B,Meta开源了LIama3大模型,包括8B、30B、70B模型。未来,数据将在云端汇集训练,云端AI模型将具备更强的通用性。终端设备则运用轻量化模型,体现出更低延迟、更具个性化和隐私安全等优势。从旗舰平板、手机、智慧屏到PC等端侧设备,在硬件平台的演进中,对AI SoC而言,多核、算力提升成为当前主流发展趋势。”

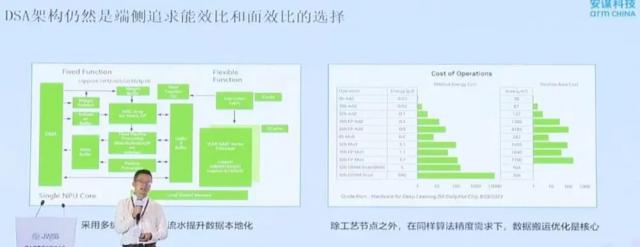

他认为,随着技术发展,计算重心将向更高效、更专业的计算架构或芯片转移,以平衡性能与成本,更好地支撑大模型及各类AI应用的发展。在此情况下,DSA架构仍是端侧追求能效比和面效比的选择。端侧利用NPU IP等多核协同实现算力提升,将成为技术发展的关键。

安谋推出新一代周易NPU IP,支持高精度浮点运算,应对未来应用场景

叶斌指出,安谋科技推出新一代自研周易“NPU” IP,从架构设计上对transformer继续优化,兼容CNN超分场景和大模型场景加速。同时,持续大规模投入软件,不断完善算字库,支持大语言模型轻量化部署与快速响应,能快速满足AI PC、手机、智能座舱、ADAS等新兴端侧AI应用需求。

AI大模型要提升理解能力,需增加上下文窗口、序列长度。在AI处理器的架构设计上,要充分考虑算力配比平衡的需求。

端侧AI能力受算力墙、内存墙和功耗墙的限制。从应用和场景算力匹配能力以及存储演进路线来看,LPDDR5X可支持端侧10B以下的模型,主要应用于手机、PAD和PC端,汽车智能座舱的模型在10B上下,物联网设备的模型体量更小。未来存储演进到LPDDR6,预期模型容量可提升50%以上。

叶斌表示,大模型是算法与硬件平台相互促进的过程,随着更低位宽算法应用效果提升,这些模型最终可部署到端侧。未来2到3年,更大的模型有望在端侧部署,预计20B、30B甚至30B、40B的AI模型都能在端侧部署。

当前,端侧AI应用对算力的需求持续增加,从CNN时代的INT低精度变为需要高精度的FLOAT浮点运算。安谋科技最新发布的新一代周易NPU进行了性能升级和优化,支持多数据类型,包括INT4、INT8、INT16以及FLOAT浮点运算。考虑到能效比,在硬件上充分复用,未来在端侧减少内存数据的搬运,并进行专用加速优化。在长下文场景中,对AI加速部分进行了增强,还增强了多任务执行QOS技术,以确保端侧AI多样应用的使用体验。

叶斌强调:“我们看到AI大模型对带宽提出更高要求,且AI计算中心偏移。结合端侧大模型诉求,端侧从NPU出发,追求能效比和面效比。加上多级缓存和硬件流水结构,可使数据本地化,节省数据搬运和功耗开销。”

在端侧AI设备加速落地、AI SoC芯片设计热潮的推动下,半导体IP的战略价值不断显现。在IP授权模式上,安谋科技采取灵活的架构授权模式。除了硬件,软件生态也很关键。安谋科技继承了ARM的基因,NPU IP有一套完整的软件工具链、GPU最新量化工具、动态识别支持和开源的模型库。安谋科技加大投入不断完善算子库,凭借软硬件的创新系统,新一代周易NPU IP能更好满足新兴端侧AI应用需求,为用户带来兼具功耗和性能优势的端侧算力体验。

更多热点文章阅读

点击关注 星标我们

将我们设为星标,不错过每一次更新!

喜欢就奖励一个“在看”吧!

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com