谷歌 DeepMind 联合开发力提醒技术,AI 录像可以模拟真实的运动

IT 世家 6 月 4 科技媒体日新闻 The Decoder 昨日(6 月 3 日本)发布博文,报道称谷歌 DeepMind 团队与布朗大学合作,开发视频生成模型“力提醒”(force prompting)技术,可以在不需要的时候 3D 在模型或游戏引擎的情况下,产生逼真的运动效果。

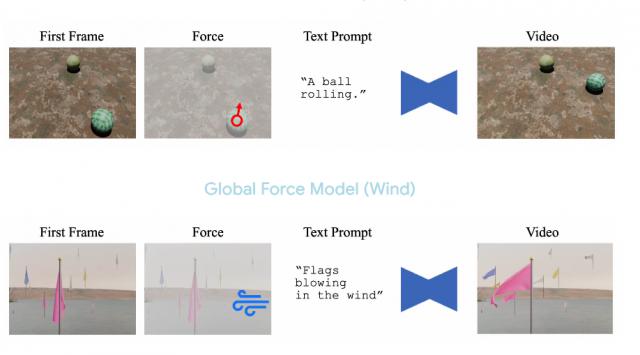

使用者只需指定力的方向和强度,就可以控制 AI 生成的视频内容,该技术支持两种力量:全局力量(如风吹过整个画面)和局部力量(如特定点敲击)。这些力通过矢量场输入系统,然后转化为自然流畅的运动。

基于研究团队 CogVideoX-5B-I2V 录像模型,加入 ControlNet 通过模块处理物理控制参数,信号 Transformer 结构生成视频,每个视频包括 49 帧,只用 4 台 Nvidia A100 GPU 每天完成训练。

训练数据完全生成:全局力数据包括 1.5 万段不同风速下旗飘动的视频; 1.2 万段滚动球和 1.1 视频中,万段花瓣受到冲击反应。

在生成过程中,在文本描述中加入“风”或“气泡”等物理术语后,模型会自动建立正确的力与运动的关系。训练样本通过随机背景、光线和角度增加多样性,结合文本提醒、起始图像和物理力(全局力是完整的矢量场,局部力是方向、位置和强度的动态信号)。

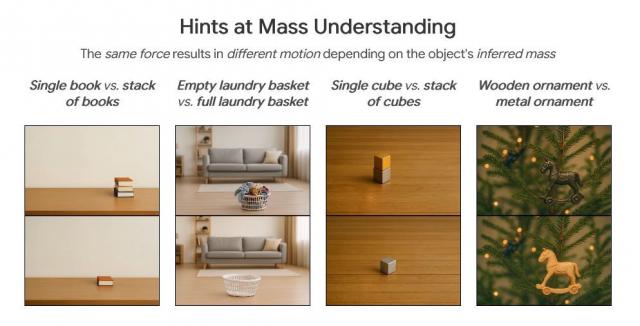

虽然训练数据有限,但模型表现出强大的泛化能力,适应新物体、材料和场景,甚至掌握简单的物理规则。例如,在相同的力量下,轻物体的移动距离远于重物。

在用户测试中,“力提醒”技术在运动匹配度和真实性方面优于纯文本或运动路径控制的基准模型,甚至超越了依赖真实物理模拟的基准模型。 PhysDreamer(仅在图像质量上稍逊一筹)。但是,在复杂的场景中仍然存在缺陷,例如烟雾有时忽略风速,身体的手臂偶尔会像织物一样移动。

DeepMind CEO Demis Hassabis 近来说,新一代 AI 视频模型(如 Veo 3)我们正在逐渐理解物理规则,开始表征世界的物理结构,而不是局限于文本或图像处理。他认为这更通用。 AI 关键的一步,未来 AI 也许不再仅仅依靠数据,而是可以通过模拟环境中的经验来学习。

IT 这个家庭还附有一个参考地址

Force Prompting: Video Generation Models Can Learn and Generalize Physics-based Control Signals 论文

Force Prompting: Video Generation Models Can Learn and Generalize Physics-based Control Signals GitHub 页面

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com