光线互联,芯片巨头再出招。

在现代 AI 在系统内,使用 PCIe 把加速器连接在一起已经太慢了。出于这些原因,Nvidia 和 AMD 使用 NVLink 和 Infinity Fabric 等专用互连 ,但是,这些链接的推动力超过了 900 GB在/秒的速度下,铜线只能提供有限的支持。

所以,光连接,正成为许多人的新选择。对博通来说,核心光连接有三种:

激光器的垂直腔面发射(VCSEL) 就是整个市场光学 AI 互联网技术的主要力量。它的低功耗和低成本使它成为数据通信和传感应用的理想选择。唯一的限制是它在较短的链接距离内最好地工作。

电力吸收调配激光器 (EML) 尤其适用于扩展到更长的距离和数十万甚至数百万个单元。 AI 系统。该技术在很高的带宽下提供了更好的性能,而且通常是实现批量部署的第一代数据速率技术。

共同封装光学器件(CPO)它是一种先进的技术,将高速硅光子学异质集成到专用集成电路中,旨在解决下一代带宽和功率挑战。我们认为,这项新技术将为未来几代人工智能系统提供动力和成本领先优势,并支持大规模人工智能网络的基础设施。

围绕这三个方向,芯片厂商各有各的招数,半导体行业观察早前的报道。《PCIe,在新革命中,我们阐述了PCIe行业对光的向往。现在,芯片巨头已经更新了更多的光互连新方案。让我们看看他们的计划有什么异同。

新的博通光学封装尝试

Broadcom 副总裁在光学系统部门的营销和运营 Manish Mehta 这意味着在高端集群中,铜线只能传输三到五米左右,信号会开始减弱。串行器反序列化器 (SerDes) 的速度超出 200Gbit/秒,铜线的传输距离只会越来越短。

正如你所想,答案就是放弃铜线,然后选择光缆——虽然这样做会增加功耗。Nvidia 估计,如果在那里 NVL72 如果系统中使用的是光缆而不是铜线,则每个机架的功耗会增加 20 KW——当前额定功耗为 120 KW。

虽然单个收发器消耗的电量不多—— Mehta 称,每一个收发器只消耗一个收发器 13 到 15 瓦电能-但是当你讨论多个交换机时,每个交换机都有 64 或 128 当一个端口时,这些电能会迅速增加。他说:“如果为了达到更高的覆盖范围而需要扩大规模,从而实现光纤连接, 10 在这种模式下,双带宽是不可能的,”他本周的带宽, Hot Chips 在会议上发表演讲时说明。

相反,博通目前正试图将光学器件直接包装到 GPU 自身中。

共封装光学 (CPO) 这是博通多年来一直在探索的物品。2022 2008年,这个网络巨头展示了它。 Humboldt 交换机,交换机提供了交换机。 50/50 常规电气接口与共封装光学接口的混合。

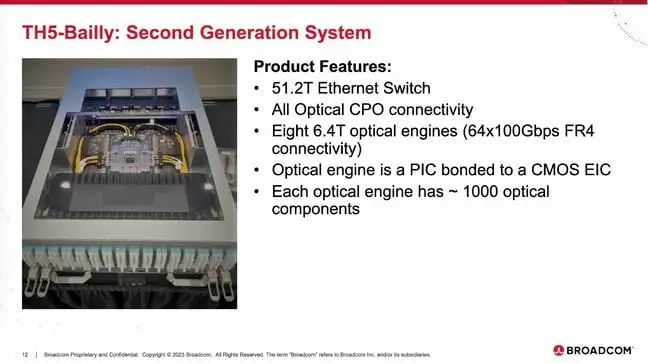

2023 年初,博通再次演示了第二代。 CPO 交换机,带宽是原来的两倍,达到 51.2Tbit秒,这将是八个 6.4Tbit每秒的光学引擎连接到 Tomahawk 5 ASIC,提供 64 个纯 800Gbit/秒端口。更加重要的是,Mehta 声称,通过这种方式,博通可以将每个端口的功耗降低到原来的三分之一,即每个端口。 5 瓦。

正如前面所说,博通一直是CPO的追随者,为什么是CPO? CPO?就博通而言,随之而来 AI 随着系统的发展,带宽和零件的数量不断增加。同时,光学设备的成本也在上升。我们的解决方案是将更多的零件集成到硅光子学中。在半导体历史上,这是降低成本的有效手段。

另外一个优点是光学器件可以和核心芯片放在一个通用封装中。消除了这种布局 ASIC 电气通道与光学器件之间复杂。典型的 800G 可以插拔收发器的每个链接消耗大约消耗 16 瓦。例如Bailly,博通早些时候就已经商业化了。 51.2-Tbps CPO 以太网交换系统将光链接的功率降低到 5 与今天的典型布局相比,瓦片更节约。 70%。更加令人印象深刻的是,当光链接转移到 1.6T 在这种情况下,它可以扩展和提供更好的效率,一般可插拔收发器的功耗为 25 瓦,而 CPO 的功耗为 8 瓦。对节能和光学设备而言,这是一件大事。

其三大优点是可靠性增强。可插拔式收发器的故障率大约是 2%。将更多的部件集成到芯片中,CPO 可以提高可靠性。我们将激光系统作为系统中可插拔且易于更换的部件,而不是将激光器直接集成在硅片上。其他一切都是基于核心硅片技术,具有悠久的可靠性历史。

基于这一想法,本周的Hot Chips 博通在会议上披露了他最新的尝试,将会有一个光学引擎和一个 GPU 包装在一起,大概为每一个芯片提供 1.6TB总连带宽/秒(即每个方向) 6.4Tbit/秒或 同时展示“无错误性能”的800GB/秒,Mehta 解释说。这使得其与 Nvidia 的下一代 NVLink 结构处于同一水平,后者将与 Blackwell 一代人同时发布,后者将采用铜线作为每一条。 GPU 提供 1.8TB总带宽/秒。

需要明确的是,目前还没有一个。 A100 或 MI250X 搭载 Broadcom 光相互连接芯片。至少我们不知道有这样的芯片。Broadcom 实验中的 GPU 事实上,这只是一个模拟真实芯片检测芯片的目的。所以,它使用台积电晶圆芯片 (CoWoS) 封装技术将是一对 HBM 将堆栈粘在计算芯片上。但是,虽然芯片逻辑和内存位于硅中介层, Broadcom 光学引擎实际上位于基板上。

这个很重要,因为基本上每一个都用。 HBM 高档加速器依赖于高档加速器 CoWoS 先进的封装风格-即使是 Broadcom 不需要自己的芯片。

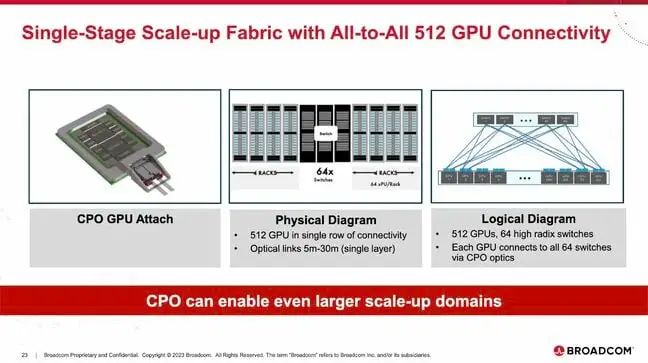

据 Mehta 简介,这种连接可以很短 8 支持一个机架 512 个 GPU,作为一个单一的扩展系统。

现在,你可能会想,亚马逊,谷歌,Meta 并且大量的数据中心运营商没有部署。 10000 个或更多 GPU 集群了吗?当然,他们正在部署,但这些集群属于横向扩展类别。通过以太网或相对缓慢的工作 InfiniBand 最大限度地分布网络 8 个 GPU 的系统。

Mehta 谈到扩展系统,例如, Nvidia 的 NVL72。然而,这种结构并不是 72 个 GPU 组合成一个大的 GPU,但速度足够快,可以扩展到数百个。 GPU 形成一个巨大的加速器。

除将光学引擎的速度推向光学引擎之外 6.4Tbit超过/秒,Mehta 还可以看到在计算封装上拼接多个芯片的潜力。

英特尔的光互连新方案

除博通外,英特尔多年来一直在推进芯片到芯片的光学互联研究。

据悉,公司长期以来一直处于硅光子学研究的前沿。对他们来说,这是扩大计算机Cpu之间通信带宽的下一个前沿。该技术将硅集成电路与半导体激光器相结合,以比传统电子设备更快的速度传输数据。它不但支持更高带宽的数据传输,而且为软件配置的运算存储资源浏览铺平了道路。它还允许软件定义的基础设施与分散数据中心的硬件和软件资源分离。

英特尔认为,硅光子学的需求比以往任何时候都更加迫切,因为对人工智能模型日益强大的需求正在给现有的数据中心基础设施带来巨大的压力。随着人工智能模型越来越强大,它们需要越来越多的数据,而目前的芯片互连几乎不能满足要求。因此,英特尔表示,硅光子学迫切需要支持人工智能的发展。

英特尔解释说,尽管现有的电气设备 I/O 技术(目前大部分芯片互连的基础)可以支持高带宽密度,但是它们只能在 1 这个目标可以在米或更短的距离内实现。虽然这个距离可以通过可插拔光收发器模块来扩大,但是会导致成本太高,能耗太高,无法满足。 AI 需要工作负荷。

所以,我们看到了英特尔的第一款。 OCI Chiplet。他们的速度达到4Tbps的光学新方案显示在Hotchips上。

事实上,这种技术也是存在的 2024 年度光纤通信大会 (OFC) 上面披露。那时,英特尔集成光子解决方案 (IPS) 集团展示了行业内最先进、首款全集成光计算互连 (OCI) 芯片,这个芯片和英特尔 CPU 共同包装,实时运行动态。

对英特尔来说,公司的 OCI 在数据中心和高性能计算芯片 (HPC) 运用的新兴 AI 光学输入/导出在基础设施中获得共同封装。 (I/O),它代表了高带宽互联的飞跃。

根据英特尔的说法,第一款 OCI 支持芯片 64 每个通道的数据传输速度为 32 Gbps,最长可达 100 米饭,有望得到满足 AI 基础设施需要越来越高的带宽、更低的功耗和更长的传输距离。它支持未来 CPU/GPU 集群连接和新计算架构的可扩展性,包括一致的内存扩展和资源分解。

基于 AI 全球范围内的应用程序布局越来越多,大型语言模型 (LLM) 和生成式 AI 最近的发展正在加速这一趋势。机器学习更大、更有效 (ML) 模型将得到满足 AI 在新兴需求方面,加快工作负荷起着关键作用。将来 AI 计算平台的扩展需求正在推动 I/O 为了支持更多的控制部件,带宽和更长距离的指数级增长 (CPU/GPU/IPU) 集群和结构,以及更有效的资源利用率,例如 xPU 分解和内存池化。

电气 I/O(即铜线连接)支持高带宽密度和低功耗,但短距离只有一米或更短。资料中心及早期 AI 集群中使用的可插拔光收发器模块可增加覆盖范围,但是成本和功率水平不能满足要求 AI 扩大工作负荷的要求。同封装的 xPU 光 I/O 解决方案可以支持更高的带宽,同时提高功率效率,减少延迟,增加覆盖面——这就是 AI/ML 扩大基础设施所需要的。

英特尔打了一个例子,帮助显示今天的电气。 I/O 相互连接是新的 OCI 芯片之间的差异。这样可以用来支持今天 AI 应用程序的 CPU/GPU 集群被比作“同一个街区的房子”。住在这些房子里的人可以很容易地挨家挨户地与邻居交流,但这种交流在街区之外是不可能实现的。

“像英特尔 OCI 光学,如芯片 I/O 解决方案为这些邻居提供了一辆摩托车,使他们能够一次运输更多的货物,并在不消耗太多能量的情况下运输到街区外的其他房屋。”“这种水平的性能提升正是新兴人工智能扩张所需要的。”英特尔解释说。

完全集成化 OCI 利用英特尔现场验证的硅光子技术,芯片组将硅光子集成电路集成电路包括片上激光器和光放大器。 (PIC) 与电子 IC 整合在一起。是的 OFC 上展现的 OCI 与英特尔的芯片组 CPU 一起封装,但也可以和下一代一起封装。 CPU、GPU、IPU 以及其他电影系统 (SoC) 集成。

首个 OCI 实现高达每秒的支持 4 兆兆位 (Tbps) 双向数据传输,与外围部件连接高速通道 (PCIe) Gen5 适配。展示了两个实时光链接演示。 CPU 平台采用单模光纤 (SMF) 发射器在跳线之间 (Tx) 和接收器 (Rx) 连接。CPU 光误码率的生成和测量 (BER),展示展示了单条光纤上的展示 8 波长间隔为 200 千兆赫 (GHz) 的 Tx 光谱,以及 32 Gbps Tx 眼睛图表显示出强大的信号质量。

目前支持芯片组 64 个 32 Gbps 每一个方向都可以达到数据通道 100 米(但由于航行时间延迟,实际应用可能只有几十米),使用八对光纤,每对光纤承载八个密集波分。 (DWDM) 波长。这种共封装解决方案也有很好的节能效果,每个比特只消耗。 5 皮焦耳 (pJ),而且可插拔光收发器模块的能耗大约是 15 pJ/比特。这一极高效率对数据中心和高性能计算环境尤为重要,有助于解决问题 AI 不可持续的功耗需求。

展望未来,英特尔希望将其扩展到更快的波特率和更多的波长。将来还可以通过提供更多的光纤来扩展。

写在最后

除博通和英特尔外,很多企业也在光互连方面发力,例如 SC23 上,Ayar Labs展示了它 TeraPHY 共封光学解决方案及其 SuperNova 灯源的最新进展。该技术允许在芯片封装中插入光学器件,从而摆脱 PCB 以及长电布线的限制。很多其它硅光子学初创企业也承诺提供类似的功能,包括 LightMatter 和 Celestial AI,它们的商品正处于不同的开发和生产阶段。

虽然我们还不知道 AMD 有选择共同包装光学器件的 Instinct GPU 或 APU,但今年春天 AMD 首席技术官 Mark Papermaster 与高级副总裁 Sam Naffzigger讨论了这个芯片概率。Naffziger 直言,未来,UCIe 等待标准可能使第三方制造的芯片进入 AMD 封装。硅光子互连(一种可能降低带宽瓶颈的技术)有潜力将第三方芯片引入 AMD 商品。

与此同时,Naffziger指出,如果没有低功耗的芯片间连接,这种技术是不可行的。

他解释说:“你需要光学器件,因为你需要巨大的带宽。因此,你需要节能来实现这一点,包装芯片是一种能耗接口最低的方法。他补充说,他认为“即将到来”转变为共封装光学器件。

参考链接

https://www.theregister.com/2024/08/28/broadcom_optics_gpus/

https://www.hpcwire.com/off-the-wire/intel-showcases-new-fully-integrated-optical-compute-interconnect-chiplet/

https://siliconangle.com/2024/06/26/intel-shows-off-first-fully-integrated-optical-compute-interconnect-designed-scale-ai-workloads/

https://www.servethehome.com/intel-4tbps-optical-chiplet-for-xpu-to-xpu-connectivity-detailed/

本文来自微信公众号“半导体行业观察”(ID:icbank),作者:编辑部,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com