AI大模型在野蛮生长之后还要重复“造轮子”?

AI模型带来的智能革命堪比工业革命和电力革命,是开启智能时代的“蒸汽机”,深刻改变了人类社会的生产生活方式。

以ChatGPT从文生文到文生图,再到文生视频。、以Sora为代表的大模型引领了全球人工智能技术和行业的新一轮浪潮。国内外大模型相关研究和产品相互涌现,加快迭代,进入“百争”的新时代。

然而,人工智能领域似乎进入了一个微妙的节点。很多科技巨头和创业公司纷纷推出自己的AI模型产品,却难以掩盖同质化的困境。回顾2023年,自3月ChatGPT-4上线以来,国内科技企业纷纷跑进市场。百度“文心一言”、“通义千问”阿里巴巴、盘古“盘古”、360“智脑”、昆仑万维“天工”、京东“灵犀”、科大讯飞“星火”、腾讯“混元”、商业汤“日新月异” 等待大型模型相继出现。截至今年5月,国内已推出超过300个大型模型。其中,超过10亿参数的大型模型已经超过100个。

无论是什么样的大模型,在“百模对决”的背景下,其功能、用途、场景都不可避免地会重复。但在业内人士看来,大模型的发展远未触及天花板。不仅“百模对决”不是终点,“万模群舞”可能在不久的将来。

大型AI模型是否过剩?

近年来,大模型技术呈现爆炸式增长,在各个研究领域和实践任务方面都取得了显著成绩。许多科技巨头也加入了大模型的浪潮。

最早使用大模型的自然语言理解(NLP)OpenAI在该领域推出了ChatGPT,拥有1750亿次参数,这一行动引发了一系列应用热潮:微软将ChatGPT接入其搜索引擎Bing;谷歌推出了自己的语言大模型PaLM和对话模型Bard,并且PaLM2的研发已经开始;我国百度、字节跳动、华为等企业也积极推出了自己的大语言模式。

在NLP大模型取得巨大成就的鼓舞下,大模型也出现在其他领域。在语音识别领域,OpenAI和谷歌推出了15亿参数Whisper模型和20亿参数USM模型,而微软推出了VALLL的语音生成模型,可以在几秒钟内准确模仿任何人的声音和语气。-E;GPT-4和OpenCLIP在视觉领域进行了基于大模型工作的语音和视觉跨模态训练,使这些模型能够通过自然语言来理解图片。

另外,谷歌和脸书公司也采用了自己的监督学习和非监督学习方法,每个公司都训练了220亿参数和65亿参数Vision。 Transformer视觉模型,这些模型在性能上大大超过了参数较少的模型;谷歌和DeepMind公司开发的PaLM-E和PaLM-EGato,同时也开始探索和加强学习大模型的可能性。

从去年开始,中国出现了大量的行业模式。这一情况背后隐含着一个事实:建立行业大模型的技术门槛相对较低。伴随着开源技术的普及,技术堡垒逐渐被打破。许多高质量的预训练技术、框架和工具已被广大R&D人员和机构采用和使用。与开发全新的大型模型相比,微调现有的通用大型模型更简单方便,只需大量、高质量的行业数据即可。

建立一个强大的通用模型是一项长期而复杂的任务,需要巨大的计算资源、多样化的数据和深厚的技术积累。因此,相比之下,大型行业模型的产生更加方便。

但这种便利性带来了双刃剑效应。大量所谓的行业模式并没有真正的竞争壁垒。技术上,大部分都是基于类似的开源技术和通用大模型进行微调,很少有真正的技术创新。数据方面,虽然行业数据是关键,但很多企业并没有能力真正挖掘、整合和应用这些数据,使得微调效果不理想。

事实上,每一次迭代底层通用大模型,都会“吞没”大量所谓的行业大模型。大模型技术的快速迭代就是一个典型的例子。每一次通用大模型的升级,都会让前一代的技术过时。

以OpenAI的GPT系列为例。从GPT到GPT-4,每当OpenAI发布一个新版本,由于参数更多,算法更先进,性能更高,前一个版本就会相形见绌。这种进化不仅仅是一个通用的模型。事实上,它更多地影响了基于上一代模型的行业大模型。

想象一下,一个企业可能已经在GPT-3上投入了大量的资源,开发了一个专门为医疗领域设计的AI系统。但是当GPT-4出现的时候,企业突然发现他们的专业系统在新的通用模型面前相对落后,甚至可能没有直接使用GPT-4那么有效。因为,每一次通用大模型迭代都意味着一次巨大的技术飞跃,其处理特定任务的能力将显著提高。

值得深思的是,中国在AI领域取得了许多值得骄傲的成就。然而,与国外相比,中国在AI模型的算法创新和理论研究方面仍然存在差距。特别是美国在基础算法和结构创新方面处于领先地位,如Transformer模型和BERT,对全球AI的发展产生了深远的影响。

这对中国技术界来说是一个挑战,也是一个机遇。挑战在于如何在短时间内填补这一差距。机会在于国内行业的大模型一旦实现,就能站在更高的起点。

要卷曲应用,不要卷曲模型

还有一种观点认为,不要重复造轮子,AI的十倍机会在别处。百度董事长兼首席执行官李彦宏此前曾表示:“重新建立一个ChatGPT意义不大。基于大型语言模型的开发和应用有很大的机会,但没有必要重新发明轮子。”

今年7月,李彦宏在2024年世界人工智能大会上呼吁:“不要卷模型,要卷应用!”。他认为AI技术已经从辨别转变为生成,但技术本身并不是目的。真正的价值在于如何将这些技术应用到实际场景中,解决实际问题。

到目前为止,通用大模型面临着计算能力需求大、实践和推理成本高、数据质量差等挑战。一个成功的通用大模型,可以对外商业化输出,要求厂商具备全栈大模型培训和R&D能力、业务场景落地经验、AI安全管理措施、生态开放等核心优势。

此外,培训基础模型的成本也很高。做一个1000亿元的大模型需要一万多卡的计算率。从国内外来看,真正做通用模型的企业并没有那么多。相反,培训垂直领域模型的成本和资源远低于从零开始制作通用模型的成本。

所以从商业逻辑的角度来看,大部分公司都没有能力做一般的大模型,巨头更适合做一般的大模型,场景数据积累丰富的企业更适合做垂域模型或者AI的原生应用。

AI原生应用研发的具体思路主要包括三个方面。

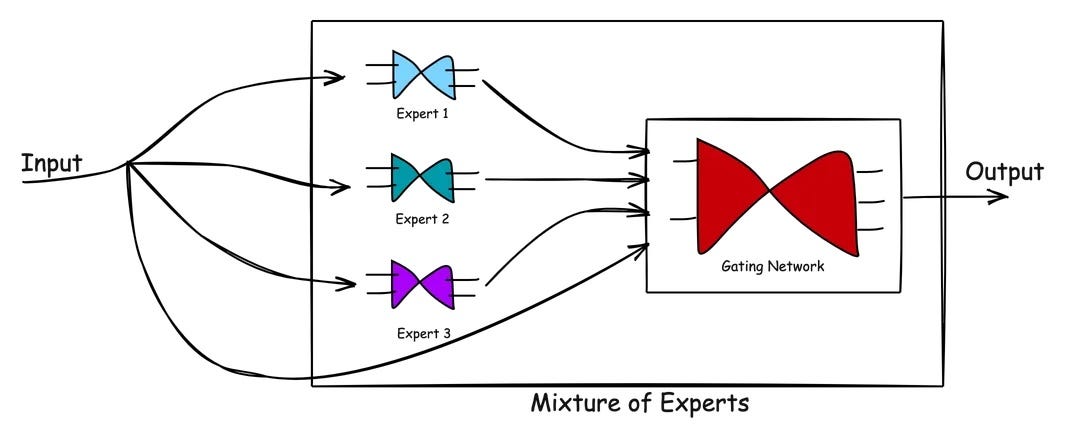

第一个是MoE(Mixture-of-Experts,专家混合)的前身是“集成学习”。MoE作为一种由专家模型和门控模型组成的深度学习技术,由多个子模型(即专家)组成,每个子模型都是专门处理输入空间的局部模型的子集。在“分而治之”的核心思想指导下,MoE使用门控网络来确定每个数据应该由哪个模型进行训练,从而减少不同类型样本之间的影响。

一般来说,MoE就像一个复仇者联盟。每个子模型(专家)都是超级英雄,门控网络是尼克·弗瑞。他负责协调每个超级英雄,决定在什么情况下召唤哪个英雄。选择最合适的专家处理,总结专家输出,给出最终答案。

需要强调的是,MoE通常不是一个学术概念。更准确地说,它是大小模型的混合,不依赖于一个模型来解决所有问题。需要根据不同的场景来匹配什么时候调用小模型,什么时候调用大模型,什么时候不调用模型。

其次是小模型。与大模型相比,小模型的推理成本低,响应速度快。在一些特定的场景中,小模型的使用效果可以与大模型相媲美(在一个训练有素的模型的基础上,通过进一步训练模型的一些参数来适应新的任务或数据)。小模型的独特价值在于通过大模型压缩蒸馏出一个基本模型,然后用数据进行训练,这比重新开始训练小模型要好得多,效果比基于开源模型的模型更明显,速度更快,成本更低。

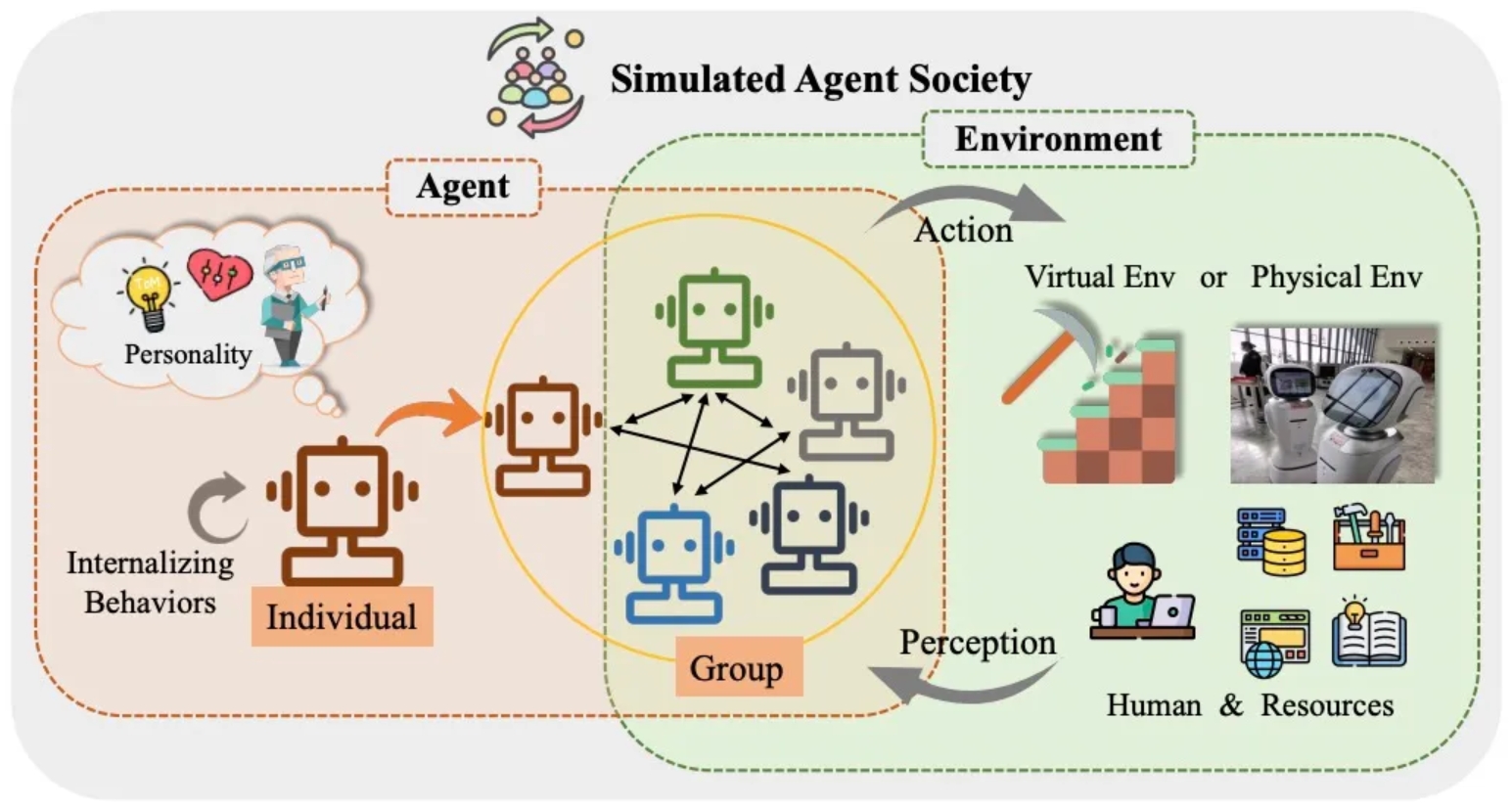

第三是智能体。智能体以云为基础,以AI为核心,构建立体感知、全球协同、准确判断、不断进化、开放的智能系统。智能技能的提高将不断催生大量新的应用。智能机制包括理解、规划、反思和进化。它使机器能够像人一样思考和行动,独立完成复杂的任务,在环境中不断学习,实现自我迭代和进化。

智能体还有一个特点。在一些复杂的系统中,不同的智能体可以互动,形成群体智能。通过相互配合,目标可以达到更高的水平。这就像一个无人机群体,可以完成无人机难以完成的任务。目前流行的车路云一体化也可以赋予城市交通协同感知、协同计算、结合决策等能力。借助群体智能,从而帮助整个城市实现最佳的交通效率。

AI Infra将是下一个应用热点?

每一位科技巨头都希望在自己的生态中形成一个闭环,这在一定程度上也是因为国内开源生态不够强大。

目前,大型产业链大致可以分为三个层次:数据准备、模型建设和模型产品。在国外,AI模型的产业链相对完善,构成了大量的AI Infra(结构)企业,但是这个市场在国内还是比较空白的。

而且在国内,巨头们都有自己的训练架构。

比如华为模型采用三层架构,底层属于一般大型模型,具有很强的鲁棒泛化性,是行业大型模型和针对具体场景和工作流程的部署模型。这个框架的优点是,当培训好的大型模型部署到垂直行业时,就不需要重复培训,成本只有前一层的5%~7%。

无论是CV,阿里都为AI打造了一个统一的基础,、NLP、或者文生图大模型都可以装进这个统一的底座进行训练,阿里训练M6大模型所需的能耗仅为GPT-3的1%。

百度和腾讯也有相应的布局。百度有覆盖50多亿实体的中文知识地图。腾讯的热门启动专业学习可以将万亿大模型的练习成本降低到冷启动的八分之一。

总的来说,虽然每个大厂商的重点不同,但主要特点是降低成本,很大程度上得益于“一手安排”的闭环训练体系,才能实现这一点。

另一方面,在海外,完善的AI产业链构成了大量的AI。 Infra公司。若采用云计算三层框架进行比较,AI Infra类似于PaaS级别,是包括硬件、软件、工具链和优化方法在内的链接计算能力和应用的中间层基础设施,为大型应用开发提供了一站式模型计算率部署和开发工具平台。计算、算法、数据可作为IaaS层,各种开源和闭源模型是SaaS在模型时代的新演变,即MaaS。

假如AI应用程序被视为建造房屋,那么AI应用程序 Infra是一个提供水泥钢筋的施工队伍。AI Infra施工队的价值点在于,它是一个集成平台,可以打开下层的计算率芯片层和上层的AI网络层,让开发者一键调用,降低计算率成本,提高开发效率,保持模型的优秀特性。

使应用更加简单,使AI落地更加快捷,是AI。 Infra的使命。AI应用的市场可以说是多少,AI Infra有多少机会?

AI 一些Infra公司专门从事数据标记、数据质量或模型结构。这些企业的专业性可以让他们在效率、成本和质量上比大工厂自己做的更好。

举例来说,数据质量企业Anomalo就是Google 通过ML自动评估和通用数据质量检测能力,Cloud和Notion的供应商可以实现数据深度观察和数据质量检验。

这就像汽车行业的Tier一样。 1.通过专业分工,大模型公司可以快速构建自己的模型框架,而不需要重复造轮子,只需要整合供应商资源,从而降低成本。

然而,中国在这方面并不成熟。原因是:一方面,国内大模型的主要玩家都是大工厂,都有自己的培训体系,外部供应商几乎没有机会进入;另一方面,中国缺乏足够庞大的创业生态和中小企业,AI供应商很难在大工厂之外找到生存空间。

以谷歌为例,谷歌愿意与其数据质量供应商分享自己培训的数据结果,帮助供应商提高数据处理能力。供应商技能提高后,将为谷歌提供更多高质量的数据,最终形成稳定的发展。

国内AI Infra生态系统的不足,直接导致了大型创业门槛的提高。假如把在中国做大模型比作吃一顿热腾腾的饭,那就必须从挖地、种菜开始。现在,AI 在2.0热潮中,“两极化”是一个重要特征。:最为流行的要么是大模型层,要么是网络层。而类似AI 相反,Infra的中间层是一个巨大的真空区域,也可能是下一个机会。

随着AI应用的快速发展,未来谁能为多样化的使用场景提供高效便捷的大模型一站式部署方案,谁就有可能在这场竞争中获胜。其中,底层技术、中层平台、上层应用缺一不可。只有让各方面的能力得到更全面、更均衡的发展,才能在AI的道路上走得更远、更稳。

本文来自微信公众号“极智GeeTech”,作者:半山,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com