更换Transformer,7B开源模型立即登顶,可以随意处理长序列。

只需更换Transformer架构,立即全方位提升性能,问鼎同规模开源模式!

(注意机制不存在)

这便是最新Falcon Mamba 7B模型。

其采用Mamba状态空间语言模型架构处理各种文本生成任务。

在模型处理长序列时,通过撤销传统的注意机制,有效地提高了计算效率低下的问题。

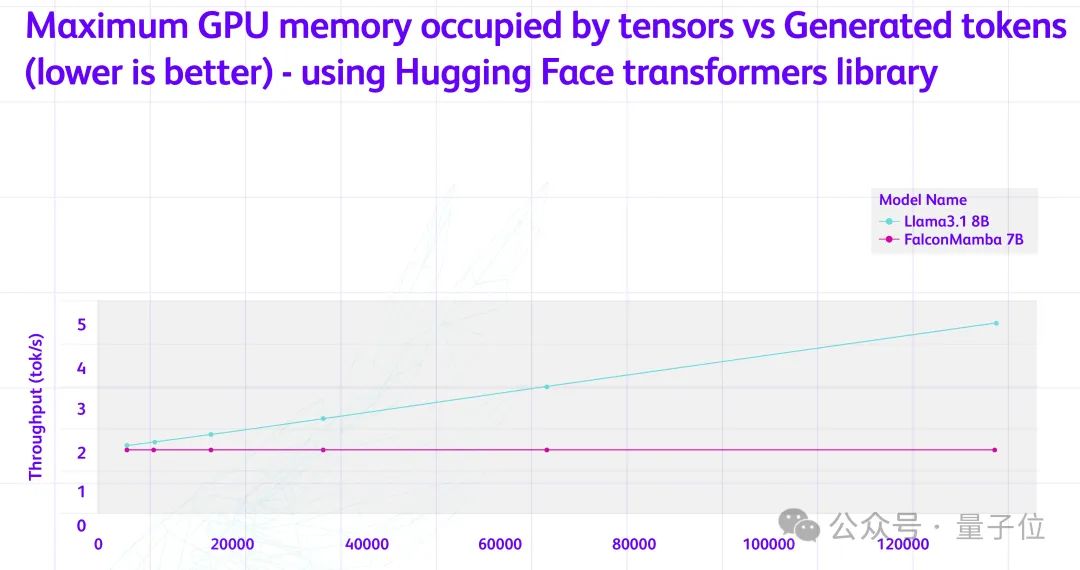

它可以处理无限长序列,但是内存需求没有增加。

无论前后文多长时间,每一个token的生成时间基本相同。。

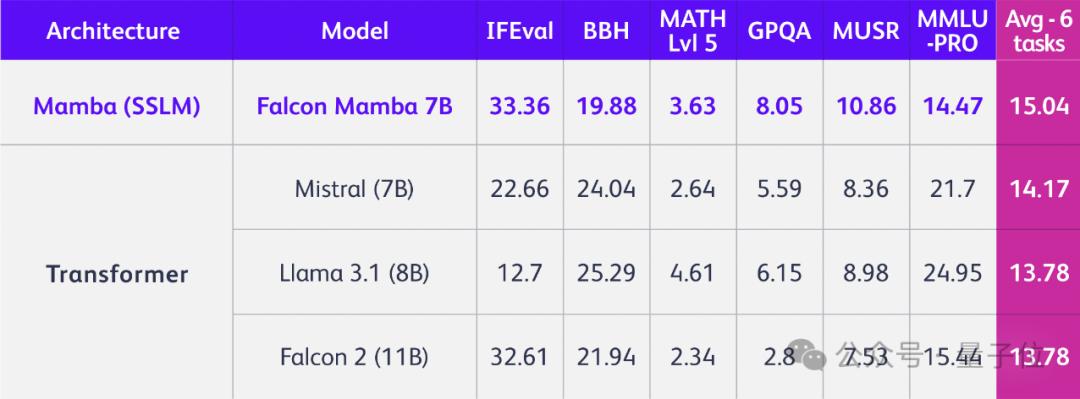

由此,Falcon 全面提升Mamba模型性能,击败Llama-3.1(8B)等众多Transformer架构模型。、Mistral(7B)和Falcon-2(11B)。

阿联酋阿布扎比技术创新研究所取得了上述成果(TII)他们就是Falcon模型开发团队。

该系列包括四种模式:基本版本、指令微调版本、4bit版本和指令微调版本。

最新模型遵循TII Falcon License Apachee2.0开放协议 2.0协议下。

围观者直呼:游戏规则要改变了!

世界上第一个开源SSLM

在性能上,Falcon Mamba 7B全方位超越了一批开源模型。

这是基于第一代Mamba。

Mamba是一种状态空间模型(SSM,State Space Model)。该系统结合了RNN和CNN的特点,通过引入一种选择机制,允许模型根据目前的输入有选择地传播或遗忘信息,从而提高处理文本信息的效率。

与此同时,它设计了一种以递归方式运行的硬件感知平行算法,避免了GPU内存层次之间的IO浏览,提高了计算效率。

最后,它还简化了结构,将SSM结构与Transformer中的MLP块结合在一起。

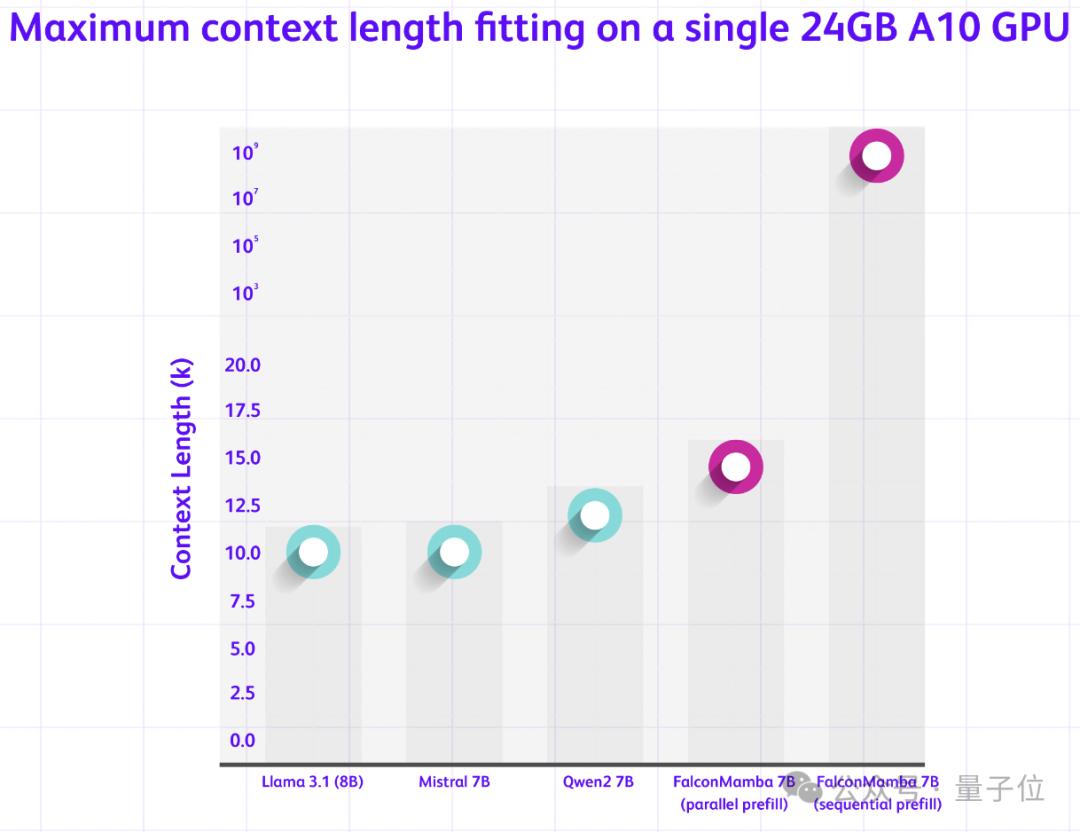

从Transformer到Mamba,Falcon模型可以在不增加内存的情况下处理随机的长序列。特别适合单个A10 24GB GPU。

研究还讨论了两种不同的处理序列方法。

并行预填充法适用于GPU并行计算,对内存要求较高;顺序添加法适用于SSM模型,可处理随机长度序列,不受内存限制。

为确保大规模训练的顺利进行,Falcon Mamba模型采用额外的RMS标准化层。

RMS标准化层可简化LayerNorm的计算步骤,减少计算量。

该模型采用5500GT数据训练,主要来自RefedWeb数据和公开数据。训练过程基本上是均速的,练习后期增加了一小部分高质量的策划数据,有利于模型在最后阶段的优化。

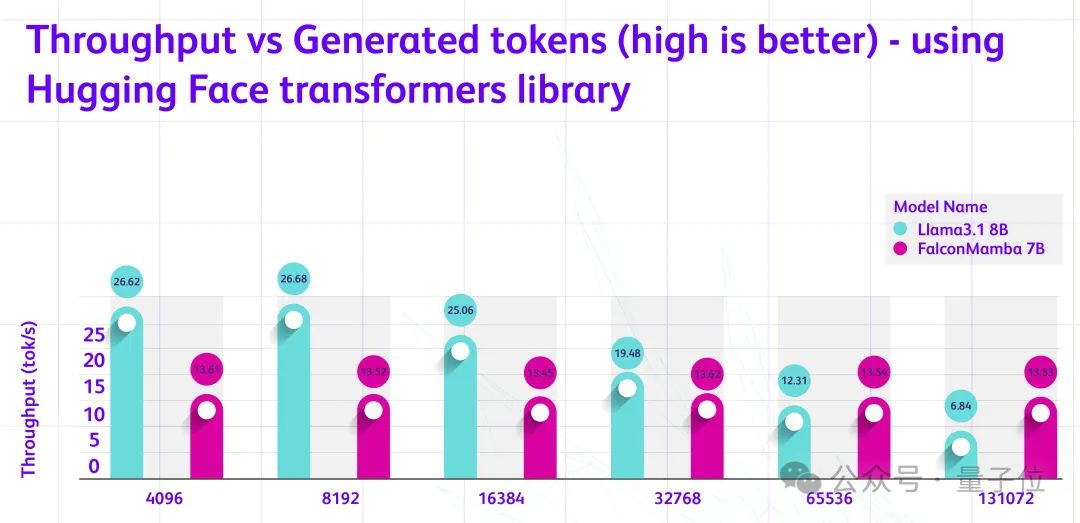

对于H100,批次大小为1。、在测试token时,提示词长度为1-130k,Falcon Mamba可以存在在生成新的token时,保持稳定的吞吐量。,也就是说,它的性能不受文字长度的影响,能够稳定地处理长序列,不会出现性能下降的情况。

Falcon 提供多种HuggingingMamba Face API,包含AutoModelForCausalLM、pipline。

另外还推出了一款指令调优版,通过50亿次token进行微调,可以使模型更加精确。

这是Hugging Face、最新的GitHub模型可以访问~

参考链接:https://huggingface.co/blog/falconmamba#hardware-performance

本文来自微信微信官方账号“量子位”,作者:关注前沿技术,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com