Ilya离职后的第一个动作:对这篇论文赞不绝口,网友们争相传看。

自Ilya 在官方宣布辞职OpenAI之后,Sutskever的下一步行动成为大家关注的焦点。

有些人甚至密切关注他的一举一动。

没有,Ilya刚刚在前面点赞。❤️有一篇新论文——

——后来网友们争相看中了:

这篇论文来自MIT,作者提出了一个假设,用一句话来概括阿姨的观点:

在不同的数据和模态下,神经网络练习的目标不同,现实世界统计模型倾向于在其表示空间中形成一个互通的模型。

这一推论被他们命名为柏拉图说假话,借鉴柏拉图的洞穴寓言及其对理想现实本质的概念。

Ilya的选择还是有保障的,有网友看了之后称之为今年最好的论文:

也有网友真的很有才华。看完之后,他们用安娜·卡列尼娜开头的一句话来总结:所有快乐的语言模型都差不多,每个不幸的语言模型都有自己的不幸。

化用怀特海名言:所有机器学习都是柏拉图的注脚。

我们也来看了一下,大概内容是:

对AI系统进行了分析。表征收敛(Representational Convergence),也就是说,不同神经网络模型中的数据点表征方式越来越相似,这种相似性跨越了不同的模型结构、训练目标甚至数据模式。

是什么促进了这种收敛?这一趋势会持续下去吗?它的最终归宿在哪里?

经过一系列的分析和实验,研究人员推断,这种收敛确实有一个终点,并且有一个驱动原则:各种模型都在努力实现对现实的精确表征。。

一张图片来解释:

其中图像(X)和文本(Y)这是共同的底层现实(Z)差异投射。研究人员推断,表征学习算法将收敛到统一表征Z,模型规模的增加和数据和任务的多样化是促进这种收敛的重要因素。

只能说,这是Ilya感兴趣的问题。太深奥了,我们不太明白。请AI帮我解读一下,和大家分享一下。~

表征收敛的证据

首先,作者分析了大量之前的相关研究,并开始了自己的实验,拿出了一系列表征收敛的证据,展示了不同模型的收敛、规模和性能以及跨模式的收敛。

Ps:这项研究侧重于向量嵌入的表征,即数据被转换为向量,数据点之间的相似性或距离被用核函数描述。本文中的“表征对齐”概念是,如果两种不同的表征方法揭示了相似的数据结构,那么这两种表征就被视为对齐。

1、不同的模型收敛,不同的结构和目标模型在底层表示上趋于一致。

目前,基于预训练的基础模型构建的系统数量正在逐渐增加,一些模型正在成为多任务的标准核心结构。这种在各种应用中的普遍适用性体现了它们在数据表征上的实用性。

虽然这一趋势表明AI系统正在向一组较小的基础模型集合收敛,但并不能证明不同的基础模型会形成相同的表征。

然而,最近有些与模型拼接。(model stitching)有关研究发现,即使对不同数据进行训练,图像分类模型的中间层表征也能很好地对齐。

例如,一些研究发现,在ImageNet和Places365数据上训练的卷积网络的初始层可以交换,这表明他们已经学会了类似的初始视觉表征。一些研究发现了大量的“罗塞塔神经元”(Rosetta Neurons),也就是说,在不同的视觉模型中被激活的高度相似的神经元…

2、模型的规模和性能越大,对齐程度越高。

在Places-365数据上,研究人员利用相互邻近的方法来衡量78个模型的对齐状态,并且评估了VTAB在视觉任务中的下游任务表现,以适应标准。

结果表明,具有较强泛化能力的模型集群之间的表征对齐度明显较高。

此前也有研究观察到,较大模型之间的CKA核心对齐度较高。理论上也有研究证明,类似模型的内部激活导出性能也必然相似。

3、各种模式模型的表征收敛。

在维基百科图像数据集WIT中,研究人员使用最近邻的方法来测量对齐度。

结果表明,语言-视觉对齐与语言建模结果之间存在线性关系,一般趋势是能力较强的语言模型与能力较强的视觉模型对齐较好。

4、由于面对类似的数据和任务约束,模型和大脑表征也表现出一定程度的一致性。

2014年,研究发现,神经网络的中间层激活与大脑视觉区域激活高度相关,可能是由于视觉任务和数据约束相似。

此后,研究发现,使用不同的训练数据会影响大脑和模型表征的对齐水平。心理学研究还发现,人类感知视觉相似性的方式与神经网络模型高度一致。

5、模型表征的对齐程度与下游任务的性能成正相关。

研究人员使用两个下游任务来评估模型的性能:Hellaswag(常识推理)和GSM8K(数学)。为了衡量其它语言模型与视觉模型的对齐程度,使用DINOv2模型作为参考。

测试数据显示,Hellaswag和GSM8K任务中与视觉模型对齐程度较高的语言模型也具有较好的性能。可视化数据显示,对齐水平与下游任务性能成正比。

以前的研究在这里就不展开了,有兴趣的家庭成员可以查看原文。

收敛的原因

随后,通过理论分析和实验观察,研究小组提出了表征收敛的潜在原因,并讨论了各种因素如何共同作用,导致不同的模型在表达现实世界时趋于一致。

在机器学习领域,模型训练目标需要减少训练数据中的预测误差。为了避免模型过度拟合,训练过程中通常会增加正则项目。正则化可以是隐藏的,也可以是显示的。

在这一部分,研究人员阐述了这一提升过程中,下面的每一个彩色部分如何能够在促进表征收敛中发挥作用。

1、任务的实用性导致收敛(Convergence via Task Generality)

为了解决更多的任务,模型被训练,他们需要找到能够满足所有任务需要的标志:

能够胜任N个任务的表征数量少于能够胜任M个任务的表征数量(M < N)所以,当训练可以同时处理多个任务的更通用的模型时,可行的解决方案就会减少。< N)任务表征数量。因此,当训练能同时处理多个任务的更通用模型时,可行的解决方案将会减少。

以前也提出过类似的原理,图中就是这样的阿姨:

而且,简单的任务有很多解决方案,而困难的任务解决方案很少。因此,随着任务难度的增加,模型表征趋于收敛到更好的解决方案和更少的解决方案。

2、模型容量导致收敛(Convergence via Model Capacity)

研究人员指出,如果有一个全局最优的表征,那么在数据充足的情况下,更多的模型更有可能接近这个最优解。

因此,无论其结构如何,使用相同训练目标的大型模型都会趋于收敛这种最优解。当不同的训练目标有相似的最小值时,更大的模型可以更有效地找到这些最小值,并且在每个训练任务中趋于类似的解决方案。

插图就是这样的阿姨:

3、简单偏差导致收敛(Convergence via Simplicity Bias)

关于收敛的原因,研究人员也提出了一个假设。深度网络侧重于数据的简单拟合,这种内在的简单偏差促使大模型在表达上趋于简化,从而导致收敛。

换句话说,更大的模型覆盖范围更广,可以通过所有可能的方式拟合同数据。然而,深度网络的隐性和简单性偏好鼓励更大的模型找到这些解决方案中最简单的一个。

收敛的终点

经过一系列的分析和实验,如开头所述,研究人员提出柏拉图说假话,推断出这种收敛的终点。

也就是说,虽然不同的AI模型受到不同的数据和目标的训练,但它们的表示空间正在收敛于一个共同的统计模型,这代表着生成我们观察到的数据的现实世界。

首先,他们构建了一个理想的离散事件世界模型。世界包括一系列离散事件Z,每一个事件都是从一个未知的P分布中分布出来的。(Z)从中取样。每一个事件,如像素、声音、文字等,都可以通过观测函数obs进行不同的观测。

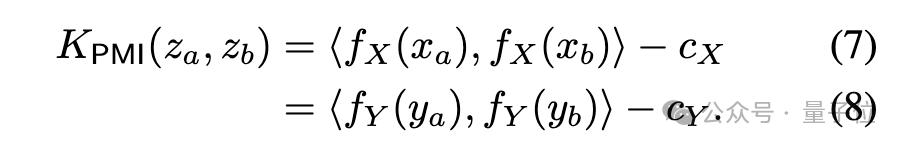

下一步,作者考虑了一种比较学习算法,试图学习一种表征fX,促使fX学习。(xa)和fX(xb)内积与xa和xb作为正样对(来自近距离观察)的大多数odds和作为负样对(随机采样)的大多数odds相似。

在数学推导之后,作者发现,如果数据足够平滑,这个算法就会收敛到xa和xb的点互信息。(PMI)核表征fX。

由于研究侧重于一个理想的离散世界,观测函数obs是双射的,所以xa和xb的PMI核等于za和zb的PMI核。

也就是说,无论是从视觉数据X还是语言数据Y中学习表征,最终都会收敛到表示P。(Z)相同的核函数,即事件之间的PMI核。

研究人员通过对颜色的实证分析来检验这一理论。无论是从图像像素的共现统计,还是从文字的共现统计中学习颜色表征,获得的颜色距离都与人类的感知相似,这种相似度随着模型规模的增加而越来越高。

它符合理论分析,即更多的模型能力可以更准确地建模观测数据的统计量,从而获得更接近理想事件表征的PMI核。

最终的一些思考

在论文的最后,作者总结了表征收敛对AI领域和未来研究角度的潜在影响,以及柏拉图表征假设的潜在限制和例外。

它们指出,随着模型规模的增加,收敛可能带来的影响包括但不限于:

看起来简单的扩大规模可以提高性能,但是不同的方法在扩展效率上存在差异。

如果有与模式无关的柏拉图表征,不同模式的数据应该通过联合训练找到这个共享表征。这解释了为什么在语言模型训练中添加视觉数据是有益的,反之亦然。

对齐表征之间的转换应该比较简单,这可能解释了有条件的生成比无条件的生成更容易,没有匹配的数据也可以实现跨模态转换。

在不加重误差的情况下,模型扩大可能会减少语言模型的虚构内容倾向和其它误差,使其更准确地反映训练数据中的误差。

作者强调,上述影响的前提是未来模型训练数据要足够多样化和无损化,才能真正收敛到反映实际世界统计规律的表征。

同时,作者还表示,不同模式的数据可能包含独特的信息,这可能会导致即使模型规模增加,也很难达到完全的表示收敛。此外,目前并不是所有的表征都在收敛,例如机器人领域没有标准化的表征。研究人员和社区的偏好可能会导致模型向人类的表征收敛,从而忽略其他可能的智能模式。

并专门为特定任务智能系统设计,或许不会与通用智能相同。

作者还强调,测量表示对齐的方法存在争议,不同的测量方法可能会导致不同的观点。即使不同的模型有相似的表达,也有差距需要解释。目前还不确定这个差距是否重要。

更多的细节和论证方法,把论文放在这里。~

论文链接:

https://arxiv.org/abs/2405.07987

参考链接:

[1]https://x.com/phillip_isola/status/1790488966308769951

[2]https://x.com/bayeslord/status/1790868039224688998

本文来自微信微信官方账号“量子位”(ID:QbitAI),作者:西风,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com