AI手机,活出行业的“摇钱树”

早些年出现的折叠屏未能挽救手机行业的衰落,证据是去年全球出货量仍在拉胯,同比下降3.2%近十年来,达到11.7亿部,最低。

幸好Q4出现了一点回暖,全球市场和中国市场分别为8.5%和1.2%同比增长,尤其是后者,在连续同比下降10个季度后首次转正。

很难说这其中没有AI的功劳。

从2023年下半年开始,以谷歌、三星、OPPO为代表的厂商将大模型内置到智能手机中,完成了从云AI向终端AI的转变,AI手机浪潮正式开启。

IDC甚至预测,2024年全球新一代AI手机出货量将达到1.7亿部,占智能手机总出货量的近15亿部。%。

所以AI就成了比折叠屏更有效率的“救命稻草”,但是在产业链眼里,TA更像是一棵“摇钱树”。

01 端边AI可以省钱

去年九月,高通发布了一份关于AI未来的简洁标题——混合AI的报告。

本报告的核心是高通通过大模型云推理的“停机”现象,真正的首选是再次向市场强调终端与云协同工作的混合AI。

所谓混合AI,就是以云为中心的场景,终端会根据自己的能力,在可能的情况下从云中分担AI的工作负荷;但在其他场景中,计算将主要以终端为核心,必要时将任务转移到云端。

高通的逻辑是,与传统计算相比,从大型主机和瘦客户端演变为当前云和PC。、边缘终端结合的模式,如智能手机,生成式AI也将形成云端与终端的结合。

但是这份报告的真实意图,是高通提出的两大趋势:

AI计算率将从目前的云集中部署逐步转变为云与终端的灵活分配;大型模型将逐步渗透到终端。

事实上,在高通拿出这份报告之前,它的合作伙伴已经这样做了很长时间,而且之所以跑得快,不仅仅是为了准确预测未来的趋势,更重要的是为了省钱。

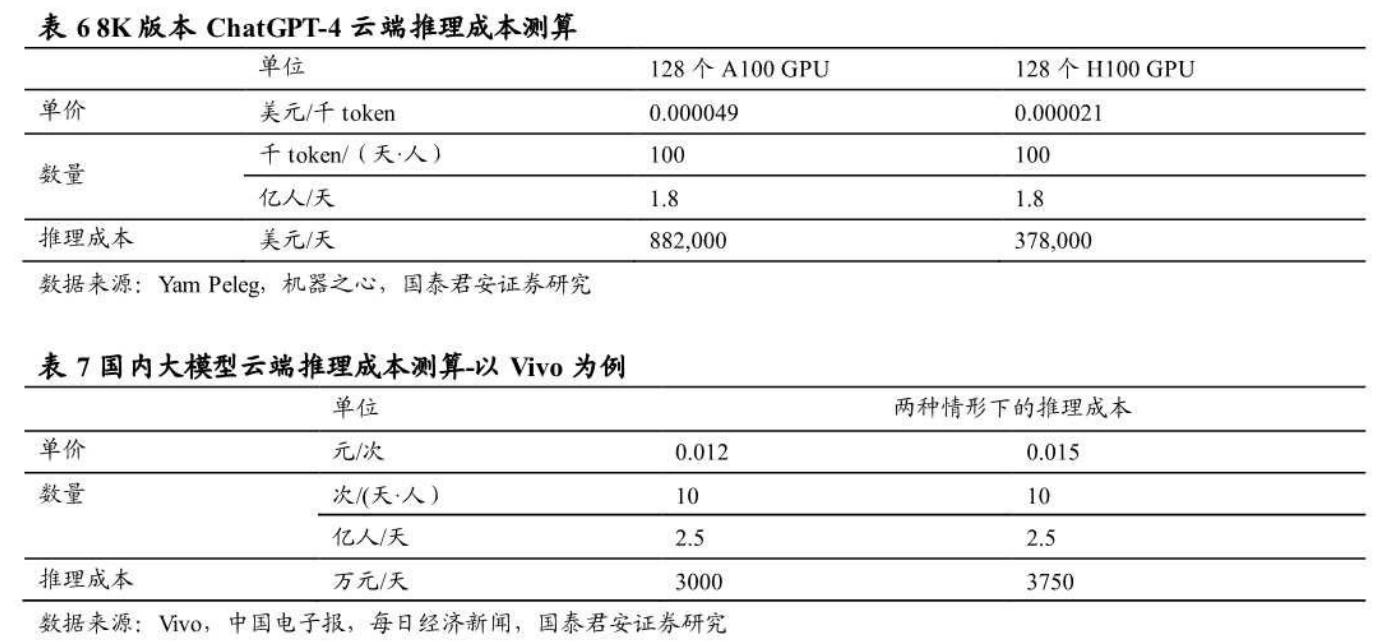

Deep算法交易企业 Yamm创始人Trading Peleg曾经算过一笔账,8K版ChatGPT云推理费用为0.0049元。/千token(128个A100 GPU)。ChatGPT4云推理的成本约为88.2万美元,以全球1.8亿日活跃用户和每人每天100千token推理的需求计算。/天。

假如转移到用户数量较多的智能手机上?

根据vivo副总裁周围公布的数据,vivo大模型的一次对话费用约为0.012-0.015元。/第二,目前vivo的全国用户数量约为3亿。日活客户2.5亿(假设未来渗透率天花板)、每个人每天进行10次对话,vivo大模型每天的云推理费用为3000-3750万元。

假设以50%分流计算,将一半的推理分流到终端,那么vivo每年将节省云运算成本55-68亿元。

为了钱,不搞终端AI是不够的。然而,虽然手机制造商的目标高度一致,但在处理大型手机内存瓶颈方面存在矛盾。

02 三条路线

众所周知,大型语言模型的泛化能力和实用性取决于其参数。例如,GPT-4拥有16个专家模型,其中包含18000亿个参数。大多数大型模型都在云端运行,有强大的服务器硬件支持。如果直接部署在智能终端上,设备需要有足够的内存。

即使是参数较少的主流AI模型也有70亿或130亿参数,每个模型都需要大约14GB和20GB的内存。举例来说,拥有70亿参数的小型LLaMA,其FP16版本大小为14GB,远远超过了当前手机的内存承载能力。

为解决这一难题,目前主要有三条技术路线:一是直接提高终端内存,二是压缩大模型体积,三是提高内存调用逻辑。

三条路线分别对应三个阵营。以微软、联想、OPPO为代表的力量致力于大模型压缩路线。苹果计划通过优化闪存交互和内存管理逻辑来解决内存堡垒,并希望通过直接增加终端内存来突破瓶颈的3DDram技术,代表内存制造商。

第一,大模型压缩规模最大,主要包括量化、修枝、蒸馏等多种方案。

大型模型压缩翻译实际上是在不影响性能的情况下减少模型资源的占用。例如,AquilaChat2-34B只需接近7B等级模型GPU的能耗,就可以提供超过Llama2-70B的模型性能,同时大大减少70B的内存占用%,而且综合性能参数仅减少0.7%。

例如,微软SliceGPT技术属于修枝策略,测试数据显示,该技术可以是LLAMA-2 70B、OPT 清除66B和Phi-2模型高达25。%模型参数(包括嵌入),各自保持密集模型99%、99%和90%零样本任务性能。

其次,提高内存管理。根据前面的分析,70亿参数模型只需要超过14GB的内存才能载入参数,这超出了大多数智能手机的能力。

苹果建议将模型参数存储在至少比DRAM大一个数量级的闪存中,然后在推理过程中直接巧妙地将所需参数从闪存中载入。

具体而言,苹果建立了以闪存为核心的推理成本模型,并使用窗口化(Windowing)还有团队捆绑(Row-Column Bundling)为了最大限度地减少数据传输,最大限度地提高闪存吞吐量,两项核心技术。

这里就不赘述更具体的技术实现步骤了。简而言之,苹果的闪存方法已经完成了可以比设备DRAM容量运行两倍的模型,在CPU和GPU上比传统方法加速4-5倍和20-25倍。

在此之前,美光CEO表示,AI手机的内存容量预计将比今天的非AI旗舰机高500。%到100%。除压缩和优化外,另一种看似愚蠢的方法是直接提高终端内存,即3D Dram(垂直存储器)技术。

3D Dram是一种将存储单元放置在二维阵型中,通过垂直叠加显著提高容量的技术。相当于覆盖复式,减少平面面积占用,增加单位面积的存储容量,从而最大化容量。

根据Neo 估计Semiconductor,3D X-可跨230层实现DRAM技术。 目前DRAM密度的8倍是128Gb密度。NEO提出了每十年容量增长8倍的目标,目标是在2030-2035年间实现1Tb容量,比目前DRAM的核心容量增长64倍。

03 谁能获益?

虽然路线不同,但是在可行性的前提下,每一个阵营都能达到预期的效果。

比如芯片厂,无论是高通还是MTK,都在实施端AI下的大模型压缩。自然,目的是让下一代芯片支持手机厂商嵌入大模型的需求。只要满足了这个需求,他们就可以成为第一个获得红利的人。

在4G到5G的迭代过程中,高通依靠特殊的供需关系,直接将手机厂商的芯片采购成本翻了一番。

例如,GalaxyS20 Ultra(12G+在物料成本256G中,骁龙865 与2019年上半年不包括X50基带的骁龙8555相比,SoC的总成本超过150美元。 大约是4G移动平台的两倍。

芯片厂对手机厂商也有绝对的议价权。在供需失衡的情况下,价格控制能力更强的一方非常愿意打上支持端AI的SoC价格。

除了SoC之外,还有一种零件可以从这波AI升级中受益,但是也许每个人都没有想到。

在三星S24系列拆卸结果中,人们发现不仅石墨散热器增加了,而且平均散热器面积也增加了。计算S24、S24+、S24 Ultra各自大了1.5。、1.6、1.9倍。

最后,S24 与上一代5G手机相比,Ultra中添加的散热材料多了11元。如果考虑到高性能、高价格的石墨烯渗透率增加带来的价值增加,可以再增加3元。

还有一个部件,类似于SoC的内存。

如前所述,在模型体积压缩、内存调用逻辑提升、3DDram技术发展等三条路线的共同作用下,目前的16/24GB内存已经具备运行端大模型的条件,未来内存空间仍有提升跳跃的空间,容量不再受约束。更迫切的需求是提高带宽以适应复杂的AI任务。

LPDDR已正式完成JEDEC固态技术协会 预计2024年第三季度将正式发布6个内存标准的最终决定。目前LPDDR5X内存主流带宽为8533Mbps,LPDDR6带宽可达12.8Gbps,与LPDDR5X相比,54高%,LPDDR6X还有17Gbps的带宽。

得益于AI手机对高带宽内存的需求,预计LPDDR5/LPDDR5X/LPDDR6将继续供不应求。三星和海力士申请LPDDR6 经过RAM认证,LPDDR6内存将首次量产,与芯片厂一样,LPDDR6的供需关系也决定了它的涨价。

04 尾声

在这场技术迭代革命中,作为下游手机厂,是要争取主动的。

AI产生的换机浪潮确实会带来一波量价上涨,但是参照上一轮迭代,仅靠组装的手机厂商无法获得大规模的溢价。

换言之,要想获得更多的红利,特别是在软硬件成本高的情况下,需要具备自主研发的能力,比如最重要的大模型和芯片。

当然,在今天的环境下,高模型培训成本和供需错配的高性能AI推理芯片对手机厂商提出了严峻的考验。然而,如果你同时具备这两种自主研究能力,你将具有成本可控和供应稳定的综合优势。

而且其他没有或者没有完全拥有的厂商,也不一定会被淘汰。不能把握上游,可以转身把握下游。

智能化手机的下游,就是移动互联网。

高度智能的AI手机应该摆脱臃肿多样的APP,垂直整合端应用,深度连接每一个单独的荒岛。客户可以通过一个指令调动多个APP自动解决需求,提供一站式服务。

因此,高度智能化的手机必须集成各种数据、权限和应用程序,但单个应用程序不能这样做。因此,自然占据各种功能入口的手机厂商有可能取代一些应用程序开发商,进一步划分流量和实现。

以智能修图、音频摘要功能为例,运行侧大模型的AI手机将部分或全部替代孤立的修图类(如美图秀秀)、音频类App(如讯飞听到),这类功能将集成到手机的操作系统中,完全内置于拍摄、通话等功能中。

对这个App来说,这一切都已经发生了,将来还会有更多的App被整合和取代。

本文来自微信公众号“解码Decode”(ID:作者:解码工作室,36氪经授权发布,kankeji001)。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com