发布几个小时后,微软秒删堪比GPT-4开源模型,竟因为忘记了下毒检测。

【导读】不久前,微软发布并开源了最新一代WizardLM-2,声称性能堪比GPT-4。然而,在推出一天之前,模型权重和公告都被删除了,原因是...

上个星期,微软空降了WizardLM-2,可以称之为GPT-4级开源模型。

没想到发布几个小时后,马上就被删除了。

有网友突然发现,WizardLM模型的权重和公告帖子都被删除了,微软的官方项目也没有证据证明,除了提到网站。

GitHub项目首页已经成为404。

项目地址:https://wizardlm.github.io/

HF中包含模型的权重,也全部消失...

整个网络都充满了疑惑,WizardLM怎么没了?

不过,微软之所以这么做,是因为团队内部忘记了做模型。「检测」。

随后,微软团队出现道歉并解释说,自从WizardLM几个月前发布以来,已经有一段时间了,所以我们对新的发布过程并不熟悉。

在模型发布过程中,我们不小心错过了一项内容。 :下毒检测

升级二代微软WizardLM

第一代WizardLM于去年6月发布,基于LlaMA微调,引起了开源社区的极大关注。

论文地址:https://arxiv.org/pdf/2304.12244.pdf

接着,WizardCoder的代码版诞生-一个基于Codee的 Llama,使用Evol-Instruct微调模型。

测试数据显示,WizardCoder在HumanEval上的pass@1达到了惊人的效果。 超过原始GPT-4的73.2%。

4月15日,微软开发者正式宣布新一代WizardLM,这次是从Mixtrall开始的。 微调8x22B。

它包含8x22B3个参数版本,、70B和7B。

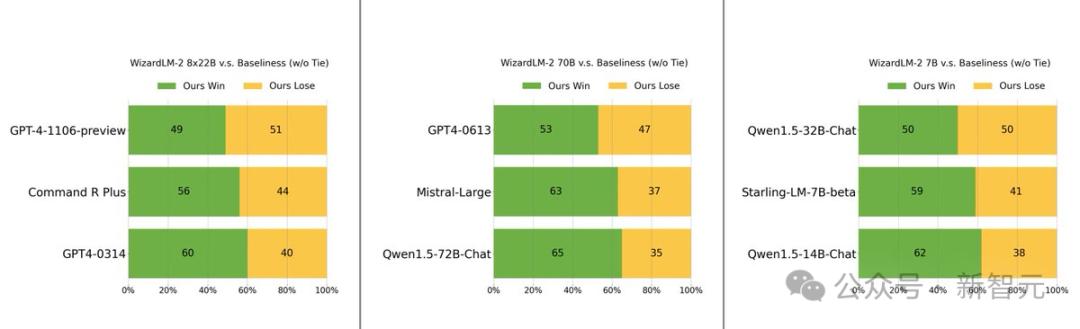

在MT-Bench基准测试中,新型号在MT-Bench基准测试中具有领先优势。

具体而言,WizardLM最大参数版 8x22B模型性能,接近GPT-4和Claude 3。

70B版本在相同参数规模下排名第一。

而且7B版本是最快的,甚至可以达到相当于10倍大参数的领先模型的性能。

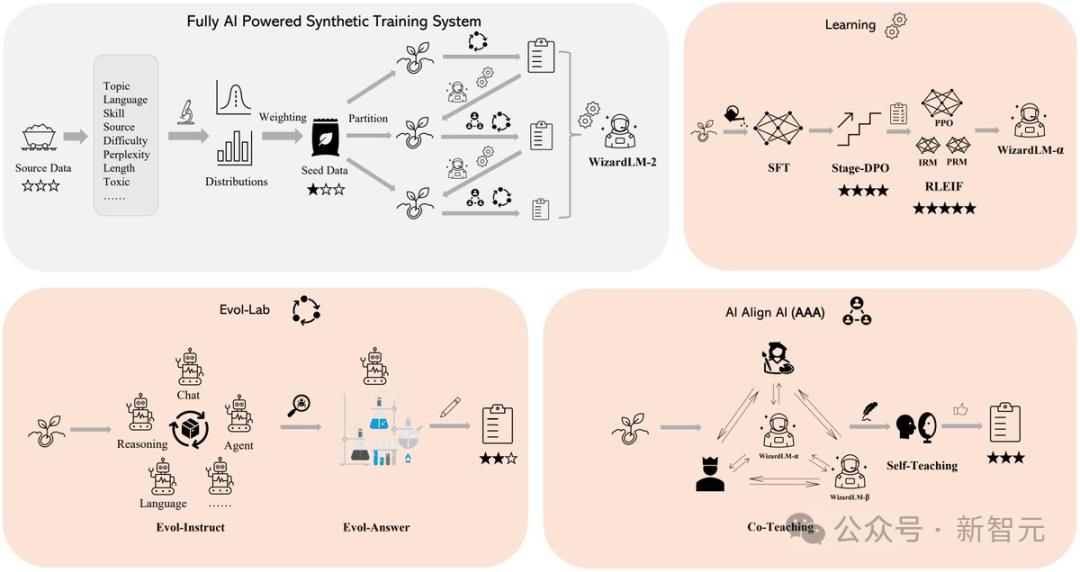

WizardLM 2优秀表演背后的秘诀在于,EvoleEvol是微软研发的革命性训练方法。-Instruct。

Evol-使用大型语言模型,Instruct迭代地将初始指令集改写成越来越复杂的组合。接着,利用这些演变指令数据对基本模型进行微调,从而显著提高其处理复杂任务的能力。

另外一种是加强RLEIF的学习框架,也是WizardLM 2在发展过程中起着重要作用。

WizardLM 在2次训练中,AI也被采用。 Align AI(AAA)方法,可以让多个领先的大模型相互指导和优化。

AAA框架由两个主要部件组成,「共同教学」和「自学」。

在共同教学阶段,WizardLM和各种获得许可的开源和专有先进模型进行模拟聊天、质量评估、改进建议和缩小技能差距。

模型可以通过相互交流,提供反馈,向同行学习,提高自己的能力。

WizardLM可以通过主动自学,为监督学习生成新的进化训练数据,为强化学习生成喜好数据。

这一自学机制允许模型在学习过程中产生自己的数据和反馈信息,从而不断提高性能。

此外,WizardLM 2模型训练采用合成数据生成。

在研究人员看来,大型培训数据日益匮乏,相信AI精心建立的数据和AI逐步监管模型将是通向更强大人工智能的唯一途径。

所以,他们建立了一个完全由AI驱动的生成训练系统,以改善WizardLM-2。

手快的网友,已经安装了权重

但是,在数据库被删除之前,许多人已经安装了模型权重。

在这个模型被删除之前,几个客户仍然对一些额外的标准进行了测试。

幸好测试的网友对7B模型记忆深刻,并表示这将是自己执行当地助理任务的首选模型。

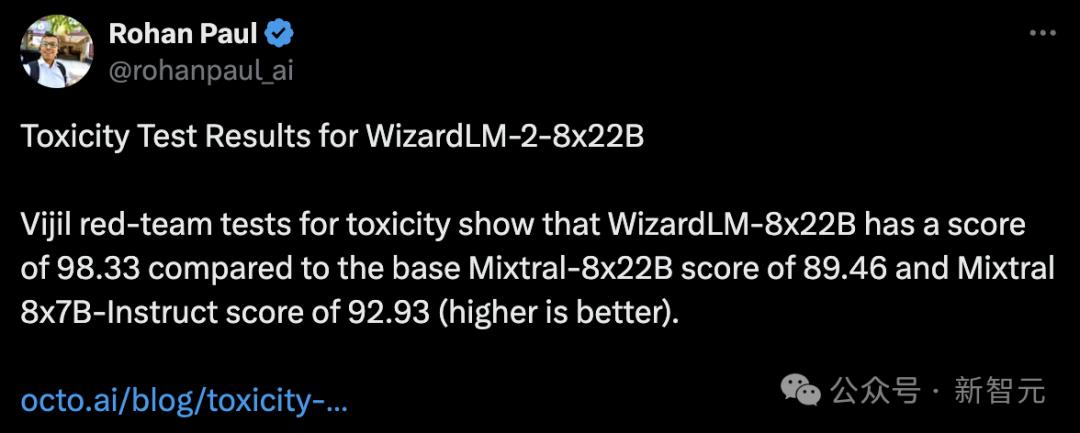

另一些人对此进行了下毒检测,发现WizardLM-8x22B得分为98.33,而基本Mixtral-8x22B得分为89.46,Mixtral 8x7B-Indict得分为92.93。

得分越高越好,换句话说,WizardLM-8x22B仍然很强。

如果没有下毒检测,把模型传出去是绝对不可能的。

大型模型容易产生幻觉,众所周知。

假如WizardLM 2在答案中导出「有毒,有偏见,不正确」对于大型模型来说,内容并不友好。

尤其是,这些错误引起了全网的关注,对微软本身来说也会引起争议,甚至会受到政府的调查。

有些网友疑惑道,你可以通过「下毒检测」更新指标。为什么要删除整个版本库和权重?

根据最新的内部规定,微软作者表示,只能这样操作。

还有人说,我们只是希望没有。「脑叶切除」模型。

但是,开发者还是要耐心等待,微软团队承诺,检测结束后再上线。

参考资料:

https://favtutor.com/articles/wizardlm-2-benchmarks/

https://anakin.ai/blog/wizardlm-2-microsoft/

本文来自微信微信官方账号“新智元”(ID:AI_era),作者:新智元,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com