AI时代新风口,吴恩达亲授智能体四大设计模式

吴恩达认为,智能体的发展将成为AI时代的重要力量,甚至比基本模型更重要。下班后,「吴老师」连续发布多个博客,向大家介绍了AI智能体的四种设计模式。

AI时代的风口在哪里?

吴恩达认为,AI 今年,Agent将推动人工智能的大规模进步。

——即使是下一代基础模型也有可能产生影响。

他希望所有从事人工智能工作的人都能关注AI智能体的发展。

Andrew Ng

大佬「退伍」之后,作为专业人士「教书先生」,依然孜孜不倦,授业传道解惑。

最近,在业余时间,吴恩达继续分享许多关于智能体的意见,并定义了AI。 四种Agent设计模式,

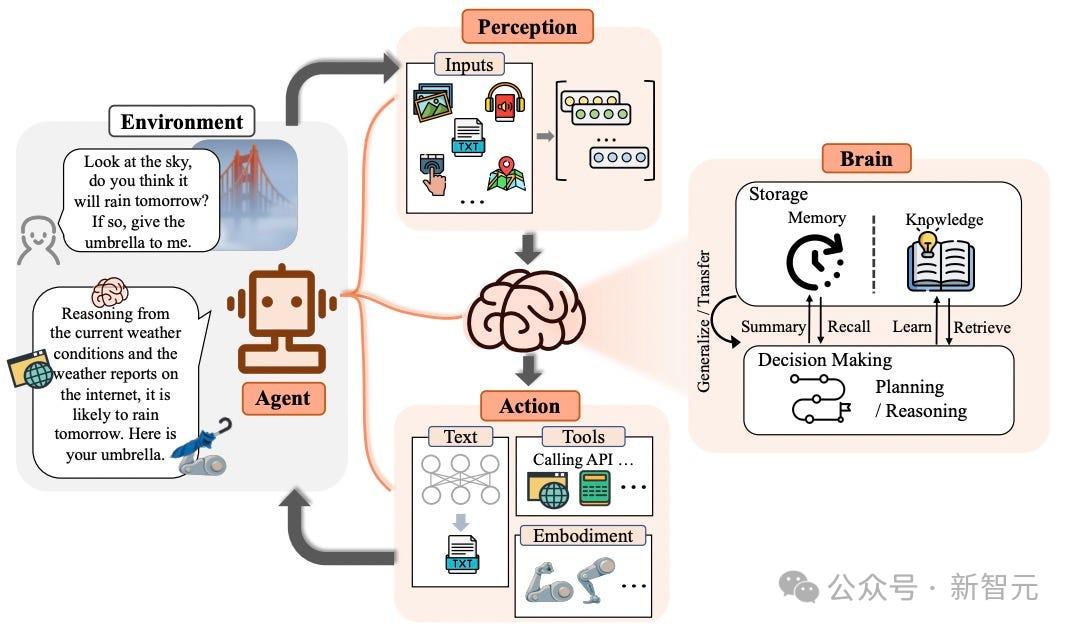

Reflection(反思)、Tool use(使用工具)、Planning(计划)和Multi-agent collaboration(多智能体协同):

-反省:LLM检查自己的工作,并提出改进的方法。

-使用工具:LLM利用Web搜索、代码执行或任何其它功能的工具,帮助自己收集信息,付诸行动或处理数据。

-计划:LLM提出并实施多步计划来实现目标(比如一篇论文,先写大纲,然后搜索研究各部分内容,再写稿子)。

-多个AI体合作:多个AI体合作 与单个智能体相比,agent协调工作、分工任务、讨论和辩论思路提出了更好的解决方案。

智能体工作流程

大多数人使用LLM通常是zero-shot方法,模型根据需要逐个导出token,没有回到修改的机会。

——这相当于要求人类从头到尾一口气写完一篇文章,不能回头。——虽然这是一个艰难的要求,但大模型目前做得非常好。

但是事实上,我们人类正常的工作流程通常是迭代的。

例如,对于一篇文章,可能需要:

计划一个大纲;通过网络搜索收集更多信息;

写原稿;

阅读原稿,发现不合理的论点或不相关的信息;

反复修改...

这样的工作方法对人类写好文章尤为重要,-那么对AI来说,是否也应该如此?

不久前,世界上第一位AI程序员Devin的演示,在社交平台上引起了轰动。

因此,吴恩达团队对HumanEval编码基准测试中的多种算法进行了研究,如图所示:

在zero 在shot情况下,GPT-3.5的正确率为48.1%,GPT-4表现更好,达到67.0%。

但是,在加入了智能体迭代工作流程之后,GPT-与GPT-3.5相比,3.5的正确率直接飙升到95.1%,-Agent的工作流效果显著,GPT-3.5的提升更为令人印象深刻。

现在,各种开源智能体工具相关研究的总数正在飙升,善于使用这些工具和经验,会使你的LLM更强大。

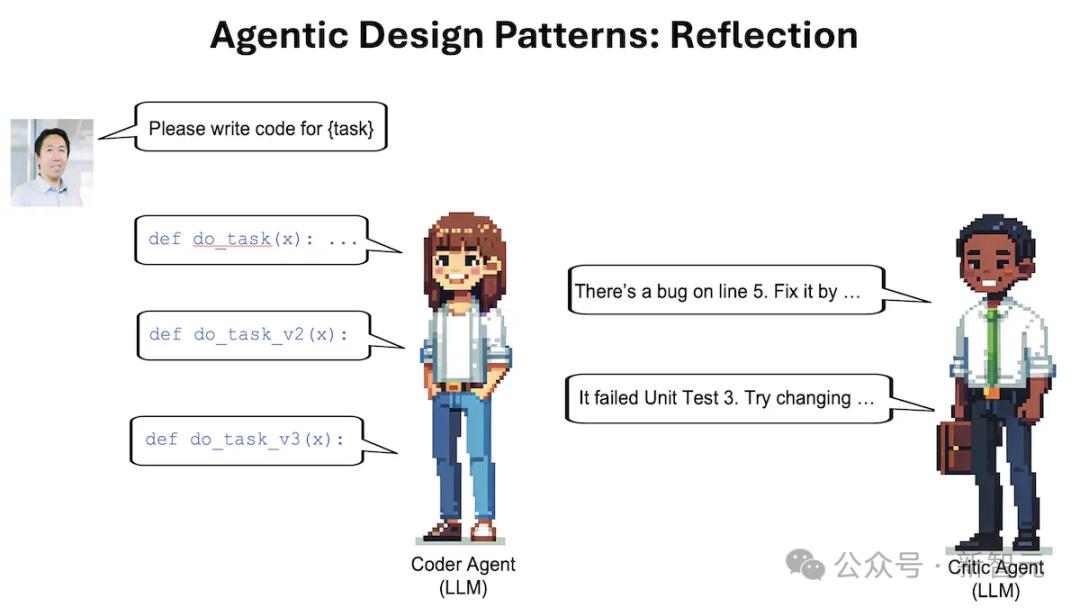

Reflection

反省,作为一种易于快速实现的设计模式,已经带来了令人惊讶的性能影响。

在LLM中,我们可能有过这样的经历:( ChatGPT/Claude当给出的结果不尽如人意时,我们可以提供一些反馈,当LLM再次导出时,我们可以给出更好的反馈。

——如果LLM自己执行这个反馈过程,会不会更好?这就是反思。(Reflection)。

以编码任务为例,LLM可以通过类似的提示反思自己的导出:

它是用来完成任务的 X 代码,仔细检查代码的准确性、风格和质量,并就如何改进它提出建设性的指责。

下一步,将之前产生的代码和反馈放入提示的前后文本中,并要求LLM根据反馈重写代码。

当然,我们也可以使用一些工具来评估LLM的导出质量,使上述过程更加进一步,

例如,通过单元测试来检查代码在功能测试中的结果,或通过web搜索来检查导出的准确性。

另外,还可以使用多智能体框架来实现Reflection,如上图所示。:一方负责生成导出,另一方面重点是对导出提出建议。

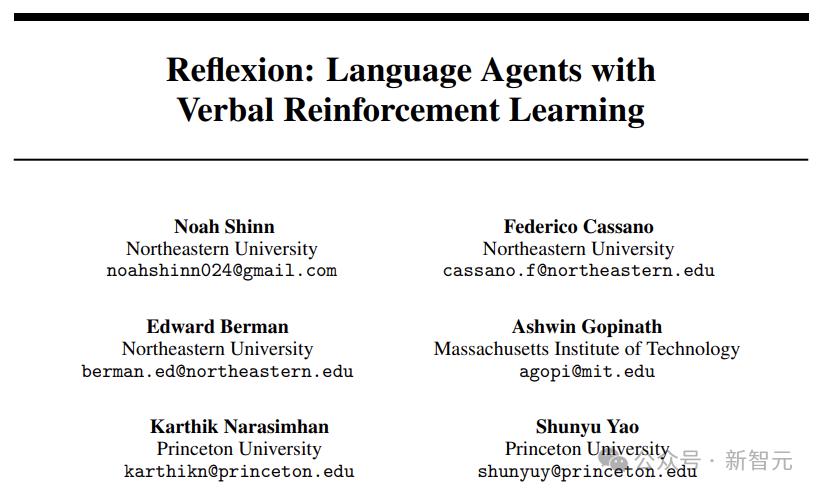

假如你对Reflection感兴趣,这里推荐以下文章,可以提供更多的相关知识:

论文地址:https://arxiv.org/pdf/2303.17651.pdf

论文地址:https://arxiv.org/pdf/2303.11366.pdf

论文地址:https://arxiv.org/pdf/2305.11738.pdf

Tool Use

使用工具时,LLM可以调用给定的函数来收集信息、付诸行动或操作数据,这是AI智能体工作流程的关键设计模式。

最常见的例子是LLM可以使用工具来执行Web搜索或代码执行。事实上,一些面向消费者的大企业已经使用了这个功能。

比如你问Copilot这样的在线LLM?:「哪个是最好的咖啡机?」,它可以决定进行网络搜索,并且下载一个或多个网页以获得前后文本。

归根结底,仅仅依靠预训练的Transformer来生成导出答案是有限的,而提供Web搜索工具可以使LLM做得更多。

LLM使用特殊的字符串,例如 {tool:web-search,query:coffee maker reviews} ,要求调用搜索引擎。

后处理步骤将查找字符串,调用具有相关参数的Web搜索函数,并将结果添加到输入前后文本中,并将其传输回LLM。

例如,如果你问,「假如我在12年内获得7%的复利,投资100美元,最终会获得多少收益?」,

使用代码执行工具,运行Python指令,LLM可以计算:{tool:python-interpreter,code:100 *(1 **12}0.07。

现在这个过程更接近一步,我们可以搜索不同的源头。(Web、Wikipedia、与各种生产力工具(发送电子邮件、阅读/写日历内容等)进行交互。),并希望LLM自动选择合适的函数调用来完成工作。

另外,当有太多的函数可以使用时,所有的函数都不能放在前后的文本中。此时,可以使用启发方法,选择LLM前后文本中最相关的子集。

事实上,当有太多的文本不能作为前后文本包含时,检索增强生成。(RAG)该系统还采用相同的方法,选择要包含的文本子集。

这里还推荐几篇相关文章:

论文地址:https://arxiv.org/pdf/2305.15334.pdf

论文地址:https://arxiv.org/pdf/2303.11381.pdf

论文地址:https://arxiv.org/pdf/2401.17464.pdf

Planning

计划,利用LLM将目标任务分解成较小的子任务,然后独立决定执行过程。

例如,如果我们要求智能体在线研究给定的主题,LLM可以将其拆解为特定的子主题,综合发现,编写报告。

曾经,ChatGPT的发布让很多人经历过。「ChatGPT时刻」,人工智能的能力远远超出了每个人的预期。

——而相似的「AI Agent时刻」,也许很快就会到来。

吴恩达回忆起之前的一次现场展览,由于网速问题,Agent的Web搜索API回归了错误,——Agent实际上转向了维基百科的搜索工具,最终完成了任务(救了大命)。

吴恩达说,看到Agent以意想不到的方式完成任务并取得成功是一件美好的事情。

但也有网友表示,大事不好啦,Agent失控了!

事实上,有许多任务不能通过单一步骤或单一工具来完成,但是Agent可以决定要执行哪些步骤。

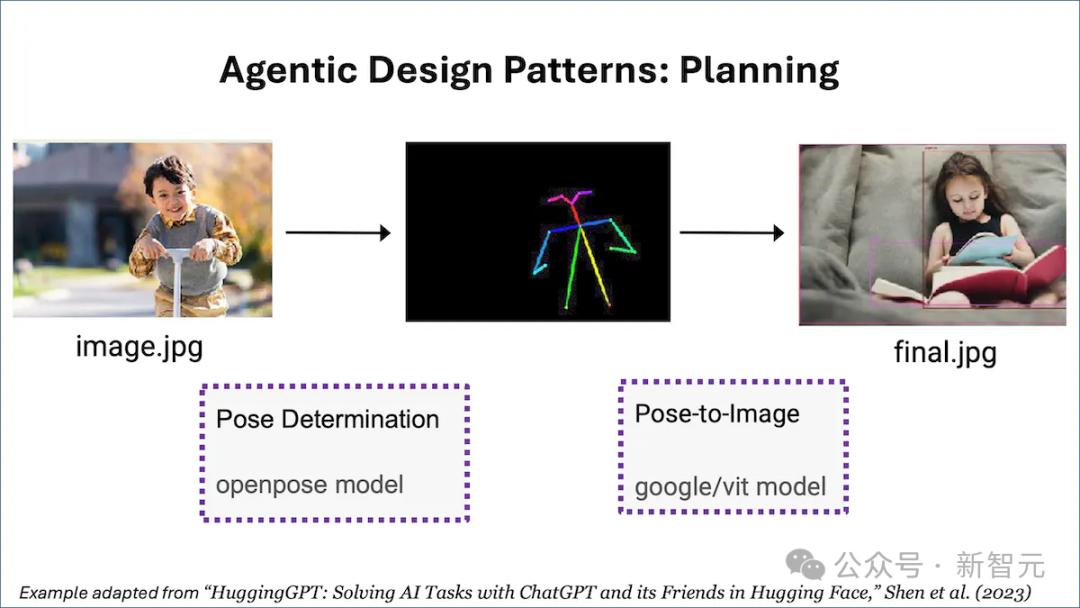

例如,要求智能体参考一张男孩的照片,画一张同样姿势的女孩的照片,这个任务可以分为两个步骤:(i)检查男孩照片中的姿势,(ii)用检测到的姿势渲染女孩的照片。

LLM可能会导出类似的导出。 {tool:pose-detection,input:image.jpg,output:temp1 } {tool:pose-to-image,input:temp1,output:final.jpg} 这种字符串可以指定计划。

Planning是一种很强的能力,但它也会产生意想不到的结果。

吴恩达说,Planning仍然是一项不成熟的技术,客户很难提前预测它会做什么,但我们可以期待技术的不断发展来解决这个问题。

此处还推荐3项相关优秀工作:

论文地址:https://arxiv.org/pdf/2201.11903.pdf

论文地址:https://arxiv.org/pdf/2303.17580.pdf

论文地址:https://arxiv.org/pdf/2402.02716.pdf

参考资料

https://twitter.com/AndrewYNg/status/1779606380665803144

本文来自微信微信官方账号“新智元”(ID:AI_era),作者:alan,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com