奥特曼开出400万年薪急招「末日主管」,上岗即迎「地狱模式」

奥特曼开出400万年薪,意在为OpenAI购入一份「安全保险」!

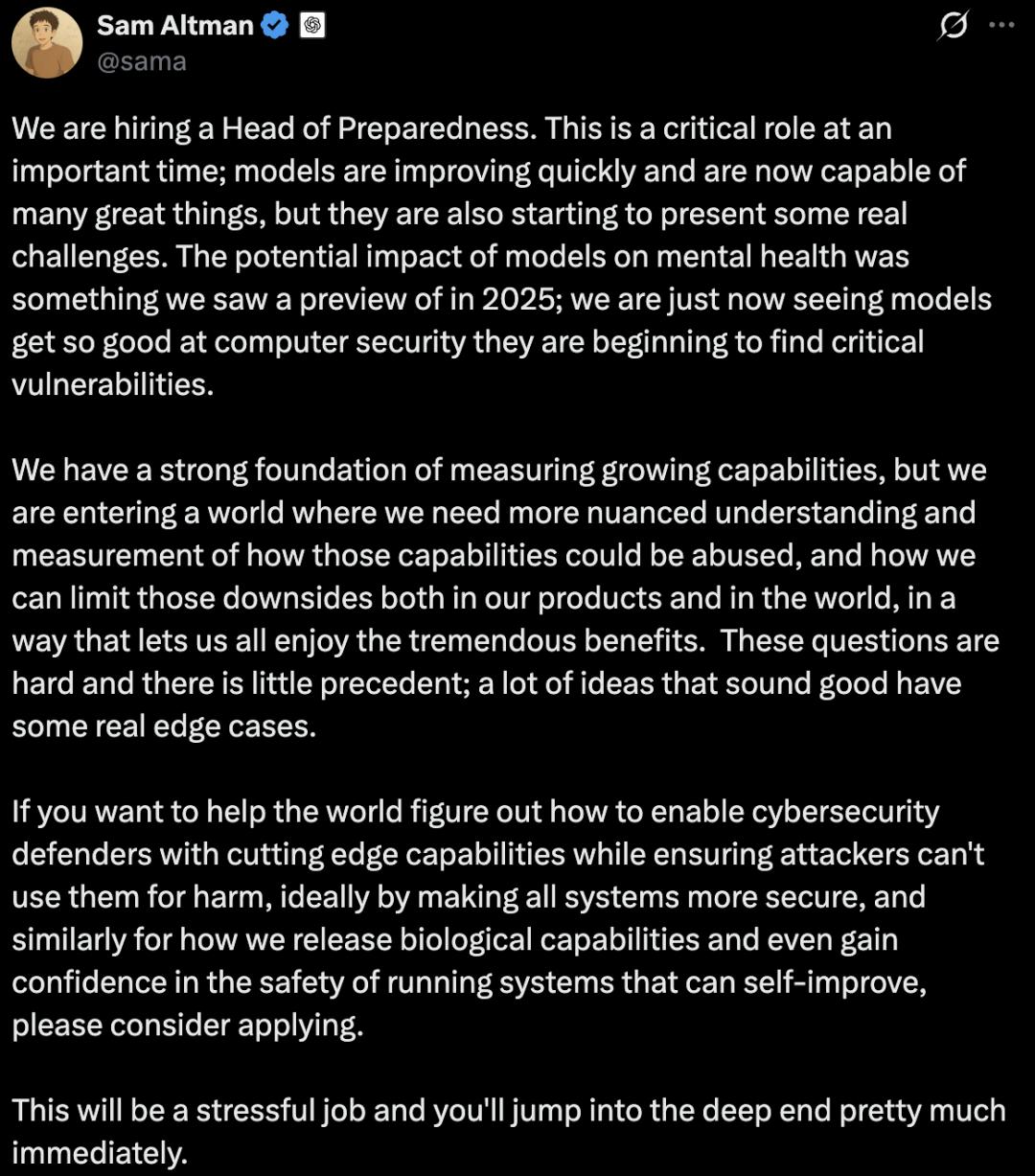

近日,奥特曼发布帖子,计划为OpenAI招募一位「准备工作负责人(Head of Preparedness)」。

该岗位基础年薪达55.5万美元,再加上股权,换算成人民币起步价约400万。

在硅谷,「55.5万美元基础年薪加股权」属于极为罕见的高薪高管岗位,底薪越高,通常意味着岗位稀缺性越强、责任范围越广。

尽管OpenAI未公开股权规模,但该岗位的薪酬总包或许能达到百万美元级别。

与高薪相匹配的是极具挑战性的工作内容。

奥特曼给这个岗位的定位就是「压力巨大」「需立即深入核心」:

这会是一份压力很大的工作,而且你几乎一上来就要跳进深水区。

关键时刻的关键角色

这份工作更像是一个「救火队长」,甚至可以称作「末日主管」。

其职责并非让模型变得更聪明,而是要给持续变强的模型套上「安全围栏」,管控好随之而来的风险。

用奥特曼的话来说,这是一个「关键时刻的关键角色」,模型正飞速发展,能创造诸多价值,但也开始带来「实实在在的挑战」。

他在招聘帖子中特别提及了过去一年发现的两件事:

模型对心理健康存在潜在影响;

模型在计算机安全领域的能力迈入新阶段,已能发现「高危漏洞」。

奥特曼强调,我们在评估能力增长方面已有扎实基础,不过接下来的挑战是如何防止这些能力被滥用,如何在产品及现实世界中最大限度降低其负面影响,同时让大家继续享受它带来的巨大益处。

他认为这是一个巨大且几乎无先例可循的难题,需要一个「更精细理解和更细致度量的环境」。

许多看似不错的想法,一旦落地就会遇到棘手的例外情况和边界问题。

所以,新招募的这位「准备工作负责人」的职责,就是在模型能力持续提升和应用范围不断扩大的前提下,设立一道安全防线:

如何用最前沿的技术武装网络安全防守方,同时确保攻击者无法利用这些技术作恶。

奥特曼也为这份工作设定了目标:

最理想的状态是,通过提升所有系统的安全性来实现,比如更安全地推出生物领域的AI能力,以及增强对自我改进系统安全运行的信心。

模型能力提升

风险也更「硬核」

过去我们谈论AI风险,往往如同发布天气预报:可能会下雨,最好带把伞。

随着大模型能力的提升和技术的快速渗透,当前的AI风险更像是乌云密布的时刻:雨已经落下,而且风向还在变化。

一方面是模型变得更强了。

奥特曼提到了一个标志性变化:

模型在计算机安全领域进入新阶段,「开始能发现关键漏洞」。

这句话细想起来令人后怕——当模型能帮你找出漏洞时,它也可能被别人用来寻找漏洞。

正所谓道高一尺,魔高一丈。

另一方面,模型技术的普及也带来了更多「硬风险」,2025年已出现一些端倪。

比如,模型对心理健康的潜在影响。

进入2025年,我们看到了不少关于「AI精神病」的报道:

有人将与机器人聊天当作心理治疗的替代方式,但在某些情况下,这会加剧心理健康问题,助长妄想等令人担忧的行为。

今年10月,OpenAI曾表示正与心理健康专业人士合作,改进ChatGPT与出现精神错乱或自残等危险行为用户的互动方式。

除了心理健康,还有报道指出ChatGPT在法律文件中会产生幻觉,引发大量投诉。

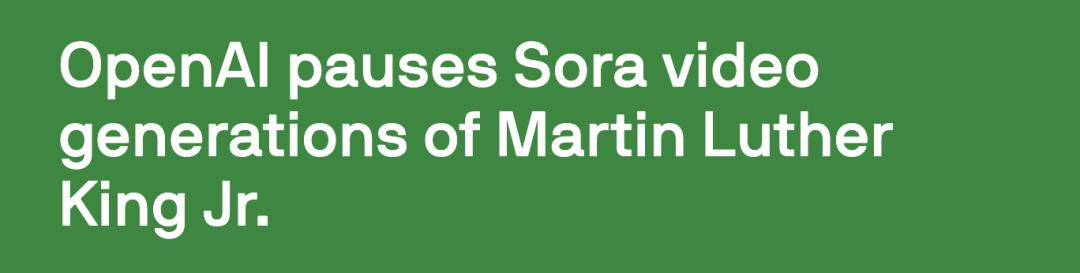

此外,ChatGPT、Sora等应用产品上线后,还带来了深度伪造以及社会伦理等一系列挑战。

例如,Sora曾在2025年10月因用户生成「不尊重」内容,暂停或封禁了马丁·路德·金相关视频的生成,并同步加强了历史人物肖像相关的防护措施与退出机制。

因此,奥特曼要求这份工作要将安全从能力评估、威胁建模、缓解措施形成一条可落地的链条,构建一个「连贯、严谨且可操作、可扩展的安全流程」。

填补「安全空心化」的焦虑

这次招聘,更像是对OpenAI安全团队的紧急补充与强化。

OpenAI的核心使命是以造福全人类的方式开发人工智能,从创立之初就将安全协议(safety protocols)作为运营的核心部分。

然而,一些前员工表示,随着OpenAI开始推出产品和盈利压力增大,公司开始将利润置于安全之上。

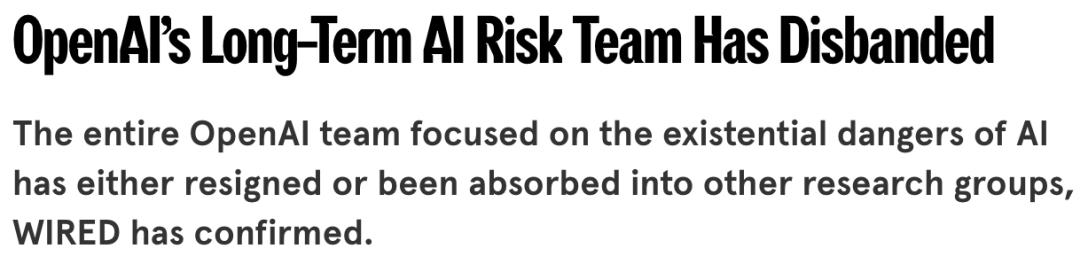

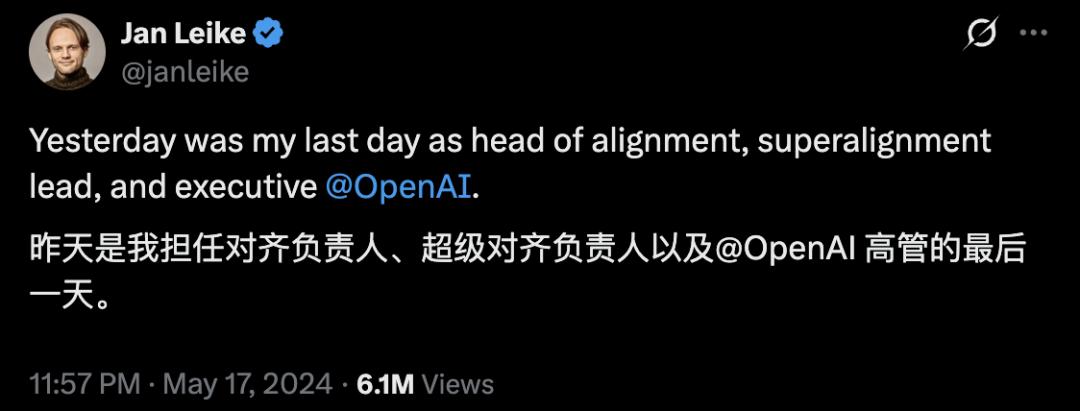

一个标志性事件就是「超级对齐」(superalignment)团队的解散。

2024年5月,OpenAI的「超级对齐」团队解散,其工作将被并入或吸收到其他研究项目中。

超级对齐团队的两位共同负责人Ilya Sutskever和Jan Leike也先后离职,其中Leike离职时尖锐地批评了公司,称公司已偏离确保技术安全部署的使命:

「构建比人类更聪明的机器本身就是一项危险的尝试……但在过去几年里,安全文化和流程已让位于光鲜的产品」。

Leike表示,OpenAI未能投入足够的计算资源来研究如何引导和控制那些远比人类聪明的人工智能系统。

另一名前员工Daniel Kokotajlo也表示,他辞职是因为「对公司在通用人工智能(AGI)出现时能否负责任地行事逐渐失去信心」。

当时奥特曼针对Leike的发帖回应称,他说得对:「我们还有很多事情要做;我们承诺会去做」。

OpenAI联合创始人兼总裁Greg Brockman也表示,公司愿意为了安全问题推迟产品发布:

「首次弄清楚如何让一项新技术变得安全并非易事,我们既相信要实现巨大的潜在收益,也致力于努力降低重大风险」。

在超级对齐团队解散约两个月后,7月AI安全负责人Aleksander Madry被调岗。

OpenAI原AI安全负责人Aleksander Madry

10月23日,OpenAI长期政策研究人员、AGI readiness团队高级顾问Miles Brundage离开OpenAI。

随着Brundage的离开,AGI readiness的子团队economic research division将划归新任首席经济学家Ronnie Chatterji管理,其余部分则分散到其他部门。

Kokotajlo曾表示,「OpenAI最初约有30人研究与通用人工智能(AGI)相关的安全问题,一系列的离职使得这一人数减少了近一半」。

安全团队负责人及员工的离职、调岗,项目不断被分拆、重组,由此引发的「安全空心化」焦虑,正是这次奥特曼高调招聘的大背景。

当「前沿模型」的能力逼近更高边界时,谷歌、Anthropic、OpenAI、xAI等大模型厂商在AI军备竞赛中,都面临同一个问题:如何在加速发展中避免失控?

而此次招募的「准备工作负责人」的工作,就是要把不断变强的模型,在现实使用场景中转化为一个能评估、能落地、能迭代的「可执行的安全管线」。

当AI竞赛进入关键阶段,守住安全底线才是立于不败之地的关键。

参考资料:

https://www.businessinsider.com/openai-hiring-head-of-preparedness-ai-job-2025-12

本文来自微信公众号“新智元”,作者:新智元,编辑:元宇,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com