DeepSeek更新:引领国产芯片新飞跃

DeepSeek V3.1上线后,官方的一条留言瞬间在AI圈引起轰动。

“新的架构、下一代国产芯片”,短短不到20个字,却蕴含丰富信息,引发广泛热议。

经过对众多科普文的研究,简单来说,国产AI正迈向软硬协同阶段,未来模型有望减少对英伟达、AMD等国外算力的依赖。

同时,此次更新打破了“性能越高成本越贵”的行业常规,为金融、医疗等高算力场景的应用带来更多想象空间。

资本市场反应迅速:DeepSeek官宣后,国产芯片概念股应声上涨,每日互动尾盘直线拉升,收盘涨幅达13.62%。

有网友调侃:国产芯片迎来暴涨,DeepSeek一句话让周五大盘冲上3800点。

近日,DeepSeek官方低调上线V3.1版本,仅发布了一则公告。

此次V3.1更新的核心创新是其混合推理架构——Hybrid Reasoning Architecture。

该架构支持思考模式和非思考模式,用户可随时切换,既能慢慢分析,也能快速得出结果。

过去,DeepSeek产品线分工明确:V3模型擅长通用对话,R1模型更适合深度思考。这种分离式架构虽让各模型在擅长领域表现出色,但用户切换不便。

如今,V3.1打破壁垒,将通用对话、复杂推理、专业编程等多种核心功能集成于同一模型,提升了使用灵活性和效率。

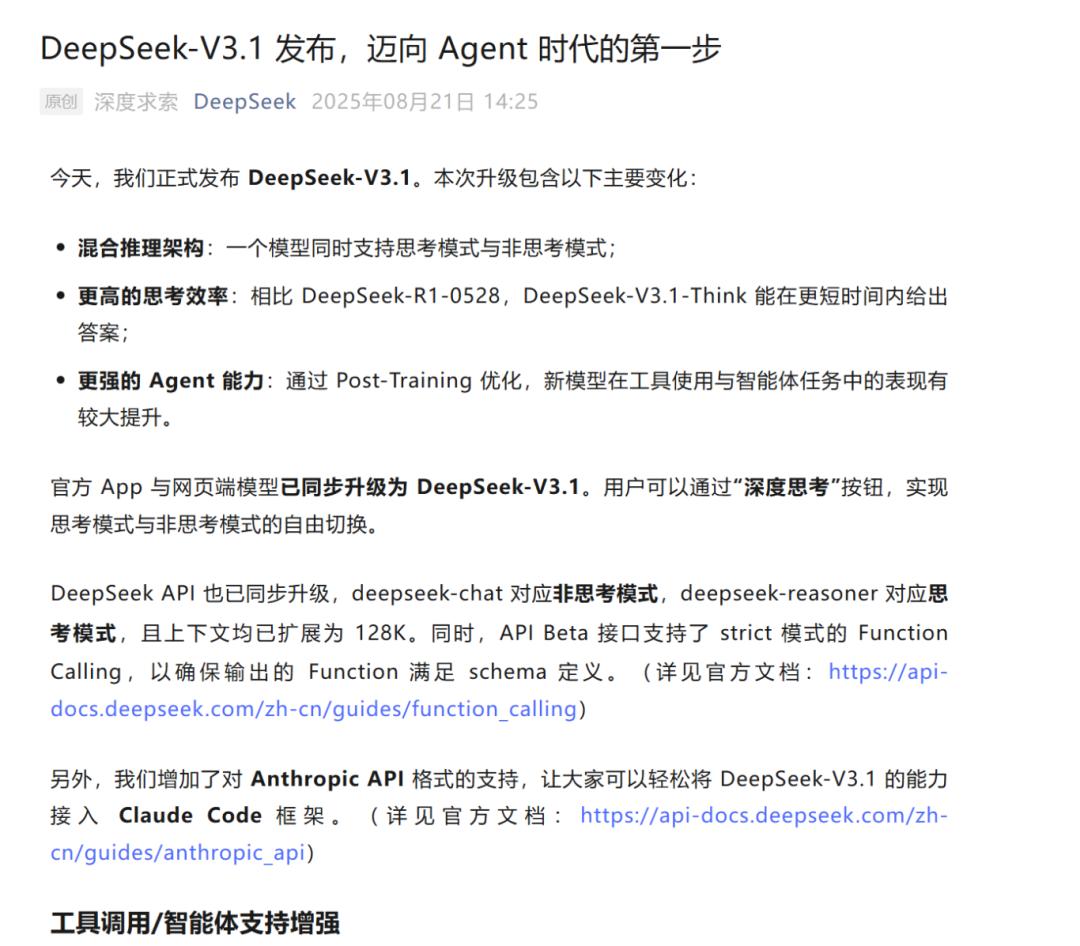

此外,V3.1的推理效率显著提升。官方数据显示,在思考模式下,其各项任务平均表现与前代顶级R1 - 0528相当,但输出的token数量减少20% - 50%;非思考模式下,输出长度更短,性能却不打折。

这得益于“思维链压缩”技术:模型在训练阶段学会生成更简洁、高效的推理路径,同时保证答案准确,即算法更加智能。

这样做的目的很明确:节省成本。

以往,思维链虽增强了模型推理能力,但冗长的中间步骤导致计算成本和API调用费用高昂,难以大规模应用。

V3.1的思维链压缩解决了这一问题,使高级AI推理能力从学术工具转变为可大规模商业化的经济方案。

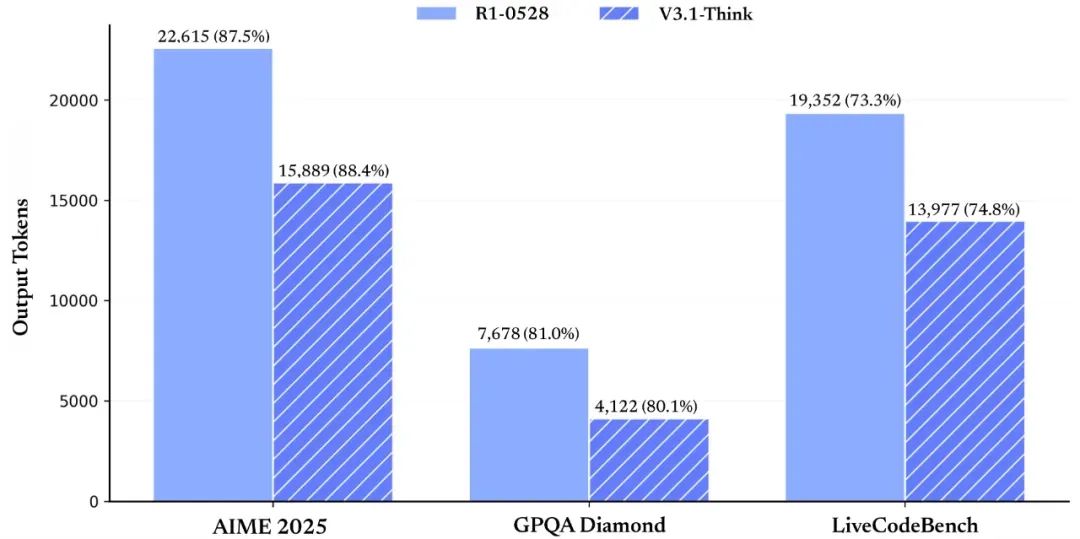

在社区测试中,DeepSeek V3.1在Aider多语言编程测试中分数超过Claude 4 Opus,且成本更低。

这引发开发者关注,Hugging Face上的热度持续上升。

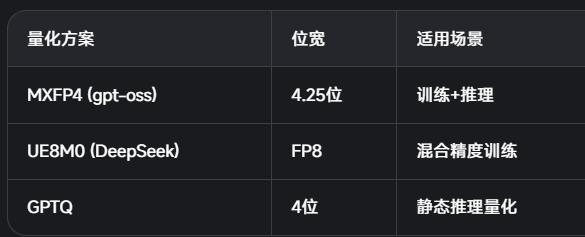

值得注意的是,DeepSeek官宣V3.1时提到,该模型采用UE8M0 FP8 Scale的参数精度,同时对分词器和chat template进行了调整,与之前的V3有明显差异。

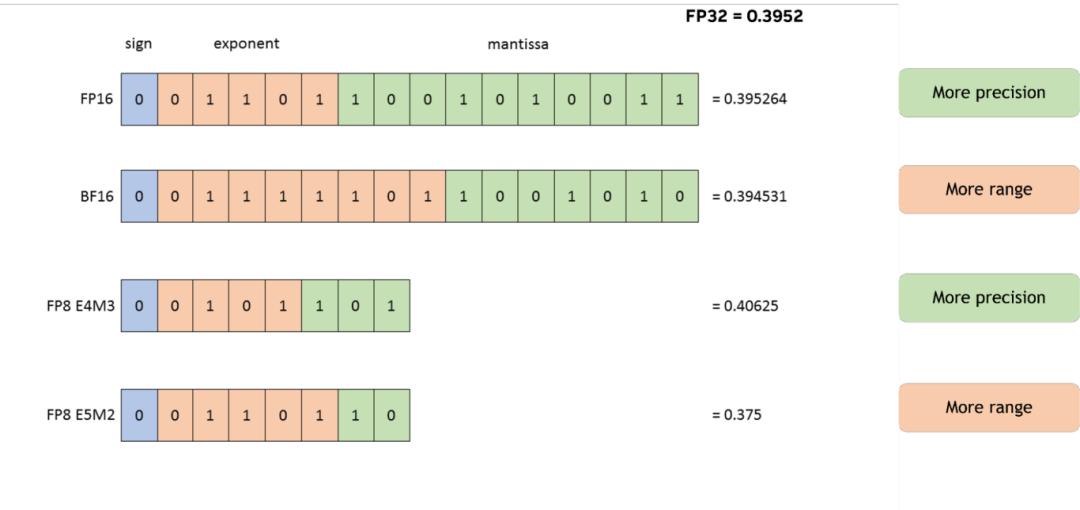

关于“UE8M0 FP8”,简单介绍如下:

FP8将普通浮点数压缩为8位存储,节省空间和算力。

结合MXFP8的“块缩放”思路,将数据分块,每块使用独立缩放系数,既减少信息损失,又节省资源。

名字中的U、E、M可理解为“无符号 + 指数 + 尾数”。UE8M0中8位都用于表示指数,无尾数和符号位,处理器复原数据时只需移动指数位,无需复杂乘法,速度快、路径短。

该格式动态范围大,能同时表示大小数,不易溢出或被压成0,在保证8位张量精度的同时,将信息损失降至最低。

这对国产新芯片非常合适,此前多数国产AI芯片采用FP16/INT8,无法原生支持FP8。

目前,大部分国产AI加速器采用FP16/INT8方案,缺乏完整的FP8单元。

新一代芯片,如摩尔线程MUSA 3.1 GPU、芯原VIP9000 NPU,开始支持原生FP8,DeepSeek V3.1的UE8M0格式与之匹配。

总之,UE8M0 FP8让模型在新一代国产芯片上运行更省空间、更快、更稳,同时保持精度。

这也是DeepSeek官微特别提及的原因,为国产AI带来了低成本、高性能的新机遇。

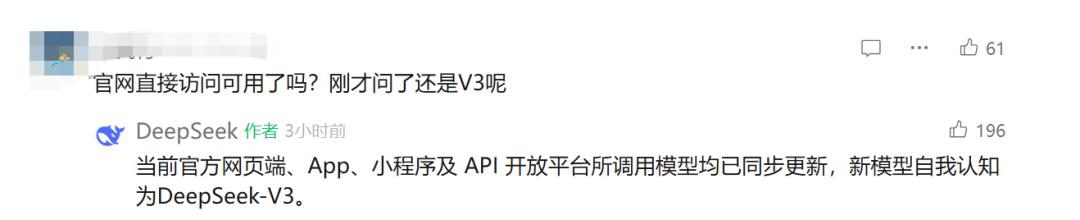

下面看看更新后的使用体验,大家关心的官网访问问题,官方给出了答案。

打开官网发现,DeepSeek将App和网页端的“深度思考(R1)”改为“深度思考”,官方证实模型已更新。

看看网友们的新奇玩法。

推特X上有AI博主分析,新模型生成的小球跳动效果更符合物理定律,还能调节重力、摩擦、旋转速度、弹跳等参数。

有人用DeepSeek V3.1制作振动编码,变身VJ。

还有网友让V3.1绘制自画像,画风独特。

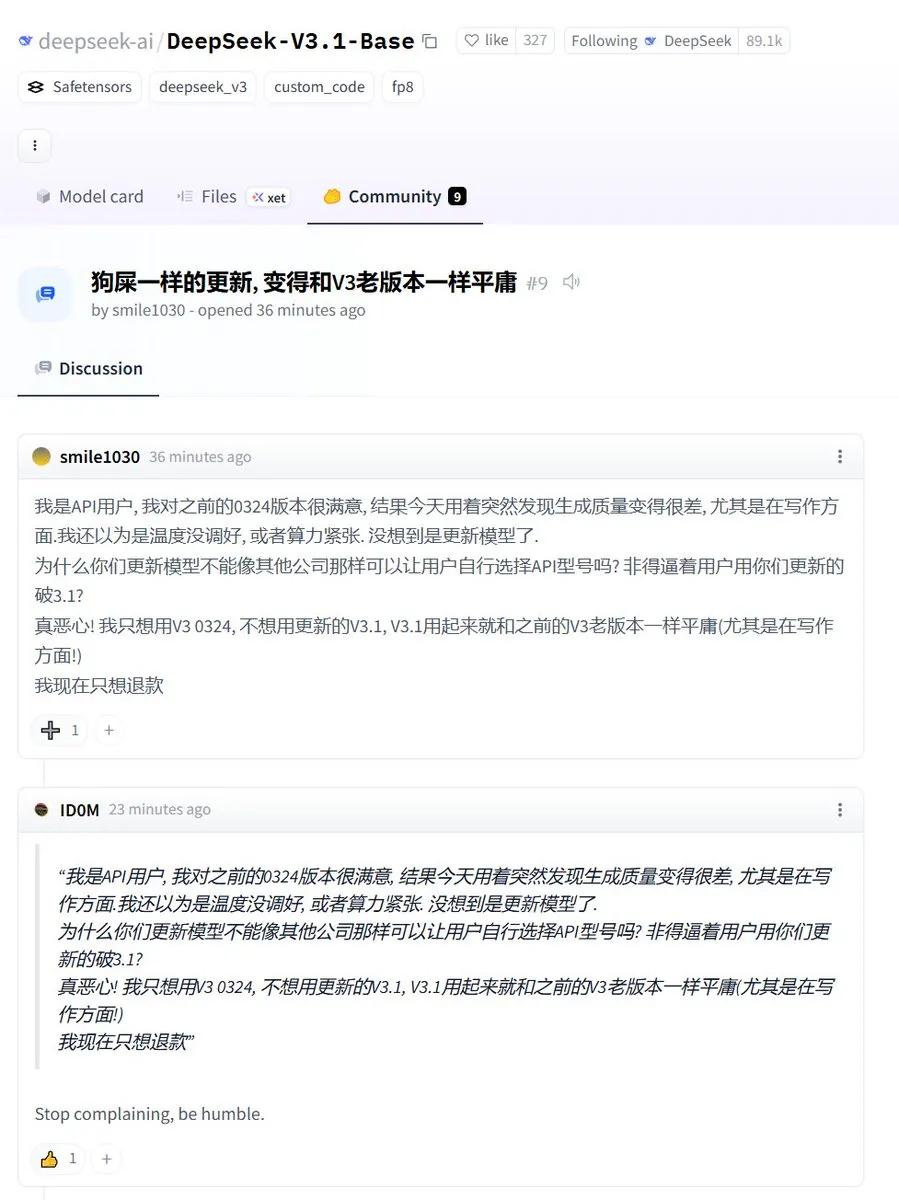

不过,社区中部分用户吐槽翻译和写作存在问题,SYSTEM PROMPT需现场写指令,中英夹杂和错词偶有出现。

感兴趣的朋友可前往官网体验。

每次DeepSeek更新都让人期待下一次,它几乎成为国产AI的精神象征,让我们一起期待DeepSeek R2的到来。

本文来自微信公众号“科技狐”(ID:kejihutv),作者:老狐,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com