实测 YRCloudFile KVCache

进一步探索和发布 KVCache 详细的性能优化数据在推理场景中。

DeepSeek 在千行百业落地的背景下,存储与计算的协同优化正在成为企业的提升。 AI 推理效率,降低企业成本的关键。KVCache 通过“以存换算”的创新模式,技术显著提高了推理性能,成为企业构建大型基础设施的必然选择。此前,金融科技率先推出。 YRCloudFile 分布式文件系统 KVCache 特点,支持 PB 水平缓存扩展,大大提高 KV 为大模型推理提供更好的性价比技术规范,缓存命中率和长前后处理量。

本文以公开数据集和业界公认的检测工具为基础,以公开数据集为基础,以公开数据集为基础。 NVIDIA GPU 模拟真实的硬件平台推理需求场景,进一步探索和发布 KVCache 详细的性能优化数据在推理场景中。测试数据显示,在相同的规模和推理延迟中 TTFT(Time-To-First-Token) 下,YRCloudFile KVCache 可以支持更高的并发查询请求,为用户提供更贴近实际使用场景的性能验证和改进方案。不仅仅是这些信息的验证 KVCache 技术有效性,并且暴露了高性能 KVCache 可量化的推理业务价值。

为了验证将 GPU 内存扩展至 YRCloudFile KVCache 对 token 显著提高处理效率,并充分展示融融效果。 AI 我们对存储结构的优异性能进行了多轮测试。根据不同的情况 token 对数量和设备进行测试,深入探索该架构在实际应用中的优化潜力。下面的测试都是基于原生的。 vLLM,以及 vLLM YRCloudFile KVCache 对数据进行比较。

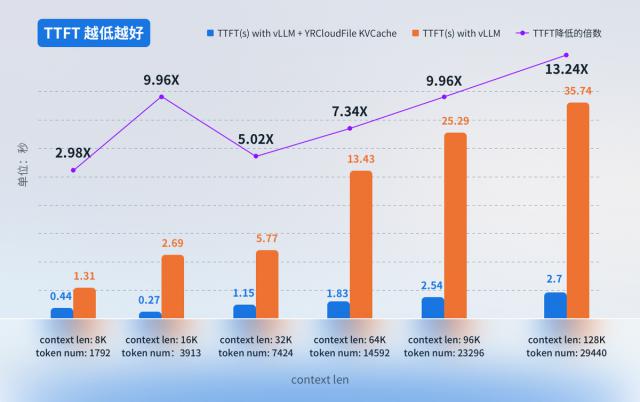

测验一:长期前后提问,推理。 TTFT 的对比数据

背景:输入长文和长文,比较一个问题的答案总时间(指超过超过) 20K 长度的 token)

显卡:NVIDIA T4

模型:Qwen/Qwen2.5-7B-Instruct-GPTQ-Int4

测试方法:基于相同的前后文本,使用相同的问题, QA chatbot 提问模拟在上面进行

测试结论:在长前后文场景中,使用 YRCloudFile KVCache 可实现高达 13 倍的 TTFT 性能提高。由于其高效缓存命中率和大规模数据的快速处理量,这一显著提高为大模型推理提供了更好的性能支持。

顾客普遍可以接受 TTFT 在 2 几秒钟内。基于这个背景,我们制定了一个测试二,以验证系统在长前后文场景中的性能。

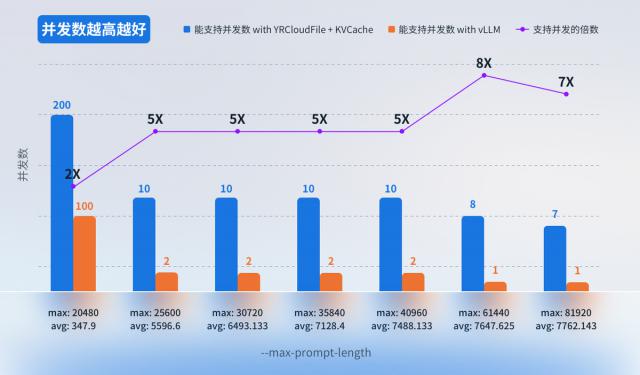

测试二:使用不同的前后文长度, TTFT ≤ 2 秒时,相同 GPU 可以支持并发数对比数据。

背景:在相同的显卡配置和 2 秒 TTFT 在延迟约束下,通过比较原生 vLLM 与集成 YRCloudFile KVCache 在不同的前后文长度下解决方案(--max-prompt-length 参数下的并发支持能力,验证了存储扩展对并发推理请求的提升效果。

显卡:NVIDIA L20

测试工具:使用 evalscope 检测工具, --dataset 参数为 longalpaca,以及不同的指定 --max-prompt-length 检测参数值。

测试结论:是一样的 GPU 配备下,当 TTFT ≤ 2 秒时,YRCloudFile KVCache 可承载的并发数可以增加 8 倍数。也就是说,在相同数量的情况下。 GPU 配置下,系统能够满足更高的并发要求,显著提高了推理性能和资源利用率。

测试三:是一样的 GPU 在配置和较高的并发数下,使用不同的前后文长度 TTFT 性能比较数据。

背景:在相同的显卡配置下,通过设置不同的前后文长度(--max-prompt-length 参数),并发数为 30 前提是使用原生产品 vLLM,以及 vLLM YRCloudFile KVCache 对数据进行比较。

检测工具:evalscope,--dataset 使用 longalpaca,指定不同 --max-prompt-length,并发为 30 在这种情况下,进行测试。

测试结论:在较高的并发数下,针对不同的前后文长度,YRCloudFile KVCache 所提供的 TTFT 延迟可缩小 4 超过一倍;这个说明 YRCloudFile KVCache 推理性能得到有效提升,延迟明显减少,用户体验得到显著提升。

本试验通过多维验证说明,YRCloudFile KVCache 在长期处理和高并发场景中,表现出显著的性能优势: TTFT≤2 在秒的严格约束下,其支持的并发数提高达到 8 倍,并且延迟可以减少高并发负荷中的延迟。 4 倍以上。这个结果不仅得到了证实 "存储 - 计算协同提升" 对 AI 推理效率的核心价值也揭示了通过分布式存储架构拓展存储资源的技术路径,可以有效打破传统 GPU 计算瓶颈,实现资源利用率指数级提升。

当前,随着 DeepSeek 等待大模式在千行百业大规模落地,企业对推理效率和成本优化的需求日益迫切。YRCloudFile KVCache 通过 PB 一级缓存扩展能力,将存储资源转化为计算性能增益,为行业提供兼顾高性能和低成本的实践案例。这是一种通过存储结构创新驱动计算率释放的方式,或者是公司建立下一代 AI 加快大模型从技术突破到商业闭环的演变过程,是基础设施的关键突破点。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com