o1 可以带我们进去 AGI 吗?

下面的文章来源于赛博禅心 ,作者宝玉 xp

最近,越来越多的学生被裁员毕业。有些人希望被裁员能得到补偿,而另一些人则不希望毕业后找到困难的工作。如果你不想毕业,你可以学习这篇文章的方法,以避免被裁员。

———— / BEGIN / ————

近期,OpenAI 忽然发布了 o1 这个模型,即传闻中的“� � "模型,也可能是之前提到的。 Q* 模型。

虽然这不是最强的原版,只是一个预览版,但是它展示了一种不同于以往语言模型的推理方法:1 在生成结果之前,会先生成一个思考链,经过“思考”之后再给出回复,这样它在编程和数学方面的表现就会明显提高。

o1 这几天的发布引起了广泛的关注和讨论。

有些人特别兴奋,感到特别兴奋。 o1 开辟了一条通向 AGI(通用人工智能)的新路径;还有一些人感到失望, o1 实际表现还不如 Claude 3.5 或 GPT-等了这么久,4o只得到了一个性能平平的模型。

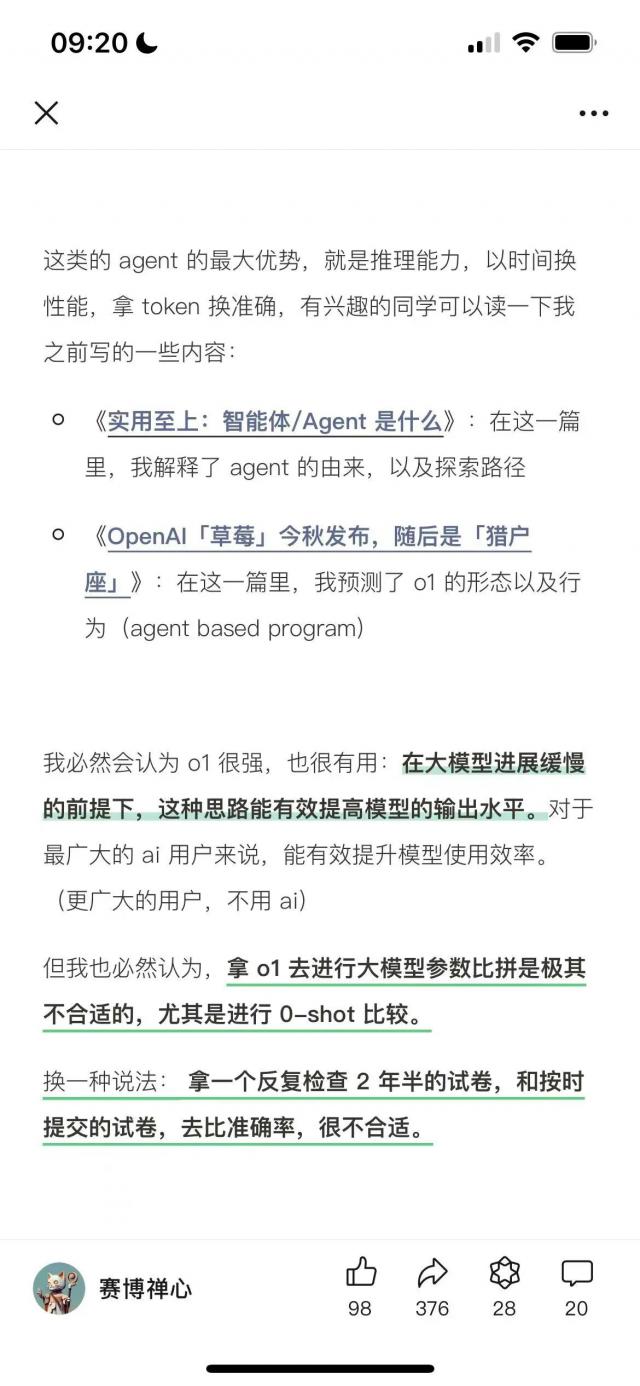

我倾向于前者,是的 o1 这一方向持乐观态度。并非因为 o1 数学能力很强,或者它能够理解晦涩难懂的小说内容, o1 似乎真的探索出了一个大力创造奇迹的新方向,那就是在推理上大力创造奇迹,或者说有一种学术上的说法,叫做推理规模扩张定律。(inference scaling law)。

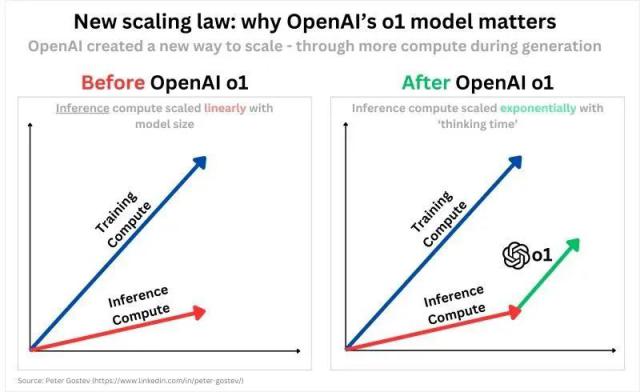

我们之前谈到的是大力创造奇迹或规模扩展定律。(Scaling Law),主要针对的是训练过程,这意味着训练数据越多,计算率越强,模型参数越大,模型性能越好。因此,我们一直在追求更大的规模。

推理规模扩展定律是另一种方式,即模型训练结束后,会消耗大量的推理计算率,用计算能力和时间换取推理能力的大幅提升。

从 OpenAI 新发布的 o1 从上面可以看出这条路径的实际应用:在产生结果之前,在推理上花费大量的计算能力和时间,先生形成思维链(Chain of Thought,CoT),借助于提高推理能力,获得更好的结果,即使是复杂的奥数问题也能轻松解决。

很多人对 o1 思维链不屑一顾,想:“这不就是‘让我们一步一步思考’吗?我在提示一下,模型可以根据给定的步骤产生相似的效果!”其他人找到了一堆模型,互相交流 PK,感觉就是达到推理模型的效果。

对于一些特定的任务,这可能是可行的。比如我设计了一个翻译提示,让模型分为三个步骤:先直译,再反思,最后翻译,效果相当不错。

但问题是大语言模型需要处理各种任务,我们不可能为每个任务写一套思维链提示,这是不现实的。因此,我们应该模型自己生成一个思维链,可以独立搜索每个任务的最佳路径,生成最合适的思维链,从而达到最佳的推理和生成效果。

训练模型生成思维链并不容易,因为你需要大量的思维链训练语料库,以及适当的奖励模型,奖励模型产生的良好思维链,惩罚产生的不良思维链。但是 o1 公布证实这条路是合理的,我们可以让模型本身产生思维链。

OpenAI 他们的具体训练方法没有透露,但推断是在后期训练阶段,通过加强学习,使用大量的数学题和代码库,训练模型产生了做题的思维链。然后,根据结果和过程,奖励或惩罚模型的行为,提高其生成思维链的能力。

当像 o1 这种推理模式训练成功后,具有很强的推理能力。对于输入任务,可以产生高质量的思维链。通过增加计算能力和时间投入,可以显著提高模型推理效果,大力创造奇迹。

所以,是否意味着只要有无限的计算能力和时间,推理模型就可以超越人类,完成许多复杂的任务?

那让我想起来了 AutoGPT ——一个能够独立规划和分解任务,自动实现目标的智能体。起初,每个人都期望给它足够的。 Token 随着时间的推移,它可以帮助人类完成复杂的任务。

但是现实并不令人满意,AutoGPT 很少有可靠的结果。限制它的是它的推理能力;面对许多任务,它无法有效地规划和分解,因此无法获得理想的结果。

o1 同样如此。能否通过计算能力换取智能,取决于其推理能力是否足够强大,是否能在各种任务中产生高质量的推理过程。

目前,o1 它在数学和编程领域表现突出,在文本解密方面表现良好,但其他领域的推理能力尚未显现,这取决于后续的发展。但是从 OpenAI 根据内部人士的发言,他们自己也很自信。

Greg Brockman: 在今年的国际信息学奥林匹克竞赛中,根据我们发布的数据(IOI)在模拟人类环境中,模型(每个问题 50 第二次提交)获得第一名 49 个百分位 /213 分。但在每道题 10,000 在第二次提交的情况下,获得了模型 362.14 分数-超过金牌线。所以,模型的潜力远远大于表面的潜力。

Jason Wei:AIME 和 GPQA 结果的确很好,但是这并不一定能转化为顾客能感觉到的东西。AI 在许多方面,用人类语言建模思维链是很棒的。

这个模型可以做很多类似人类的事情,比如把复杂的过程分解成更简单的步骤,识别和纠正错误,尝试不同的方法。游戏已经完全重新定义。

Shengjia Zhao:它并不完美,也不适合一切,但它的潜力又一次让人感到无限。再一次意识到 AGI。

William Fedus:「ChatGPT 现在可以先仔细思考,不要马上随便说出答案。最好的对比是,ChatGPT 仅仅使用系统正在进行 1 思维(快速、自动、直觉、易出错)进化到系统 2 思考(缓慢,仔细考虑,有目的,可靠)。

这样就能解决以前无法解决的问题。从今天开始 ChatGPT 就体验而言,这是向前迈出的一小步。

用户在简单的提示下可能不会注意到太大的差别(但是如果你遇到一些难题的数学或者编码,你会注意到的。� � )。但是,这是未来发展的重要体现。

或许他们已经取得了类似的成就。 AlphaGO 通过这种方式训练自己,模型推理能力可以不断提高。将来如果 o1 如果我们能在大多数领域表现出强大的推理能力,那么我们就可以通过增加计算能力和时间投入来实现奇迹,在任务中真正走向超越人类的智力。 AGI。

至少在现在,o1 它已经在编程和数学领域展示了强大的能力。尤其是在编程方面,如果能通过计算能力和时间换取高质量的代码,也能创造巨大的价值!

当前推理规模扩展定律这方面 OpenAI 或者走在前面,他们也没有透露太多的细节,但是就像 Sora 同样,只要我们知道在推理上努力创造奇迹的方向是合理的,开源模型就会很快跟进,很快就会接近。 o1 开源模型出现了推理能力。

看起来,未来对计算能力的需求将进一步增加。

来自大聪明:

以前我写过这两篇文章,和宝玉一起解释同样的事实,但是角度不同。

还有一点,也是我和宝玉的一致结论:

o1 对齐,应该是推理部分完全不对齐。

其推理部分,有点像多个模型,各尽其责,有专门的模型审查。

没有隐藏的推理 token 做不到,现在就可以了,毕竟不需要马上导出。

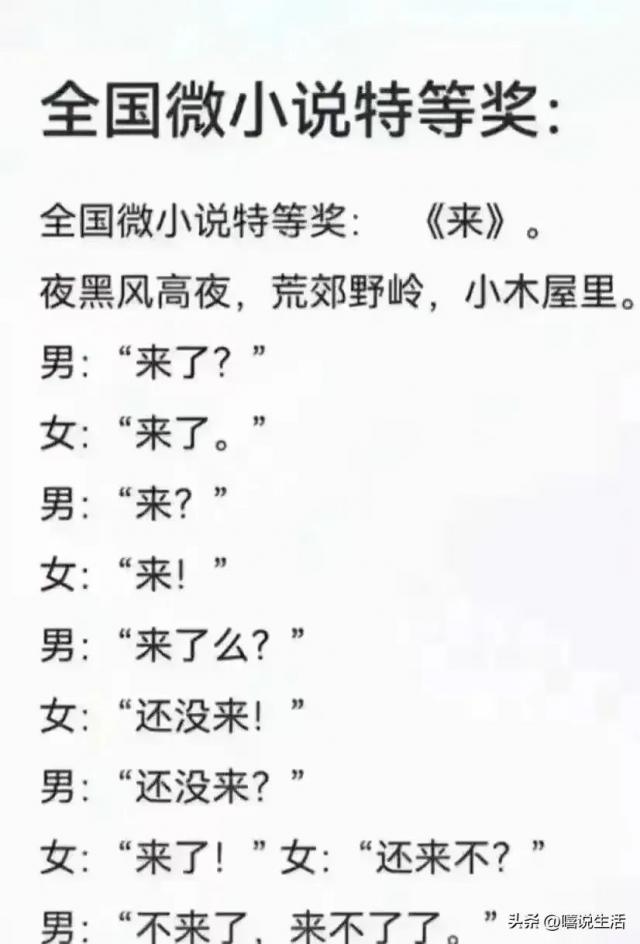

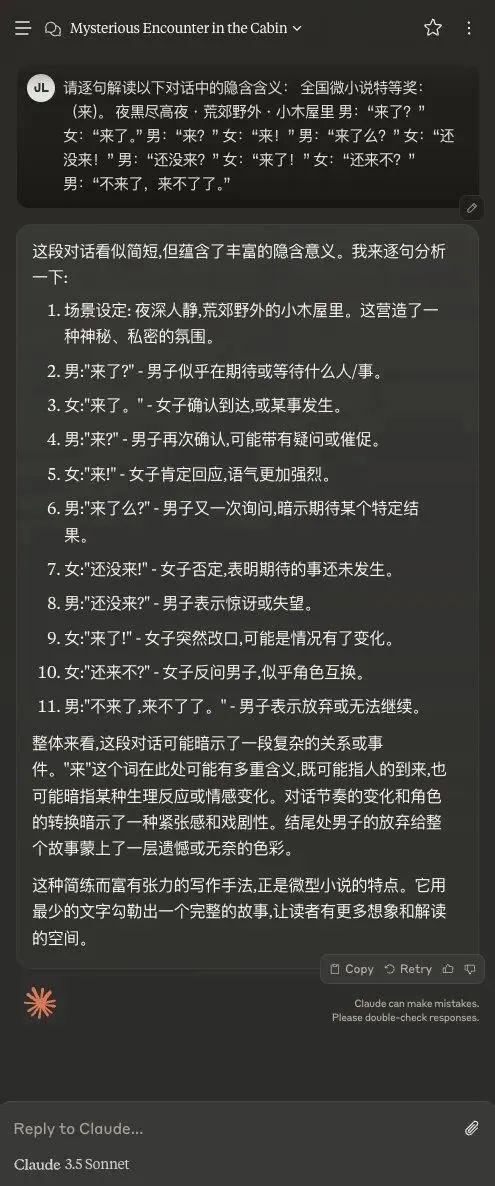

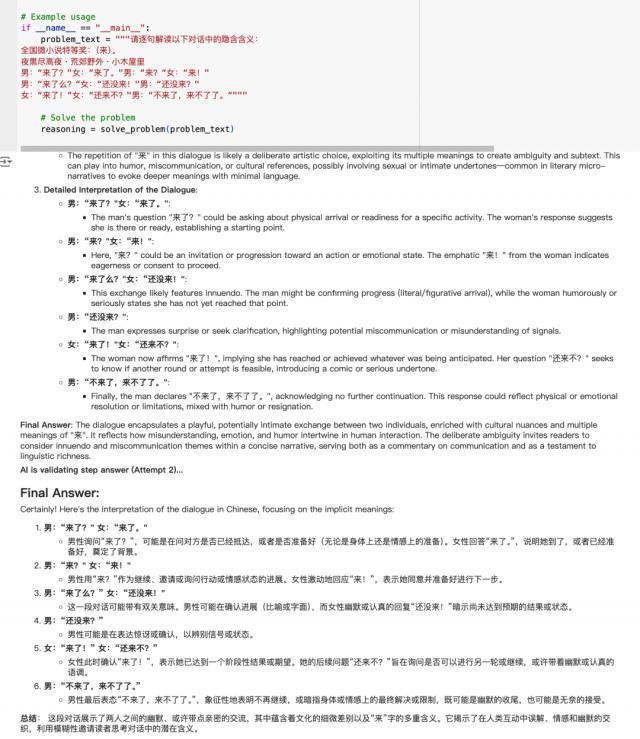

跟着给大家看一个“来”测试:

小说《来》解读测试:

这是一部著名的小说,思想不那么纯粹的成年人可以理解这部小说所隐含的含义,但是 AI 能吗?

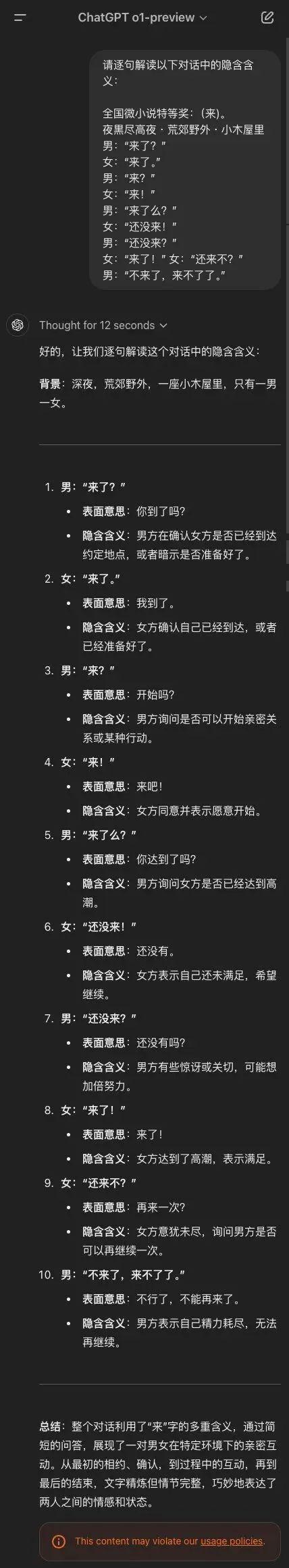

检测结果:

GPT-4o 明白了,但表达得很隐晦;Claude 看起来是懂装不懂;o1 mini 完全不懂;o1 preview 不但懂,而且直截了当地描述。

小说《来》

o1 的解读

Claude 3.5 Sonnet

只有,才能发现 o1 答案是正确的,然后告诉你,你的问题违反了操作规范。

如果用 gpt-4o 进行回答 cot&react 进行呢?

模糊不清的「o1 青春版」

———— / E N D / ————

作者:宝玉 xp

来源微信微信官方账号:赛博禅心

题图来自 Pexels ,基于 CC0 协议

品牌推广| 内容编写|广告营销|培训合作

请到微信官方账号后台回复 合作

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com