突如其来的内幕曝光?八月份的谷歌论文已经揭示了原理,大模型光有软件就没有环城河。

在发布不到一周的时间里,OpenAI最强模型o1的环城河已经消失。

有些人发现,谷歌DeepMind在8月份发表了一篇论文,揭示了原理和o1的工作方法。几乎一致。

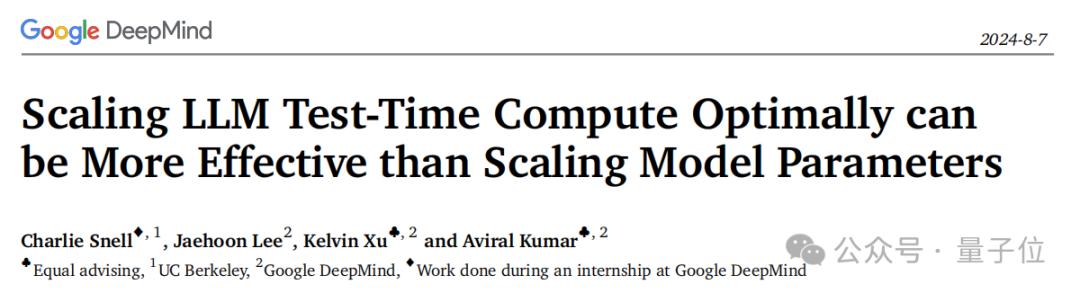

本研究表明,增加测试时间(test-time)计算效率高于扩展模型参数。

根据论文提出的最佳计算方法(compute-optimal)在测试过程中计算扩展策略,在某些任务中,规模较小的基本模型可以超越一个14倍大模型。

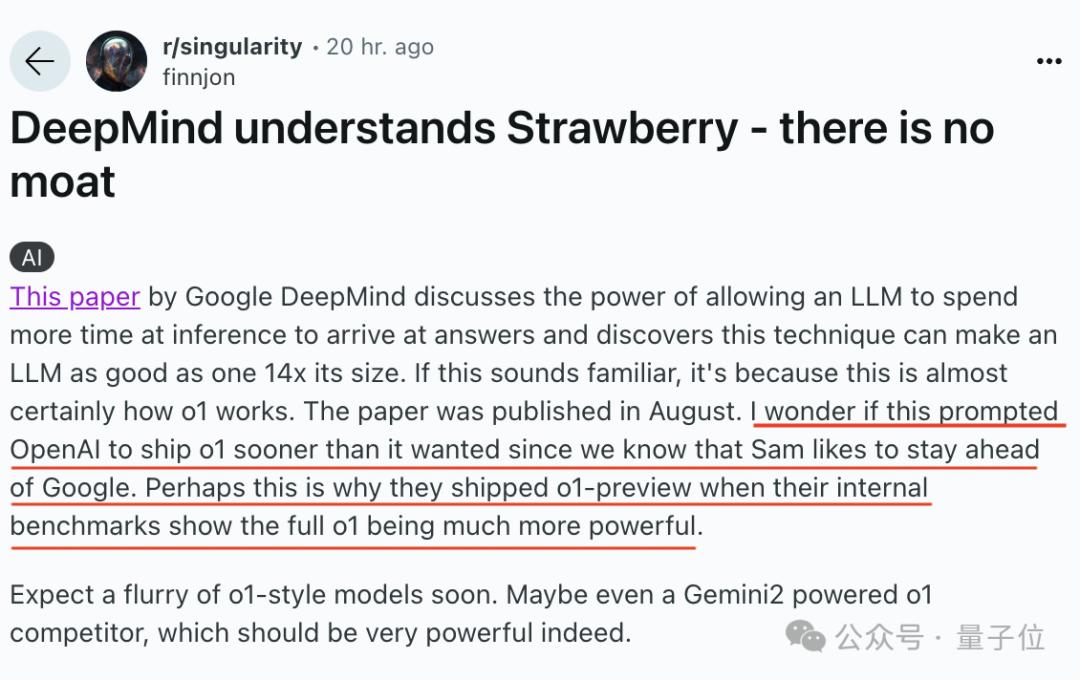

网友表示:

那几乎就是o1的原理啊。

大家都知道,奥特曼喜欢领先于谷歌,所以这就是为什么o1先发preview版本?

有些人因此感叹:

的确,正如谷歌自己所说,没有人环城河,也没有人有环城河。

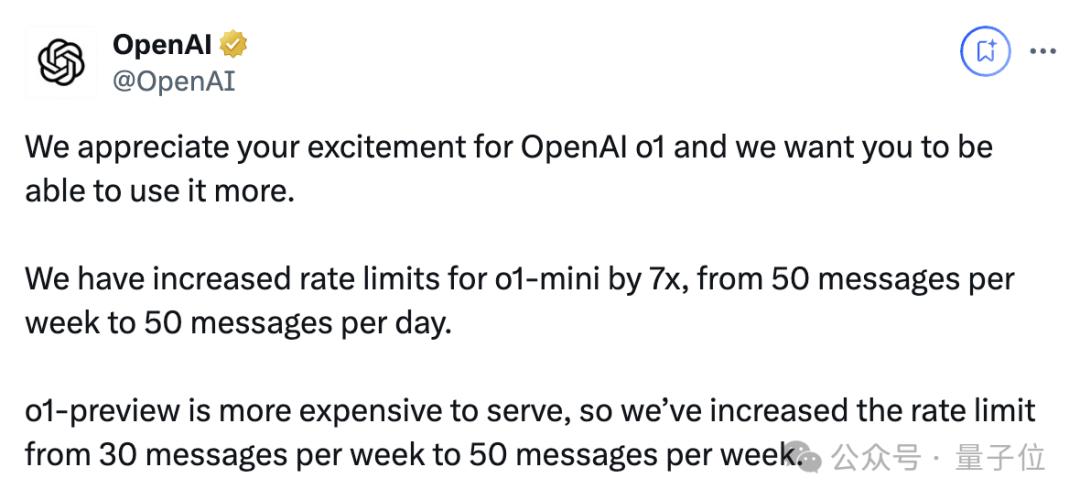

就在刚才,OpenAI将o1-mini的速度提高了7倍,每天可以使用50条;o1-preview提到每周50条。

计算量节省4倍

这篇论文的题目是谷歌DeepMind:在LLM测试中,计算比扩大模型参数规模更有效率。

研究小组延伸到人类的思维模式,因为人们在面对复杂的问题时会花更长的时间思考改进决策,那么LLM也可以这样做吗?

换言之,在面对复杂的任务之后,LLM能否更有效地利用测试时的额外计算来提高准确性。

以前有些研究已经证明,这个方向确实可行,但是效果比较有限。

所以这项研究想要探明,在使用较少的额外推理计算时,可以使模型性能提高多少?

使用PaLM2,他们制定了一组测试。-S*测试MATH数据。

主要分析了两种方法:

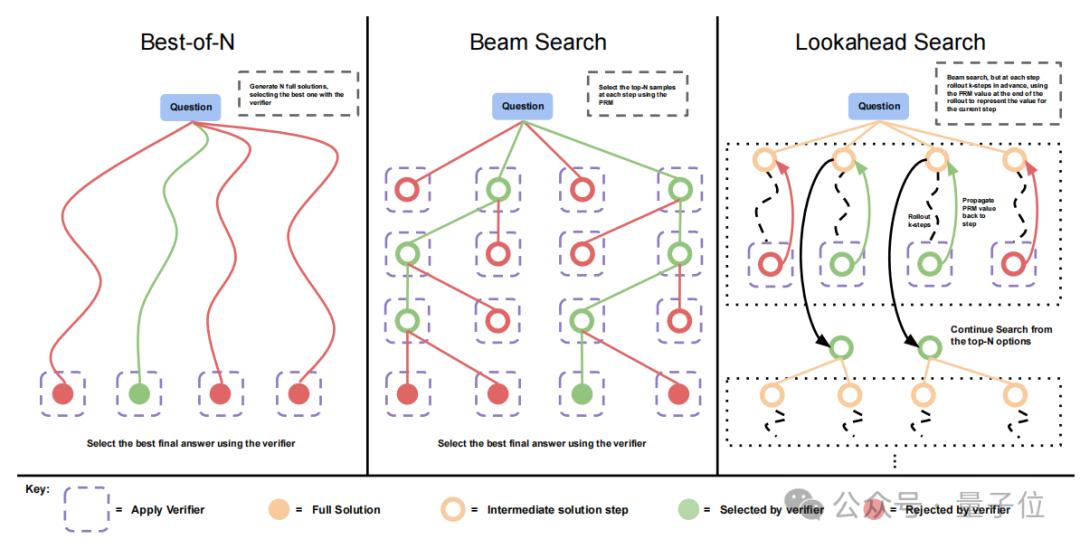

(1)自我修改迭代:在每一次尝试之后,让模型多次尝试回答一个问题,以获得更好的答案。(2)搜索:这样,模型就产生了多个备选答案,

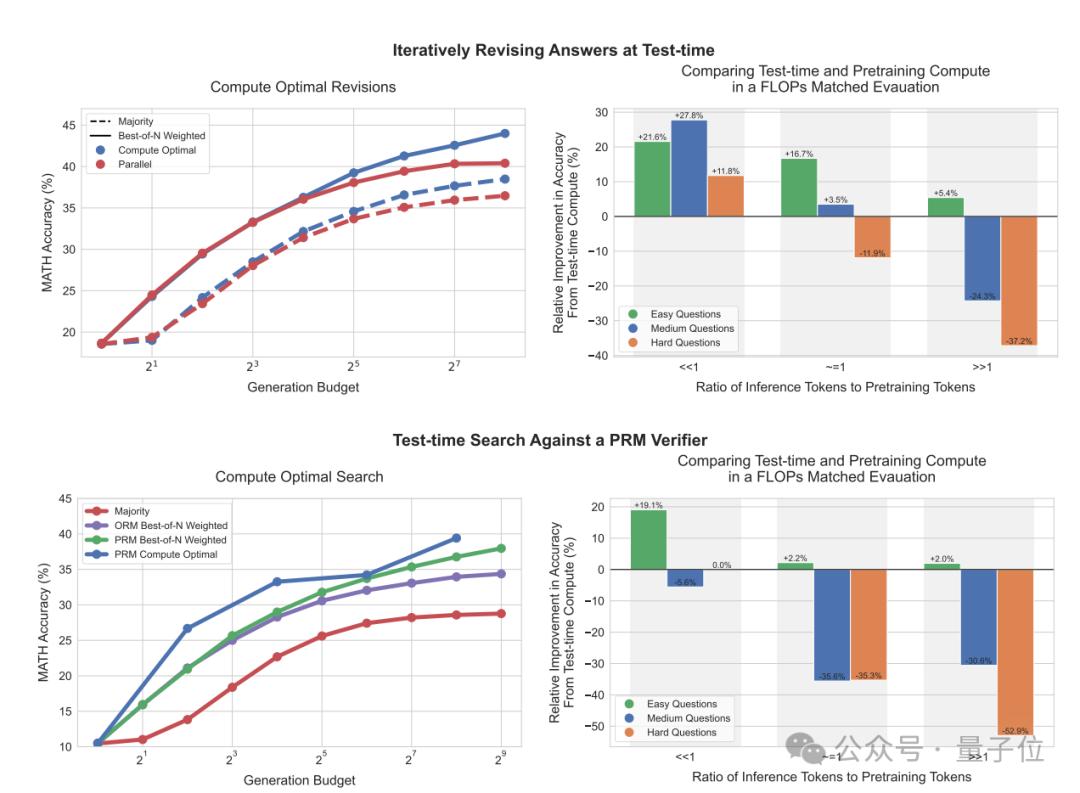

可以看出,在使用自我修改方法时,随着测试时计算量的增加,标准最佳N策略(Best-of-N)不断扩大与计算最佳扩展策略的差距。

采用搜索方法,计算最佳拓展策略在初期表现出较为明显的优势。并且在一定的前提下,达到与最佳N策略相同的效果,只有1/4的计算量。

与PaLMM相比,FLOPs匹配评估与预训练相当。 2-S*(采用最佳计算策略)14倍大的预训练模型(不需要额外推理)。

结果表明,在使用自我修改方法时,当推理tokns远远小于预训练tokens时,计算策略在使用测试时的效果明显高于预训练。但是,当比例增加,或者在更困难的问题上,预训练的效果更好。

换言之,扩展方法是否有效,在两个前提下,根据不同的测试计算,关键在于提示的难度。

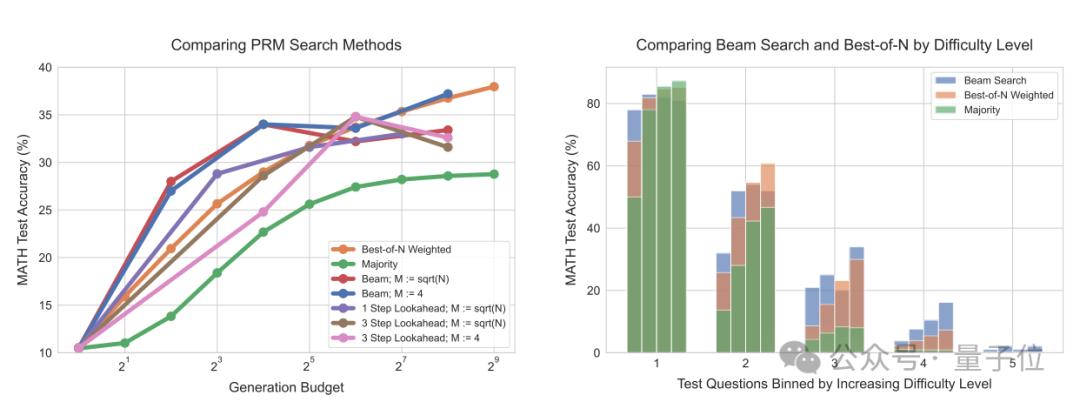

对不同的PRM搜索方法进行了进一步的比较,数据显示前向搜索(最右)需要更多的计算。

如果计算量较小,使用最佳计算策略最多可以节省4倍的资源。

与OpenAI的o1模型相比,这项研究几乎给出了相同的观点。

o1模型学会改进自己的思维过程,尝试不同的策略,认识到自己的错误。而且随着学习(训练时计算)的加强和思考时间的增加(测试时计算),o1 性能不断提高。

然而,OpenAI更快地发布了这个模型,而谷歌在这里使用了PaLM2,Gemini2上还没有更新。

网民:环城河只剩下硬件了?

这一新发现不免让人想起去年谷歌内部文件中提出的观点:

没有环城河,也没有OpenAI。开源模型可以击败ChatGPT。

现在看来,各个家庭的研究速度都很快,没有人能保证自己永远领先。

环城河是唯一一条,或许是硬件。

(所以马斯克唰的建算率中心?)

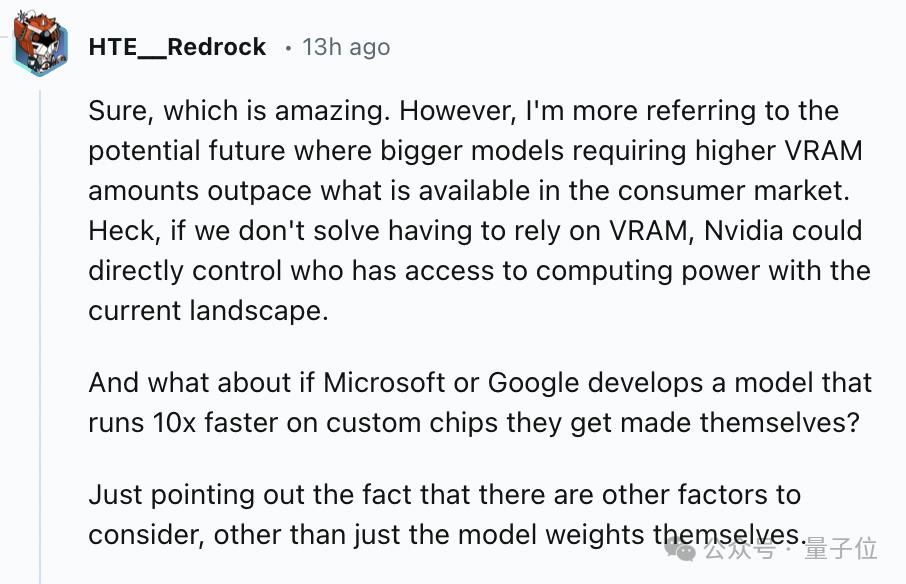

有人说,英伟达现在可以直接控制谁能有更多的计算率。如果谷歌/微软开发出效果更好的定制芯片,情况会怎样?

值得注意的是,前不久OpenAI首个芯片曝光,将采用台积电最先进的A16埃米级工艺,专为Sora视频应用而设计。

很明显,大模型战场,只是卷模本身已经不够了。

参考链接:https://www.reddit.com/r/singularity/comments/1fhx8ny//deepmind_understands_strawberry_there_is_no_moat/

本文来自微信微信官方账号“量子位”,作者:明敏,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com