世界上最大的芯片,进军推理:1800 token世界上最快的/秒

自从Cerebras推出使用整个晶圆制造的芯片以来,过去几年Cerebras的宣传旨在进入英伟达控制的AI芯片市场。

今年年初,Cerebras Systems推出了专门的训练。 AI 最大的生态系统 AI 设计了模型 WSE-3 AI 芯片。根据介绍,这个是基于的 5nm、4 万亿晶体管 WSE-3 为 Cerebras CS-3 AI 通过超级计算机增加动力, 900,000 个 AI 提高计算核心 125 数以千计的峰值 AI 性能。值得注意的是,这是目前半导体代工合作伙伴台积电所能生产的最大尺寸。

从公司CEO开始 Andrew 在过去多年的采访中,Feldman可以看到这个Cerebras Systems掌舵人对英伟达充满了“敌意”(还是酸?)。考虑到英伟达过去几年的表现,这是可以理解的。所以,在过去一直在强攻训练市场之后,Cerebras Systems向推理市场发起了新一轮的冲击。

颠覆传统,推出“世界最快” AI 推理服务

熟悉这个行业的读者应该知道,在很多现代生成 AI 在工作负荷中,推理性能一般取决于内存带宽,而非计算。将比特传输到并传输高带宽内存 (HBM) 模型响应速度越快,模型响应速度越快。

Cerebra Systems 第一款推理商品是基于之前发布的WSE-3 加速器,打破了这个争论。这是因为与 HBM 不一样,餐具大小的硅片特别大,以至于这家创业公司表示,它已经成功封装。 44GB 的 SRAM,带宽为 21 PBps。就这一点而言, Nvidia H200 的 HBM3e 仅拥有 4.8TBps 的带宽。

据CEO Andrew Feldman (安德鲁·费尔德曼)介绍,通过使用 SRAM,该部件以 16 位精度运行 Llama 3.1 8B 每一秒都能产生 1,800 一个以上的token,性能最高。 H100 每秒最多可以生成一个案例 242 一个token。

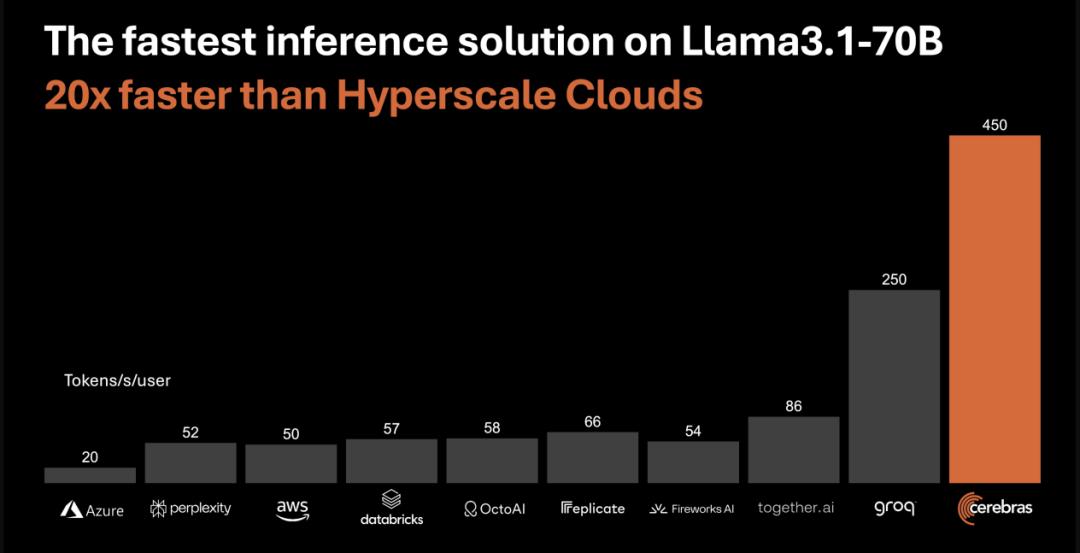

在这四种情况下,运行分布 CS-3 加速器上的 700 十亿参数版本 Llama 3.1 时,Cerebras 声称每秒都可以处理 450 token。相比之下,Cerebras 表示 H100 能处理的最佳速度是每秒。 128 一个token。

费尔德曼认为,这种性能水平将为人工智能选择开辟新的机遇,就像宽带的兴起一样。“今天,我认为我们正处于人工智能拔号的时代。”他说,并指出生成型人工智能的初步应用将逐渐推迟提示的响应。

在他看来,如果你能够很快地处理请求,那么基于多种模式构建代理应用程序就可以避免延迟。Feldman 认为这一性能的另一个优点是允许 LLM 通过多个步骤迭代他们的答案,而不是直接给出他们的第一反应。如果你能足够快地处理标记,那么你就能在幕后掩盖这个事实。

但是,尽管每一秒 1,800 一个token也许看起来很快,事实上也是如此,但是经过简单的计算,我们发现,如果不是因为系统计算能力有限,Cerebra 的 WSE-3 token应该能以更快的速度吐出来。上面提到的,这个产品代表着 Cerebras 到目前为止,这家企业主要集中在一点变化上。 AI 训练。但是,硬件本身并没有真正改变。Feldman表示r,它使用的是同一个。 WSE-3 芯片和 CS-3 实现系统的推理和训练。而且,这些也不是没有达到训练要求的废弃部件——我们问。

费尔德曼说:“我们所做的就是扩展编译器的功能,使其能同时将多层放置在芯片上。

有些分析师直言不讳,Cerebras 的 AI 推理服务不但加速了 AI 模型执行速度,也可以改变公司在实际应用中的安排和安排。 AI 互动观点。

分析人士表示,在典型的情况下 AI 在推理过程中,大型语言模型(例如 Meta 的 LLaMA 或 OpenAI 的 GPT-4o)存储在数据中心,应用程序编程接口 (API) 会调用它们来响应顾客的询问。这类模型非常庞大,需要大量的计算资源才能高效运行。GPU 是当前 AI 推理的主要力量,承担着复杂的任务,但是他们在这些模型的压力下苦苦挣扎,尤其是在模型内存和运算核心之间的数据网络中。

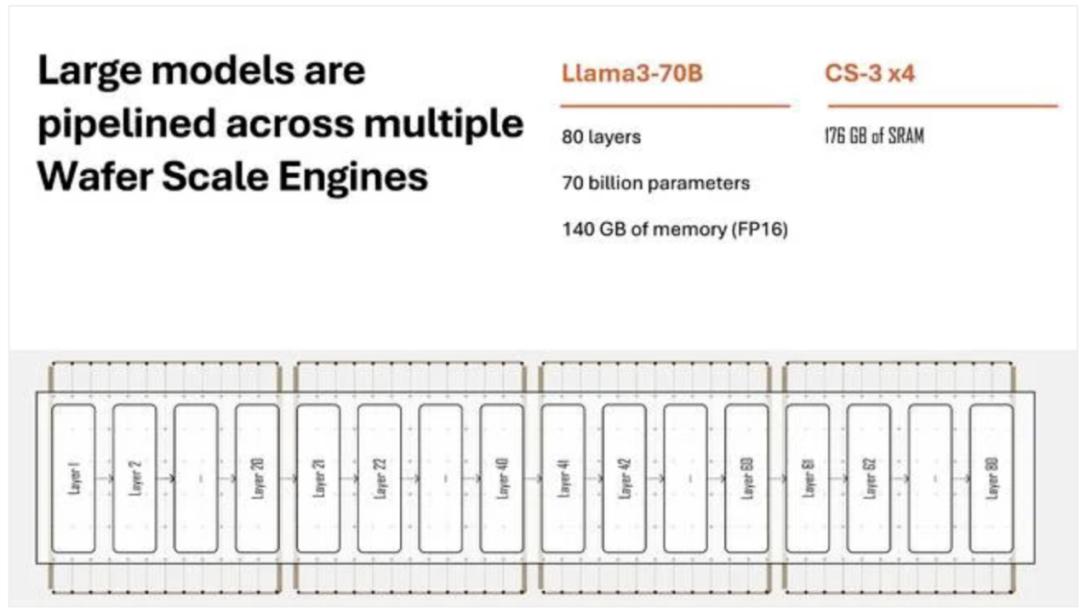

但借助 Cerebras 新推理服务,模型全部层次(现在是 80 十亿参数版和 700 十亿参数版本 LLaMA 3.1)直接存储在芯片上。当提醒模型发送时,由于不需要在硬件中远距离传输,数据几乎可以立即处理。

值得注意的是,这一性能标准已经单独提供。 AI 模型分析的 Artificial Analysis Inc.验证,是前所未有的,为 AI 推理建立了新的规范。Artificial Analysis Inc. 联合创始人兼首席执行官 Micah Hill-Smith 表示:“Cerebras Inference 速度突破了性能界限,价格极具竞争力,因此对于需要即时或大空间的人来说, AI 对于应用开发者来说,特别有吸引力。”

Hill-Smith 进一步指出:“是的 Meta 的 Llama 3.1 8B 和 70B AI 模型,Cerebras 以速度比为基础 GPU 快一个数量级的解决方案。”“我们在 Llama 3.1 8B 每秒导出token超出上测量。 1,800 个,在 Llama 3.1 70B 每秒导出token超出上测量。 446 在这些基准测试中创造了新的记录。”

它的价格也很有竞争力,Cerebras 表示,这项服务的起价仅为每百万个token 10 元 - 相当于 AI 高性价比的推理工作负荷 100 倍。她们补充说,Cerebras Inference “服务很适合”agentic AI"工作负荷,也就是可以代表客户执行任务。 AI 代理商,因为这种应用程序需要能够不断提醒其底层模型。

SRAM,突破极限武器

根据有关报道,Cerebras之所以能够取得这一成就,与他们独特的设计有关。

大家都知道,今天的推理速度受制于连接。 GPU 以及内存和存储的网络瓶颈。连接内存和核心的电路只能在每个单位的时间内传输有限的数据。虽然电子在导体上快速移动,但实际数据传输速度受信号可靠传输和接收频率的限制,受信号衰减、干扰信号、材料特性和数据传输所需的线路长度的影响。

而在传统的 GPU 在设置中,模型权重存储在与处理单元分离的内存中。这种分离意味着在推理过程中,大量数据需要通过细线在内存和计算核心之间不断传输。Nvidia 为了最大限度地缩短这些信息需要传输的距离,与其他企业尝试了各种设备——例如, GPU 将内存垂直堆放在封装的计算核心上。

Cerebras 新的方法从根本上改变了这种模式。Cerebras 并非将晶体管的核心蚀刻到硅片上,并将其切割成芯片,而是将其蚀刻到单片上。 900,000 一个核心,然后不需要在各个芯片之间进行外部走线。WSE 计算(处理逻辑)和内存(静态随机存取存储器或存取存储器或静态随机存取存储器或 SRAM),形成能独立运行或与其它核心协同运行的独立单元。

模型权重分布在这些核心上,整个模型的一部分存储在每个核心中。这意味着没有一个核心可以容纳整个模型;相反,模型被拆分并分布在整个晶圆上。

实际上,我们在晶圆上加载了模型的重量,所以它就在核心旁边,Cerebras 产品和战略高级副总裁 Andy Hock 说明。由于系统不需要通过相对较慢的接口不断来回传输数据,因此该设备可以更快地访问和处理数据。

Cerebras 表示,它的结构在 LLaMA 3.1 在模型推理性能方面,可以达到“市场上同类产品 10 “倍”,虽然这还有待进一步验证。重要的是,Hock 宣称,因为 GPU “实际上,内存带宽限制并不多,” GPU 能像我们一样有效地完成这些推理任务。

对大模型进行优化推理,Cerebras 为了满足快速增长的市场,我正在定位自己,对于快速高效的市场。 AI 需要推理能力。

换言之,这种设计在某种程度上是让SRAM取代更昂贵的HBM。尽管 SRAM 性能明显优于性能 HBM,但是它的缺点在于容量。大规模的语言模型 (LLM) 而言,44GB 这是不够的,因为你还必须考虑键缓存。 Cerebras 针对高batch的目标 在sizes下面占用了很大的空间。Meta 的 Llama 3 8B 模型是 WSE-3 理想化的场景,因为大小是 整个模型可以装入16GB(FP16)芯片。 SRAM 在中间,为键值缓存留下大概概留下。 28GB 空间。

Feldman 声称,除了极高的吞吐量外,WSE-3 也可以扩展到更多的batch sizes,但是这家创业公司并不愿意透露它到底能够扩展到很多方面,维持每一位用户的token生成率。

"我们现在的batch sizes经常变化。我们预计第四季度的batch sizes将达到二位数,Cerebras 告诉我们。

当被问及更多细节时,该公司补充道:“我们现在的batch sizes还不成熟,所以我们不想提供它。高batch采用该系统架构设计。 sizes,在接下来的几个星期里,我们有望实现这个目标。

和现代 GPU 十分相似,Cerebras 通过在多个 CS-3 为了解决这个挑战,系统中的并行模型。具体来说,Cerebras 在多个系统中使用管道并行分布模型层。比如对需要 140GB 内存的 Llama 3 这个模型的70B 80 通过以太网互联的四个层分布在一起。 CS-3 系统中。正如你所料,这确实会降低性能,因为数据必须跨越这些链接。

每秒钟只能在高带宽内存和运算核心之间传输。 3 TB 数据。这远远低于高效运行大型语言模型所需的每秒。 140 TB 速度,这个速度是高吞吐量,不会遇到重大瓶颈。Cerebras声称:“我们内存和计算之间的有效带宽不仅仅是 140 TB,而是每秒 21 PB。”

从这些介绍可以看出,Cerebras能否煽动英伟达还不清楚,但第一个受害者已经跳到了纸上,那就是Groq,它在早期引起了广泛的讨论。

Groq,首当其冲

就设计而言,Groq 语言处理单元 (LPU) 实际上采用了和 Cerebras 类似的方法,即依赖 SRAM。

Groq 并非 AI 谷歌是芯片领域的新手, TPU 最初的创造者 Jonathan Ross 在 2016 年创立。但 Groq 不只是更好的 TPU。Ross 与他的团队一起开发了一种新的结构,最初被称为张量流处理器 (TSP),但是现在改名为语言处理单元(LPU),再一次取得良好的营销效果!TSP/LPU 它是一个巨大芯片大小的核心,采用了一种新颖的策略:确定性计算,可以非常高效地提供大量的 FLOPS。

Groq 其主要体系结构优势在于其开发了一种完全确定的体系结构,全部由软件控制。这个显然意味着什么?为何效率更高?由于大多数应用程序都是不确定的。例如,想想文字处理器。文字处理器不知道你要输入的下一个字母,因此它必须为它收到的任何输入做好准备。结果表明,现代芯片的许多复杂性都来自于能够处理非确定性计算。

Groq 卡片实际上没有片外内存。每一个芯片都有 220 MB 的 SRAM,仅此而已。也就是说,如果你想运行大型模型,你需要很多芯片。要运行 LLaMA-70B,Groq 使用了 576 个芯片。对于 70B 就参数模型而言,这相当于 8 个机架。类似于GPT-4 等拥有 1.76 数以万亿计的参数模型 Groq 在系统上运行,你需要超过它 10,000 个芯片。包括每一个机架 72 一个芯片,所以每个芯片 GPT-4 类系案例需要 100 多个机架。另外,在这一规模下,所有这些芯片联网开始增加瓶颈——现在,Groq 光学互连只能扩展到光学互连 264 一个芯片,不是 10,000 个。那就是Groq和Cerebras的区别。——Groq 的架构 SRAM 由于密度较低,因此需要通过光纤连接更多的加速器来支撑任何给定模型。

Cerebras 需要四个 CS-3 系统可以每秒使用一次 450 一个token的速度运行 Llama 3 70B,而 Groq之前曾经说过,这需要。 576 个 LPU 每一秒都可以突破 300 tokern的速度。Cerebras 引用人工分析 Groq 稍微低一点的标准就是每秒 250 一个token。

Feldman 还指出,Cerebras 不需要量化就可以做到这一点。Cerebras 觉得 Groq 使用 8 为了实现其性能目标,位量化降低了模型尺寸、计算费用和内存压力,但成本却明显降低。

与 Groq 类似,Cerebras 计划通过与 OpenAI 兼容的 API 提供推理服务。这一方法的优点是,已围绕 GPT-4、Claude、Mistral 或者其他基于云的模型构建应用程序的开发者可以整合其代码,而无需重构其代码。 Cerebra 推理商品。

就成本而言,Cerebras 还希望以每百万的token 60 人民币价格提供低于竞争者的价格 Llama3-70B。而且,如果你想知道的话,假设输入和输出token的比例是多少? 3:1。

相比之下,Cerebras 竞争的云端是 H100 为每百万tokene提供相同的模型成本。 2.90 美金。但是,和 AI 推理一样,有很多旋钮和杠杆可以旋转,直接关系到模型的成本和性能,因此对于模型来说, Cerebra 这一说法持保留态度。

然而,与 Groq 不同的是,Feldman 表示 Cerebras 部分用户将继续提供内部部署系统,例如对行业运营进行严格监管的客户。

尽管 Cerebras 与竞争加速器相比,它可能具有性能优势,但是它的支持模式仍然有一些限制。在发布时,Cerebras 支持 Llama 3.1 的 80亿 和 700 十亿参数版本。然而,这家创业公司的计划提高了。 4050亿、Mistral Large 2、Command R 、Whisper、Perplexity Sonar 以及定制微调模型的支持。

绕过英伟达的最大门槛?

正如报告所说,Nvidia 能够牢牢占据的原因 AI 其中一个原因是其在计算统一的设备架构。(CUDA:Compute Unified Device Architecture)这是其并行计算平台和编程系统的主导地位。CUDA 提供一个软件层,让开发者可以直接访问 GPU 虚拟指令集和并行计算元素。

多年来,Nvidia 的 CUDA 一直以来都是编程环境 AI 研究开发的事实标准,并围绕其建立了一个庞大的工具库生态系统。这就导致了一种情况,即开发人员经常被锁定。 GPU 在生态系统中,即使其它硬件解决方案能提供更好的性能。

Cerebras 的 WSE 这是一种和传统 GPU 为了充分利用其功能,必须调整或重写完全不同的结构。开发人员和研究人员需要学习新的工具和隐藏的新编程案例,才能有效地使用它们。 WSE。

Cerebras 尝试通过支持 PyTorch 等待高级框架来解决这一问题,让开发者更容易使用它。 WSE,不需要学习新的低级编程模型。它还开发了自己的软件开发工具包,允许低级编程,可能为一些应用程序提供 CUDA 替代方案。

但是,通过提供不仅速度更快,而且更容易使用的推理服务(开发人员可以通过简单的推理服务 API 就像使用任何其它基于云的服务一样,与它互动),Cerebras 使刚加入竞争的组织能够绕过竞争 CUDA 复杂性并且仍然达到顶级性能。

这种方式符合行业向开放标准的转变,开发者可以在不受当前基础设施限制的情况下,随意选择最合适的工具。

对这一未来,大家怎么看啊?

参考链接

https://www.theregister.com/2024/08/27/cerebras_ai_inference/

https://www.forbes.com/sites/craigsmith/2024/08/27/cerebras-speeds-ai-by-putting-entire-foundation-model-on-its-giant-chip/

https://www.zach.be/p/why-is-everybody-talking-about-groq

https://www.theregister.com/2024/07/14/quantization_llm_feature/

本文来自微信公众号“半导体行业观察”(ID:icbank),作者:编辑部,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com