3D AI芯片嵌入DRAM,AI计算性能急剧增加

电子爱好者网报道(文章 / 尽管目前黄晶晶) AI 训练主要采用 GPU HBM 虽然一些新技术仍然希望进一步打破存储数据传输带来的瓶颈问题。近期,NEO 半导体宣布开发它 3D X-AI 目前,芯片技术旨在替代高带宽内存 ( HBM ) 里的 DRAM 芯片,通过 3D DRAM 中获得 AI 对系统总线问题进行处理。

一般来说,现在的 AI 芯片结构将数据存储在高带宽内存中,数据通过系统总线传输到高带宽内存。 GPU 以执行 AI 算法 ( 数学计算 ) 。该结构效率低下,系统总线将导致长期延迟和高功耗。

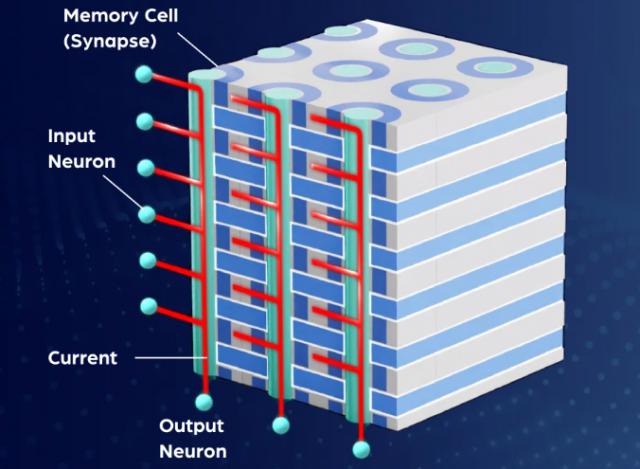

而 3D X-AI 利用存储单元模拟神经网络中的突触。它支持数据存储和人工智能在同一个芯片中的操作。存储单元中的数据直接用于产生神经网络的导出,不进行任何数学计算,大大提高了人工智能的性能,显著节能。

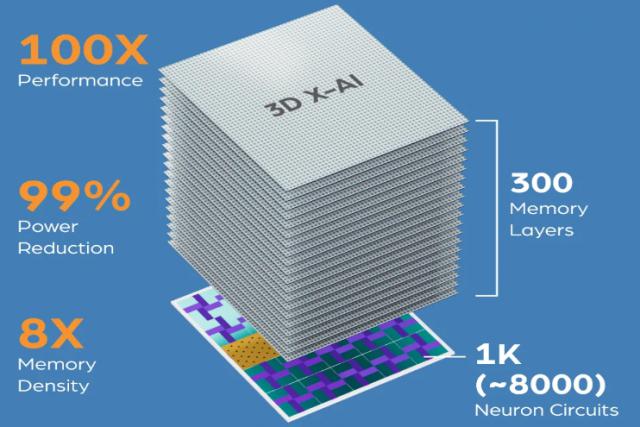

3D X-AI 这是一种芯片 AI 处理量的 3D DRAM 在同一个芯片中,它的底部有一个神经元电路层,顶部有一个 300 层状存储单元,容量为 128 GB。这一创新芯片能提高人工智能芯片的性能。 100 倍数,减少功耗 99%。其具有 8 密度翻倍以上,特别适合存储大型语言模型 ( LLM ) ,用于生成式人工智能应用程序,例如 Chat GPT,Gemini 和 CoPilot。

NEO 介绍半导体,选择 NEO 的 3D X-AI 可以实现技术人工智能芯片,100X 性能加快 : 包括 8000 一种神经元电路,可在 3D 内存中执行 A1 处理;99% 功耗减少 : 把数据传输到 GPU 最小化计算需求,从而降低系统总线产生的功耗和热量;8X 内存密度 : 包括 300 允许存储更多的内存层。 AI 模型。据 NEO 估计每一个芯片都可以支持多少? 10 TB/s 的 AI 吞吐量的处理。据 NEO 估计每一个芯片都可以支持多少? 10 TB/s 的 AI 处理吞吐量。使用 12 个 3D X- AI 芯片堆叠 HBM 封装可实现 120 TB/s 处理吞吐量,提高性能。 100X。

这里的 3D DRAM 也是 NEO 半导体的研发方向之一。传统存储单元的水平放置 DRAM 不同,3D DRAM 垂直堆叠存储单元大大增加了单位面积的存储容量,提高了效率,成为下一代 DRAM 重点发展方向。

NEO 表示,动态随机存取存储器 ( DRAM ) 用来支持Cpu,使用 DRAM 它被广泛应用于电子产品中。然而,Cpu速度的增长速度比多代内存更快,由此产生的“性能差距”逐年扩大。像云数据中心这样的功耗敏感环境越来越依赖更大功率的处理器来满足性能要求,但这将降低可用于内存的功率。

选用 X-DRAM 为了克服传统的使用,架构可以降低功耗,减少延迟,增加吞吐量。 DRAM 这些挑战和其他挑战时有发生。它是一个商业系统 ( 比如服务器 ) 为移动终端提供了更高的性能 ( 例如智能手机 ) 为边缘计算设备提供更长的电池寿命 ( 比如路由器 ) 为物联网目标提供更多的功能 ( 比如网关 ) 提供了新的部署选项。

3D X-DRAM 模块阵型结构与模块阵型相似。 3D NAND Flash,使用了 FBC(无电容浮模)技术,通过增加层掩模,可实现高良率、低成本、密度显著提高,形成垂直结构。NEO 表示, 3D X-DRAM 可生产技术 230 层 128Gbit DRAM 目前的芯片是芯片 DRAM 八倍的密度。近年来,SK 海力士、三星电子、美光等存储厂商都在进行 3D DRAM 为了局限于技术研发, AI 对高性能、大空间内存的需求在浪潮下。

阅读更多热门文章

加关注 星标我们

把我们设为星标,不要错过每一次更新!

喜欢就奖励一个“在看”!

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com