李飞飞亲自发文,数十名科学家签署联名信,反对加州AI限定法案

李飞飞、吴恩达等创新的热土硅谷 AI 科学家们正在与监管机构展开一场关于安全和创新的拉锯战。

这场拉锯战的核心是一个名字。 SB-1047 的法案。该法案的全称是「Safe and Secure Innovation for Frontier Artificial Intelligence Act(前沿人工智能模型安全创新法案)」,试着要有高风险 AI 为防止其被滥用或造成灾难性后果,模型建立了明确的安全标准。

这项法案是今年的 2 这个月在参议院被提出,随后引起了很大的争议。很多科学家认为,法案条款过于不合理,会对科技创新产生致命影响。

法案链接:https://leginfo.legislature.ca.gov/faces/billTextClient.xhtml?bill_id=202320240SB1047

具体而言,该法案旨在从模型上对人工智能进行监督,适用于具体运算成本阀值以上的训练模型。

模型覆盖范围如下:

1、使用超出 10^26 练习次整数或浮点计算的人工智能模型,其成本超过1亿美元(100,000,000,000 美元),这个成本是根据开发者在训练开始时对云计算的平均市场价格进行合理评估的。

2、使用等于或大于 10^25 二次整数或浮点计算三倍的计算能力,微调范围内模型而建立的人工智能模型。

这个范围基本上涵盖了当今市场上所有主流的大型模型。如法案通过,这些模型将被定义为存在。「潜在危险」或者需要额外的监督。

该法案还规定模型开发人员对模型下游的使用或修改负有法律责任。在培训开始之前,开发人员需要证明他们的模型不会被使用或提供。「危险功能」,并且采取一系列的保障措施来防止这种使用。这样会阻碍开源社区的发展。

新法律的监督管理将是一项「前沿模型部门(frontier model division)」,这是一个新成立的监管部门。该机构将制定安全标准,并就人工智能法提出建议。向该机构扭曲模型功能可能会导致开发人员因伪证而入狱。

在法案中,还增加了吹哨人保护条款,保护和鼓励 AI 对实体内部的举报者进行开发,确保员工能够在不受报复的情况下报告公司的不合规性。

如法案通过,州长 Gavin Newsom 一个签名可以纳入加州法律。a16z 普通合伙人 Anjney Midha 表示,如果该法案在加州获得批准,将为其他州设立一个例子,并在美国国内外产生连锁反应。 —— 本质上对创新情况有很大的蝴蝶效应。

太平洋夏令时间 8 月 7 一天早上,相关部门将举行一场关于该法案的听证会。科学家没有太多时间抗议。因此,李飞飞亲自发表了一份文件,陈明的法案非常强大。一些科学家正在签署一封联名信,以防止法案通过。

在《财富》中,李飞飞的文章发表(Fortune)网站上

李飞飞发文批评 SB-1047

在文章中,李飞飞说:「加州的 SB-1047 这将产生重大而意想不到的后果。通常通过法律转变,SB-1047 对正在萌芽的人工智能生态系统造成损害。SB-1047 对开发者进行不必要的惩罚,抹杀开源社区,阻碍人工智能学术研究,同时也难以解决其旨在解决的真正问题。」

她写道:

首先,SB-1047 对开发者进行过多的惩罚,抹杀创新。假如人工智能模型被滥用,SB-1047 要求责任方和模型的原始开发人员承担责任。每个人工智能开发人员(尤其是程序员和企业家)都无法预测其模型的每一个可能用途。SB-1047 迫使开发者退步,并制定防御行动。 —— 我们试图避免这种情况。

其次,SB-1047 开发束缚开源。SB-1047 所有超出特定阀值的模型都需要包含「停止开关」,它是一种可以随时关闭程序的机制。假如开发者担心他们会删除下载和构建的程序,他们就会更犹豫地编写代码和合作。这一停止开关将摧毁开源社区,这是无数创新的源泉。它的影响并不局限于人工智能领域,而是从 GPS 到 MRI 到达因特网本身的各个领域。

第三,SB-1047 公共行政和学术人工智能研究将被削弱。对私营部门来说,开源开发很重要,但对学术界来说也很重要。如果没有合作和访问模型数据,学术界将无法取得进步。如果我们组织不能得到合适的模型和数据,我们将如何培养下一代人工智能领导者?与大型科技公司相比,停止开关甚至会进一步削弱学生和研究人员的努力,他们在数据和运算方面已经处于劣势。在公共行政人工智能投资翻倍的情况下,SB-1047 丧钟将为学术人工智能敲响。

最令人担忧的是,该法案没有处理人工智能前进的潜在危害,包括偏见和深度伪造(deepfake)等等。相反,SB-1047 设置随机阀值,调整使用一定的计算能力或费用 1 十亿美元的训练模式。这一措施不能提供保障,只能限制跨部门创新,包括学术界。如今,学术人工智能模型低于这个门槛,但如果我们想重新平衡私人和公共行政人工智能的投资,学术界将受到影响。 SB-1047 的监管。因此,我们的人工智能生态系统将变得更糟。

SB-1047 限制过于武断,我们必须采取相反的做法。

我不反对人工智能治理。立法对人工智能的安全可靠发展尤为重要。但是,人工智能政策必须赋能开源开发,提出统一合理的规则,制定消费者信心。SB-1047 没有达到这些标准。

数十名科学家联名反对

针对 SB-加州大学除李飞飞外,1047 7 来自其他校区的师生和学生 20 由多个机构的研究人员组成的团体也在迅速行动。他们一起起草并签署了一封反对的信。 SB-1047 公开信件,从研究者的角度,阐述了该法案对加州人工智能研究和教育目标的损害。

联名信从以下几个方面展开讨论。 SB-1047 不合理性:

1、该法案将为开源模型的发布带来「寒蝉效应」,然后进行损害研究

法律要求是正确的「前沿模型」进行「安全审核」和具有「完全关闭」能力,可能会严重阻碍开源和开放权重模型的发布。对于私有实体控制的专有模型,这些严格的规定可能更容易实现,而对于非营利组织或大学联盟使用的开放模型则更加困难。根据可能尚未存在且可能缺乏科学严谨性的检测,法案中关于安全展示和审批的条款表述不够具体。对于有利可图的商业实体来说,这种审计的潜在成本可能很容易承担,但是对于像 Meta 的 LLaMA 这类商业实体的科学开放发布,或者是由非营利组织或大学联盟培训的开放模式,情况可能并非如此。

由于这些繁琐的限制,开源模型的开发者可能会选择在加州或美国之外建立一个系统,并在防止责任的前提下发布其模型。在这种情况下,无视合规性的个人行为人可能会秘密使用这些模型,受公共工作内容约束的学术研究人员将被排除在外,这将促使他们改变研究主题或转移到司法管辖区,而不会侵犯他们的学术自由。对于现代学术来说,开源模型的可获得性 AI 这项研究尤为重要,因为它使学术界能够探索模型的工作原理,在训练过程中提高技能,以及如何改进和破解。

2、预测和预测人工智能风险「能力」评价是不合理的

作为人工智能、机器学习和自然语言理解领域的专家,这些研究人员强调:SB-1047 评估模型风险的建议方法值得怀疑。科学界尚未就语言模型或其他前沿人工智能系统是否以及如何威胁公众达成共识。

3、缺乏对开源模型的保护

虽然法案提到开源模型未来可能会有例外,但目前的保护措施可能很难持续,因为参数数量的快速增长和计算成本的降低。这些模型面临的后果可能很快就会显现出来,没有强有力的保护措施。另外,与大型模型相比,性能相当的小型模型需要更高的核算成本。因此,法案中的修正案估计不能减少对开源模型发布的负面影响,而严格的报告和审计要求也会对研究活动产生不必要的影响。

4、对于学生就业安置和职业成果的焦虑

SB-1047 未来可能会阻碍对人工智能感兴趣的学生进一步学习相关知识,甚至阻止新人才进入计算机科学等关键领域。此外,随着科技行业从大企业向创业公司的转变,额外的监管障碍可能会通过支持更大、更好的企业来削弱新创业者。这种变化可能会缩小学生的职业道路。

部分学者签署了联名信。

除公开信外,还有一些研究人员选择在社交媒体上发声。其中,一位系统生物学家指出,SB-1047 正如我们还不清楚病原体是什么,什么时候会感染我们,以及感染会发生在哪里之前就激活了炎症反应。

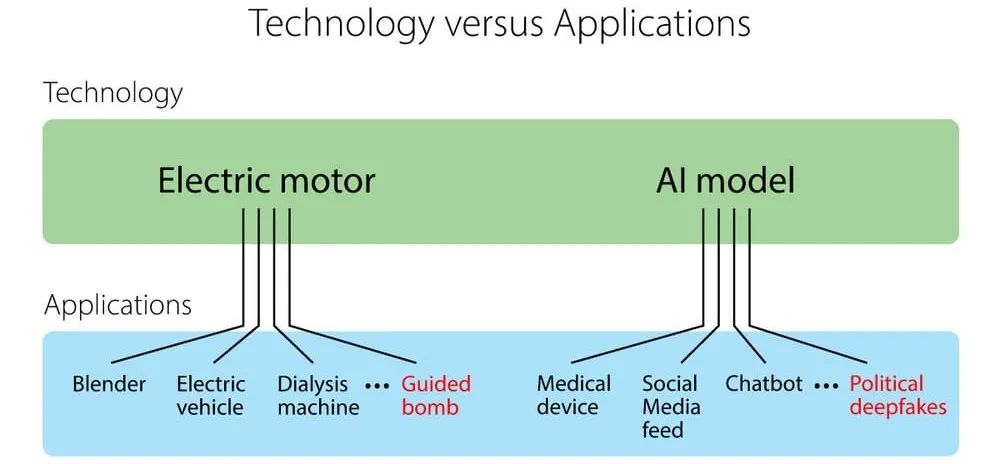

在此之前,吴恩达也多次就此事发声。他认为,监管机构应该控制应用程序,而非技术。例如,电动机是一种技术。如果我们把它放进搅拌器、电动汽车、透析机或制导炸弹中,它就成了一种应用。想象一下,如果法律规定,当任何人使用电动机有害时,电动机制造商都应该承担责任。那个电动机制造商要不停地工作,要不把电动机做得特别小,这样对于大多数应用都没有用。如果我们使用这种法律,我们可能会阻止每个人制造炸弹,但是我们也会失去搅拌器,电动汽车和透析机。相反,如果我们注重特定的应用程序,我们可以更合理地评估风险,判断如何保证它们的安全,甚至禁止某些类型的应用程序。

AI 真的是危险到要这样控制的地步吗?你觉得这个怎么样?

参考链接:https://a16z.com/sb-1047-what-you-need-to-know-with-anjney-midha/

https://drive.google.com/file/d/1E2yDGXryPhhlwS4OdkzMpG5r6_Jxa/view

https://fortune.com/2024/08/06/godmother-of-ai-says-californias-ai-bill-will-harm-us-ecosystem-tech-politics/?abc123

本文来源于微信微信官方账号的“机器之心”,编辑:张倩,小舟,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com