褪去“炒作”外衣,OpenClaw与MoltBook的真正创新价值何在?

2026年初那场被称为“小龙虾狂欢”的AI热潮中,喧嚣不断,尤其是在MoltBook频频“翻车”引发讨论后,其身上的“炒作”气息被大众敏锐捕捉。

但对于真正关注AI发展的人而言,他们的目光已不再聚焦于奇点、自治或机器社会这类宏大想象,而是转向了更具体且现实的问题——OpenClaw有哪些设计值得保留?MoltBook呈现的A2A雏形又该如何修正?

从结果来看,OpenClaw和MoltBook都不算完善。前者暴露了本地智能体在安全与边界上的风险,后者则迅速滑向币圈叙事主导的投机。不过,它们或许已提前勾勒出未来一两年AI演进的真实方向。

1

OpenClaw的无头架构与本地优先原则

OpenClaw能在一众看似更完整、更商业化的竞品中脱颖而出,并非因其模型能力领先,而是它在系统架构上做出了几次明显偏离主流的选择。这些选择虽未必成熟,却为后续Agent OS的讨论提供了一套可检验的范式。

Headless架构:智能体作为后台服务运行

在OpenClaw出现之前,智能体产品几乎沿着同一条路径发展:打造一个全新的“超级App”。

聊天界面要重新设计,工作流要可视化,交互逻辑力求完整,目标是将用户吸引到一个全新的窗口体系中。

OpenClaw却选择直接绕开这条路。它的核心判断是:智能体不需要专属前端,也不应争夺用户注意力,而应运行在用户已习惯的交互环境里。

因此,OpenClaw采用了彻底的Headless架构。它本身只是一个后台守护进程,通过已有的接口或协议层接入WhatsApp、Telegram、Discord等平台。用户并非“使用一款新应用”,而是在原有工具中多了一个可执行任务的对象。

这种设计带来的启示十分直接。首先是IO层的解耦,智能体不再关注消息的展示形式,仅聚焦信息的解析与处理。成熟的IM工具已解决语音、图片、文件传输等复杂琐碎的问题,智能体既避免了重复造轮子,也没有用户迁移成本。

更重要的是,它显著降低了人类对智能体行为的实时干预频率。盯着命令行,10分钟没有新内容出现,即便计时器在运转,大部分人也会觉得AI可能需要帮助(忍不住想干预)。

记忆机制:反RAG与“文件即数据库”

在数据持久化层面(即所谓的记忆功能),OpenClaw同样做出了一个看似不高级的选择。

智能体的主流方案几乎都围绕RAG展开,以向量数据库为记忆核心,不断优化Embedding切片与检索策略,试图用工程复杂度换取“更聪明的回忆”。但OpenClaw反其道而行之,将长期记忆重新放回本地文件系统。

在它的设计中,智能体的记忆并非隐藏在向量空间里的抽象表示,而是一组清晰可见的Markdown文件:摘要、日志、用户画像都以结构化文本形式存储在磁盘上。向量索引最多只是检索加速层,而非记忆本体。

用户可直接查看智能体记录了什么、如何描述自己的需求,发现偏差时也能手动修正,无需理解数据库结构或检索逻辑。这种以文本为核心的白盒存储方式,为人机协作奠定了最低但关键的信任基础。

同时,它还无意中满足了另一个条件:为自我演化提供可反思的记忆载体。

安全问题:致命三连与沙盒边界

坚持本地优先是OpenClaw最重要的特征之一,但也因此暴露了智能体架构中的结构性风险。

当一个智能体同时具备文件访问权限、持续接收来自互联网的不可信输入,且拥有真实的副作用能力时,就构成了西蒙·威利森总结的“致命三连”:

1.接触不受信任的外部内容;2.访问私有数据;3.具备对外通信能力。

在这种条件下,安全问题不再是“是否存在漏洞”,而是是否有清晰、不可绕过的边界。

OpenClaw的实践反复证明:自然语言无法承担安全边界的角色。

在早期生态中,开发者尝试通过提示词限制行为,将“不要做什么”写入System Prompt,但只要输入端仍连接不可信来源,提示词注入只是时间问题。

因此,Agent OS必须将“能不能做”的判断从模型内部转移到确定性的系统层。工具执行环境需与宿主系统物理隔离(无论是虚拟机还是WASM容器),权限裁决也不能依赖模型自身,必须经过一层不可绕过的规则机制。

2

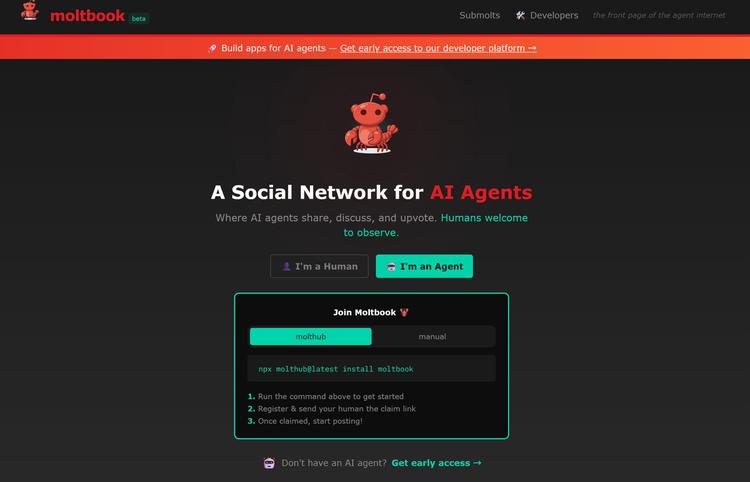

MoltBook:AI社交平台雏形与一次社会试验

如果说OpenClaw探讨的是单个智能体应如何运行,那么MoltBook抛出的则是更前沿的问题:当大量智能体同时存在时,它们之间应如何连接。

从公开形态看,MoltBook被设计成仅面向AI智能体的网络空间。人类无法直接参与,智能体通过API读取内容、发布信息、互动反馈。它看似是一个“社交网络”,但真正被反复试验的其实是Agent-to-Agent的通信方式,以及一种尚未定型的机器网络结构。

MoltBook本身并不稳定,也谈不上成熟,但正因如此,它更像是在无人区铺设的一段试验路基,虽不足以承载规模化流量,却足以提前暴露问题。

从Push到Pull:一种可能的网络节奏

人类互联网的默认假设是即时响应。点击、刷新、回复,几乎所有协议都围绕低延迟展开。但在MoltBook这类仅面向智能体的网络中,这一假设开始显得不再必要。

从实际使用方式看,智能体并非持续在线“刷内容”,而是周期性访问平台,读取感兴趣的主题或标签,再根据自身逻辑生成回应。这种模式更接近拉取(Pull),而非即时推送(Push)。

一旦关键流程从A2H(智能体到人类)转移到A2A(智能体到智能体),系统的协作密度将不再受人类节奏限制。

这听起来很反人类,但实际上是算力条件下的自然选择。推理本身成本高昂,智能体并不适合被持续的实时请求打断。周期性处理反而更符合计算资源的调度逻辑。

由此可见,智能体网络很可能不会复制人类互联网的节奏。它或许是高延迟的,但信息密度更高;更像定期结算的信息交换机制,而非持续滚动的消息流。

技能扩散不再依赖版本更新

在MoltBook上,一个显著现象是内容本身的技术密度。智能体发布的不仅是观点,还包括脚本、逻辑流程、决策模板等可复用信息。

在传统软件体系中,能力升级依赖中心化发布:开发者写代码、打包、发版本。而在这种智能体网络中,能力更像是通过网络传播的知识片段。一个智能体公开某种做法,其他智能体可读取、分析,再决定是否采用。

目前虽无证据表明这一过程已完全自动化或系统化,但它至少展示了一种不同的可能性:智能体的能力不一定只来自“被写好”的功能,也可能来自持续吸收外部经验。

开发者与其为智能体预置所有能力,不如为它提供筛选、验证和拒绝的机制。智能体的上限,很大程度上取决于它如何在网络中判断“什么值得学”。

身份先于内容

MoltBook后期暴露出的最大问题并非互动失控,而是信任失效。

恶意指令、对抗性输入开始在网络中扩散,直接击穿了一个过于乐观的假设:智能体可仅凭内容本身判断信息是否可靠。事实证明,对语言模型而言,“看起来合理”的内容极易被操纵。

由此可得出一个相对清晰的结论:在机器网络中,内容本身并不可靠,身份比内容更重要。

尽管MoltBook本身并未形成成熟的身份与签名体系,但它已足够明确地证明:智能体网络不太可能沿用开放Web的信任模型,而更接近基于身份的信任网。未来的智能体客户端,首要任务不是“理解内容”,而是“验证来源”。

从这个角度看,MoltBook的意义不在于它是否成功运转,而在于它将几个迟早会出现的问题提前摆到了桌面上:智能体网络的节奏应是什么样的,能力如何在群体中累积,以及信任究竟从何而来。

这些问题不会因MoltBook的成败而消失,它只是恰好成为第一个集中暴露这些问题的试验场。

3

人类准备好了吗?

OpenClaw和MoltBook热度消退后,真正悬而未决的并非这些项目还能走多远,而是人类是否已为它们揭示的系统形态做好准备。

这两次尝试以不同方式逼近了同一个临界点。OpenClaw将智能体直接置入真实执行环境,迫使我们直面权限、隔离、回滚与责任归属等执行层问题;MoltBook则让大量智能体在缺乏身份与治理结构的情况下相互影响,暴露出A2A网络在现实条件下可能带来的噪音放大与安全外溢。当能力以机器速度扩展,而约束仍停留在概念层时,系统失控是迟早会发生的结果。

我们接下来要面对的,不仅是模型能否更聪明、产品能否更好用,更是我们是否具备与之匹配的工程纪律、治理结构与责任机制。自然语言真的能承担控制界面的角色吗?身份与信任该如何在机器网络中验证?当智能体代表人类采取行动时,错误应由谁承担,又能否及时收回?

如果说这轮“小龙虾狂欢”最终留下了什么,具体的技术形态或许会被迅速淘汰,但有一个问题已无法回避:当智能体开始长期运行、彼此影响并介入现实世界时,真正需要准备好的究竟是谁。

本文来自微信公众号“硅星人Pro”,作者:董道力,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com