DeepSeek新模型上线:新注意力机制源自北大ACL佳文,价格更亲民

DeepSeek最新模型V3.2 - Exp发布,带来全新注意力机制DeepSeek Sparse Attention(DSA),在提升训练推理效率的同时,API同步降价超50%!

刚刚,DeepSeek最新模型正式上线。

该模型代号为DeepSeek - V3.2 - Exp,被DeepSeek称为最新的实验性模型。

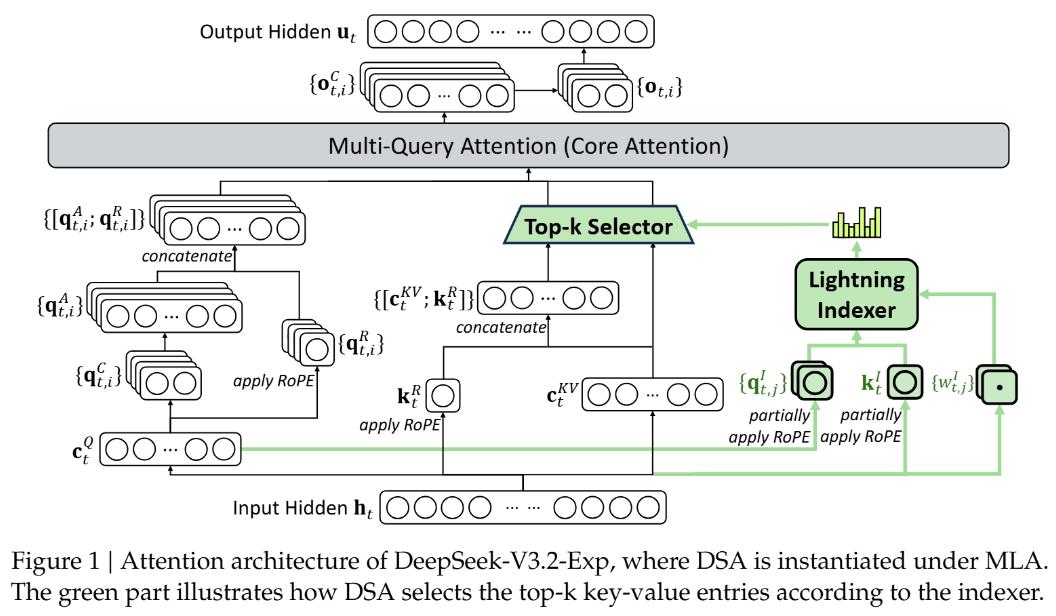

此次V3.2主要基于DeepSeek - V3.1 - Terminus,并首次引入「DeepSeek稀疏注意力」(DeepSeek Sparse Attention,DSA),实现了长上下文训练与推理的更快、更高效。

值得一提的是,这是第一个以「DeepSeek」品牌命名的关键技术(注意力机制)。

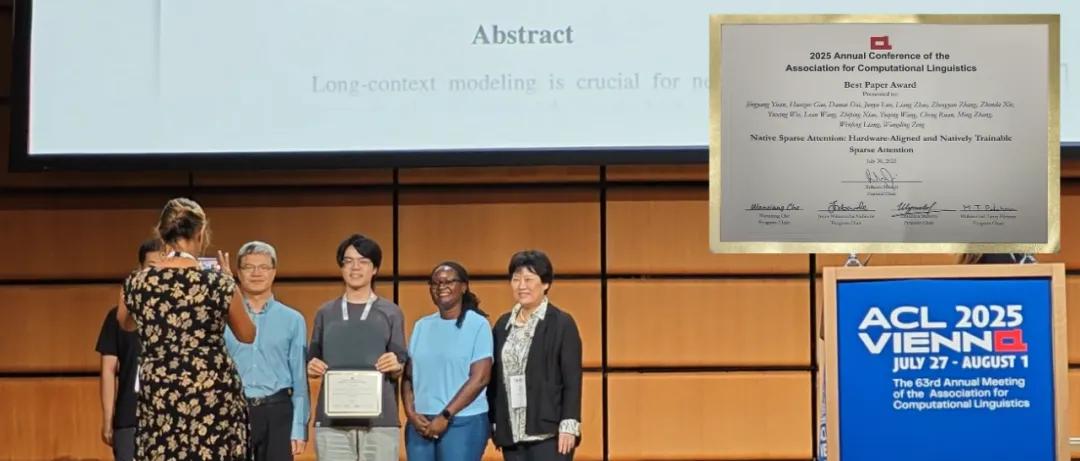

我们发现,DSA是此前与北大合作、梁文锋署名的ACL 2025最佳论文中,原生稀疏注意力(Native Sparse Attention,NSA)的改进版本。

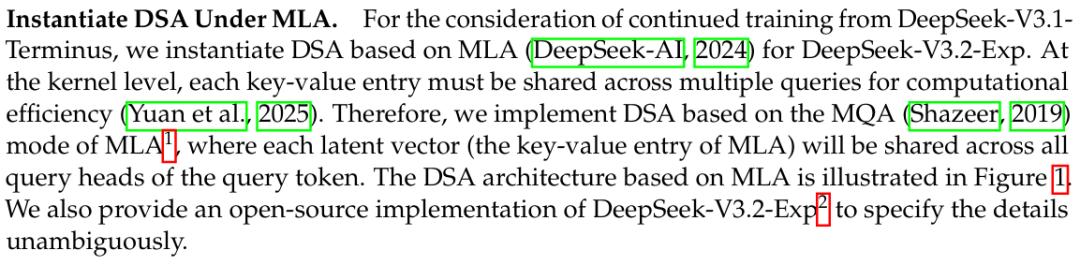

技术报告里的引用

全新注意力机制

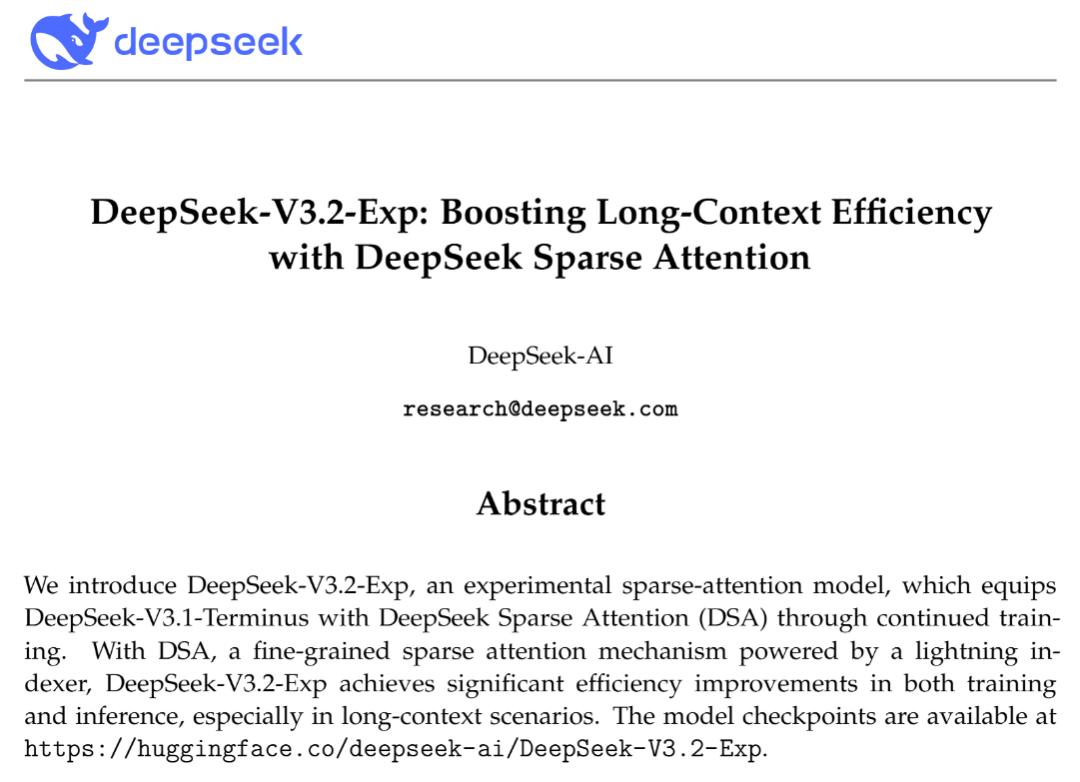

DeepSeek - V3.2 - Exp的核心是「DeepSeek稀疏注意力」,它首次实现了细粒度稀疏注意力机制,在几乎不影响模型输出效果的情况下,大幅提升了长文本训练和推理效率。

论文地址:https://github.com/deepseek-ai/DeepSeek-V3.2-Exp/blob/main/DeepSeek_V3_2.pdf

与之前模型不同的是,DSA不再让每个Token关注序列中的所有其他Token,而是引入了名为「闪电索引器」(lightning indexer)的高效组件。

该索引器能快速判断,对于当前处理的Token,序列中哪些历史Token最重要。

随后,模型从这些最重要的Token中选取(Top - k)一小部分(如2048个)进行精细计算。

这样,核心注意力的计算复杂度从O(L²)骤降至O(Lk),其中k是远小于L的固定值,在处理长文本时效率大幅提升。

更重要的是,这种效率提升并未牺牲性能。

在DeepSeek - V3.1的基础上,团队先进行简短的「密集预热」阶段初始化闪电索引器,使其学会模仿原有模型的注意力分布。

接着进入「稀疏训练」阶段,让模型适应新的稀疏模式。

最后,沿用与前代模型相同的后训练流程,包括专家蒸馏和混合强化学习(GRPO)。

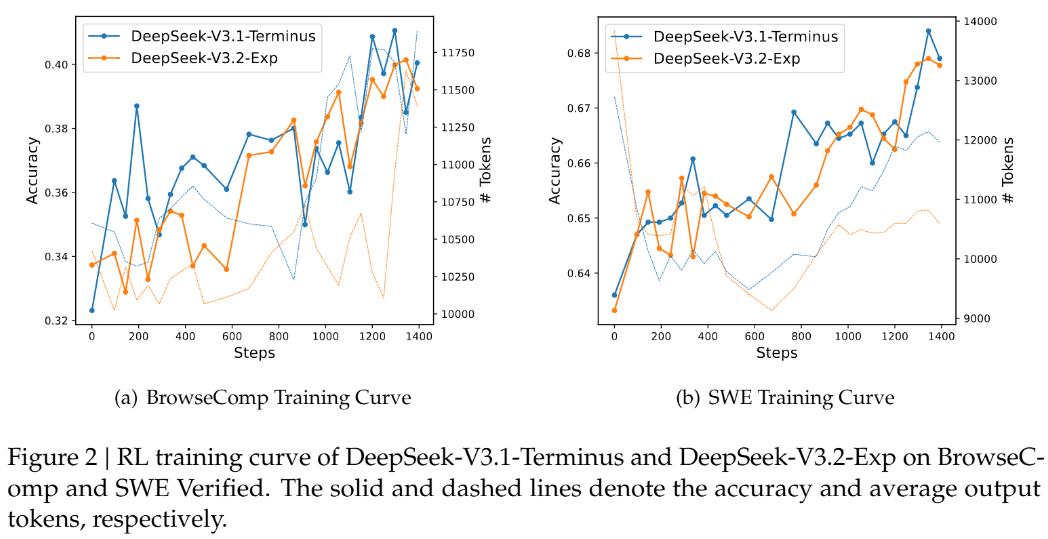

为严谨评估引入稀疏注意力的影响,DeepSeek将DeepSeek - V3.2 - Exp的训练设置与V3.1 - Terminus严格对齐。

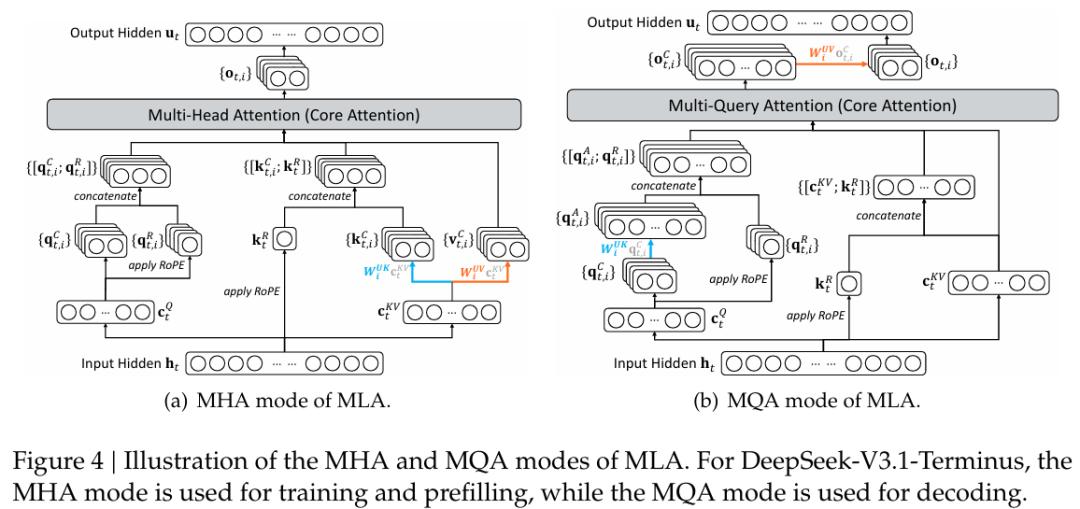

DeepSeek - V3.2 - Exp的架构图,其中DSA在MLA下实例化。

评估结果显示,在短文本和长文本任务上,DeepSeek - V3.2 - Exp与「密集注意力」前身V3.1 - Terminus相比,性能无实质性下降。

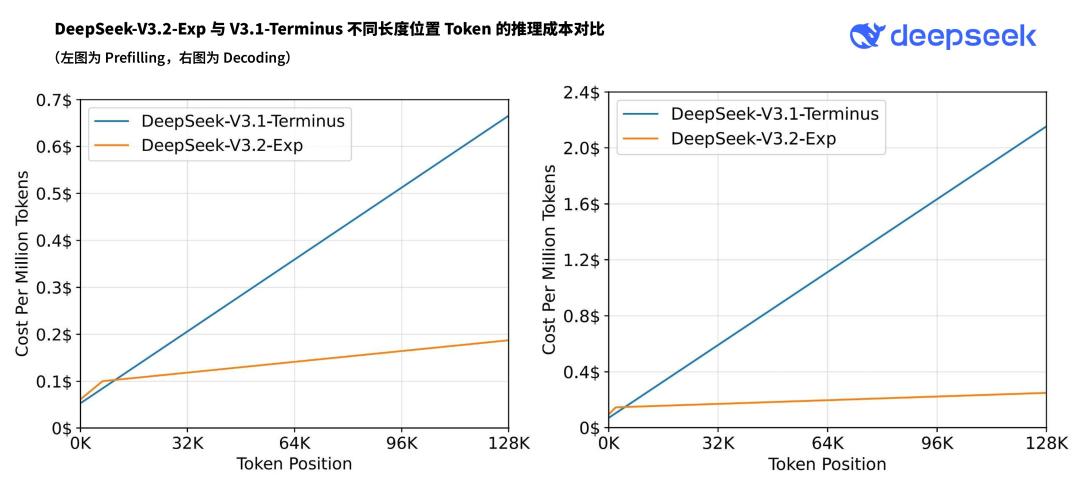

同时,在实际部署的推理成本测试中,端到端加速效果和成本节约显著。

尽管DeepSeek - V3.2 - Exp目前是实验性模型,但它「性能不降、成本骤减」的特性,为大模型突破长文本瓶颈指明了有希望的工程路径。

价格更便宜

DeepSeek再次降低了模型价格!

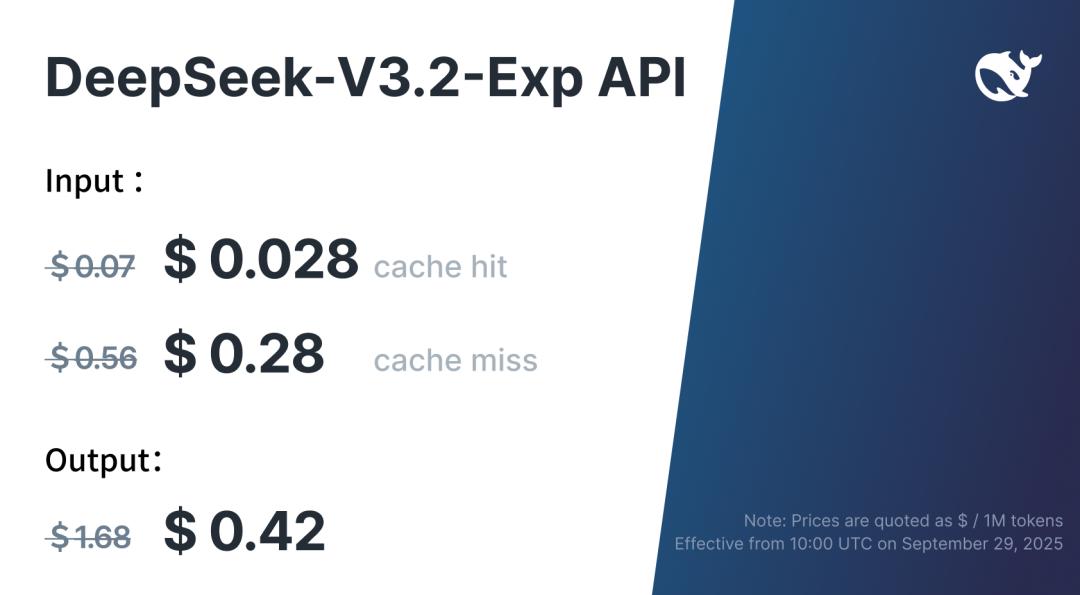

由于新模型服务成本大幅降低,官方API价格相应下调,新价格立即生效。

在新价格政策下,开发者调用DeepSeek API的成本将降低50%以上。

目前API的模型版本为DeepSeek - V3.2 - Exp,访问方式不变。

不得不说,这次DeepSeek很贴心,「发布节奏」听取了网友建议,让AI界朋友能好好休息。

参考资料:

https://api-docs.deepseek.com/zh-cn/news/news250929

本文来自微信公众号“新智元”,作者:新智元,编辑:好困 定慧,36氪经授权发布。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com