苹果创新“清单法”:借AI大模型助力小模型执行复杂指令

IT之家8月26日消息,科技媒体9to5Mac于昨日(8月25日)发布博文,报道称苹果研究人员在最新论文中提出“基于清单反馈的强化学习”(RLCF)方法,用任务清单取代传统的人类点赞/点踩评分方式,极大提升了大语言模型(LLMs)执行复杂指令的能力。

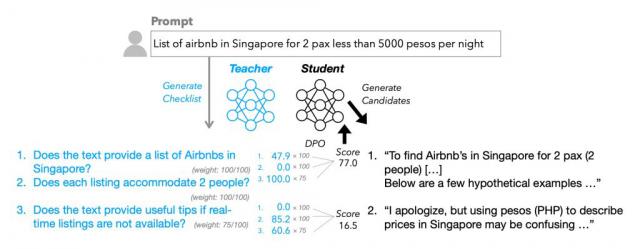

IT之家注:RLCF全称为Reinforcement Learning from Checklist Feedback,与传统的“人类反馈强化学习”(RLHF)依赖人工点赞/点踩不同,RLCF会为每条用户指令生成具体的检查清单,并按0 - 100分逐项评分,以此来指导模型优化。

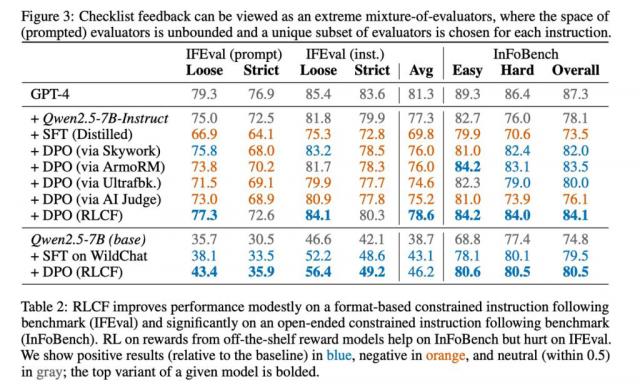

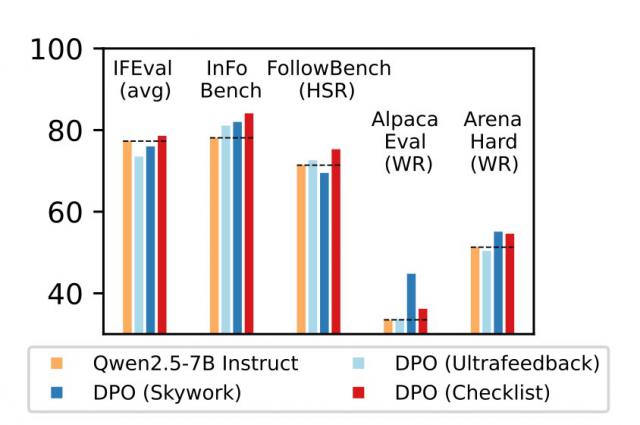

研究团队在强指令跟随模型Qwen2.5 - 7B - Instruct上对该方法进行测试,测试涵盖了五个常用评测基准。结果显示,RLCF是唯一在所有测试中都取得提升的方案:

FollowBench硬性满意率提升了4个百分点

InFoBench提高了6点

Arena - Hard胜率增加了3点

某些任务最高提升达8.2%。

这表明清单反馈在执行复杂、多步骤需求时效果显著。

清单的生成过程也很有特点。团队借助更大规模的Qwen2.5 - 72B - Instruct模型,结合现有的研究方法,为13万条指令生成了“WildChecklists”数据集。清单内容是明确的二元判断项,例如“是否翻译成西班牙语?”。之后,大模型对候选回答逐项打分,综合加权后的结果作为小模型的训练奖励信号。

苹果研究者也承认该方法存在局限性。其一,它依赖更强的模型作为评判者,在资源受限的场景下可能无法实施。其二,RLCF专注于提升复杂指令执行能力,并非为安全对齐而设计,所以不能替代安全性评估与调优。对于其他任务类型,该方法的适用性还需进一步验证。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com