马斯克开源最强模型,Grok-2震撼登场

【新智元导读】Grok-2正式开源并登上Hugging Face,9050亿参数搭配128k上下文,性能强劲。近万亿参数的“巨兽”性能首次曝光,马斯克以“超人”速度推动AI帝国崛起。

令人惊喜的是,马斯克终于将Grok-2开源了!

一早,xAI就正式官宣,面向所有人开源Grok-2!

马斯克还预告,Grok-3将在6个月后开源。

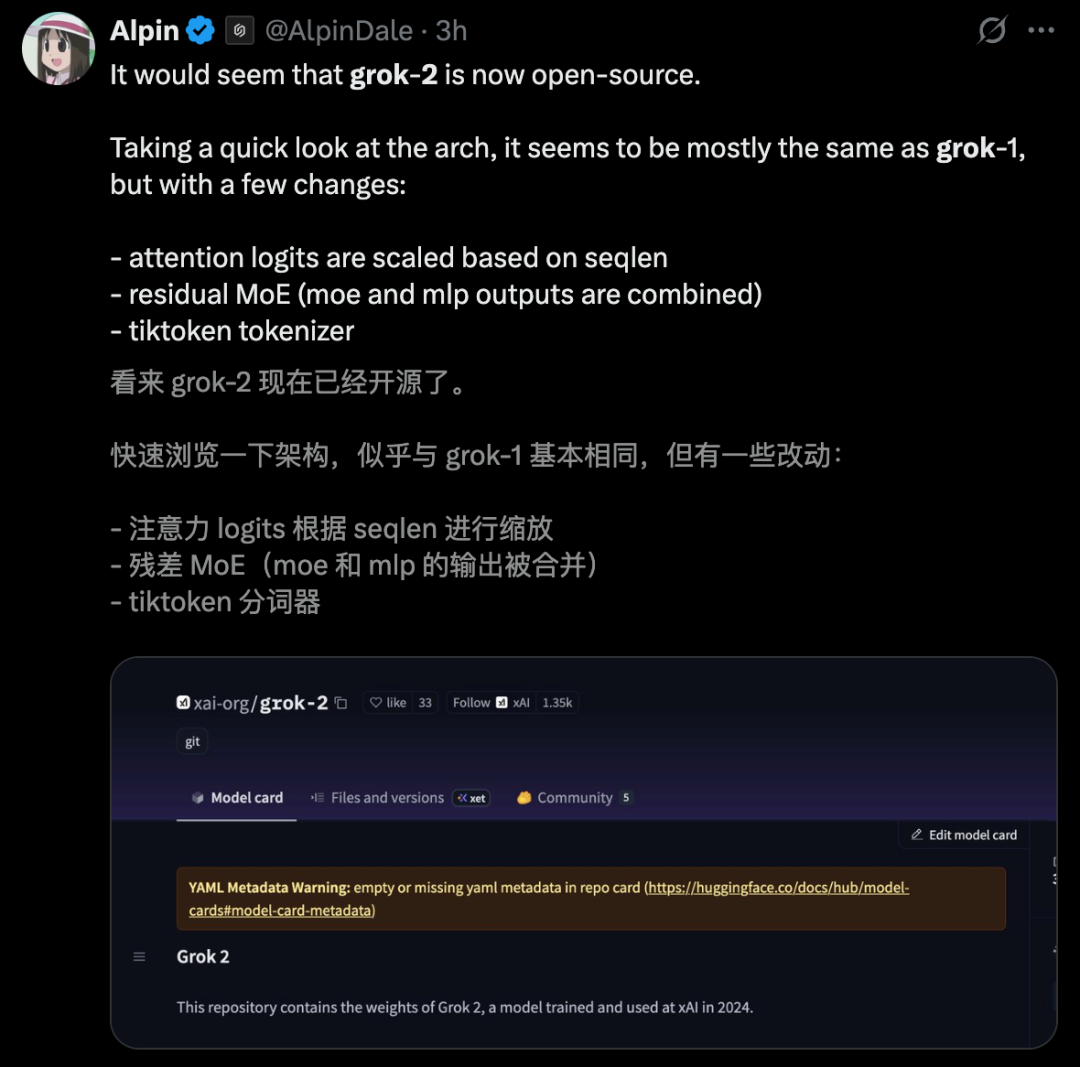

Grok-2于2024年完成训练,体积超过500GB,其混合专家(MoE)架构在Grok-1的基础上有所改进。

那么,Grok-2到底开源了哪些部分?开源版本有什么技术特点?开源权限又是怎样的呢?

下面为你详细梳理:

开源内容

xAI此次向所有用户开源了Grok-2的以下核心部分:

模型权重

模型架构

Grok-2开源版本技术特点

这个开源的“大脑”具备强大的技术规格:

巨大的模型规模:总参数量高达9050亿(905B),推理时每次会激活其中的1360亿(136B)参数,使其成为目前最强大的开源模型之一。

超长的上下文窗口:支持高达131,072 (128k) token的上下文长度,意味着它能一次性阅读和处理很长的文档或对话历史,相当于一本200多页的书,可进行更复杂的推理和总结。

混合专家架构 (MoE):该架构能在不大幅增加计算成本的前提下,扩展模型规模,提升模型能力。

较新的训练数据:预训练数据覆盖大量文本和代码,截止到2024年初。

网友对Grok-2和Grok-1架构的不同点做了总结:

开源权限

商业用途门槛:关联公司年收入低于一百万美元时,才可用于商业用途,超过此门槛需获得xAI的单独许可。

限制:除非协议条款允许对Grok 2进行修改或微调,否则不得使用材料、衍生品或输出(包括生成的数据)来训练、创建或改进任何基础、大型语言或通用人工智能模型。

目前,Grok-2已正式开源,可在Hugging Face上下载。

使用方法:通过SGLang部署

下载权重文件

可将/local/grok-2替换成喜欢的文件夹名称。

hf download xai-org/grok-2 --local-dir /local/grok-2

下载过程中可能遇到错误,需多次重试直至成功。若下载成功,该文件夹下应包含42个文件,总大小约为500GB。

启动服务器

安装最新版的SGLang推理引擎(版本≥v0.5.1),地址:

https://github.com/sgl-project/sglang/

使用以下命令启动推理服务器。此检查点(checkpoint)配置为TP=8,需8张GPU(每张显存大于40GB)。

python3 -m sglang.launch_server --model /local/grok-2 --tokenizer-path /local/grok-2/tokenizer.tok.json --tp 8 --quantization fp8 --attention-backend triton

发送请求

这是经过额外训练的模型,需使用正确的对话模板。

python3 -m sglang.test.send_one --prompt "Human: What is your name?<|separator|>Assistant:"

此时应能看到模型输出名字——Grok。

大佬点评

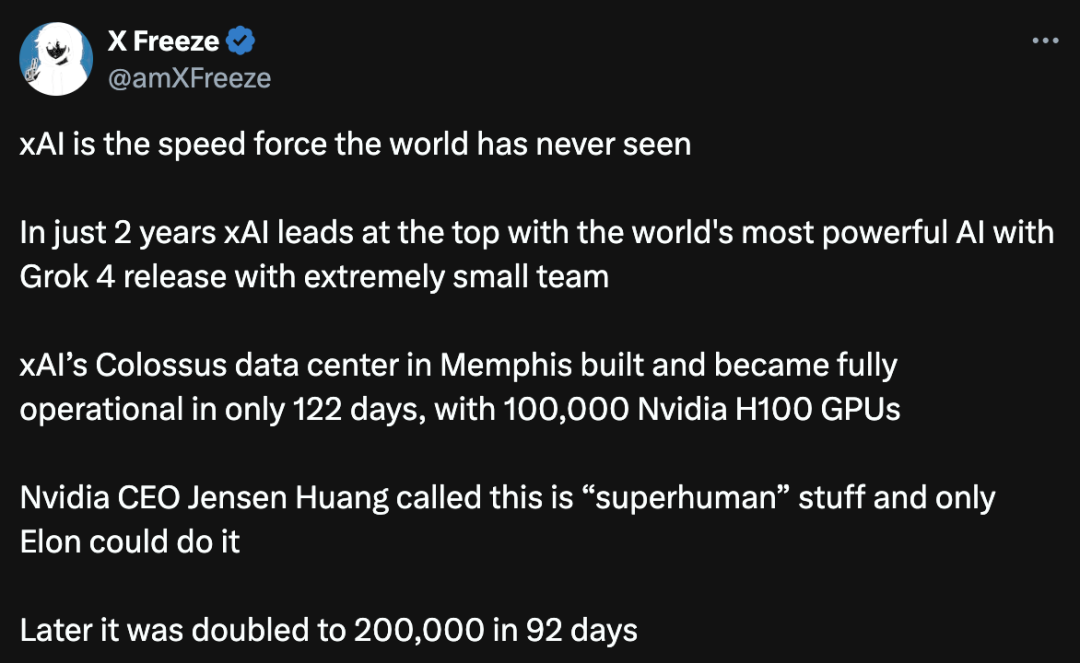

网友XFreeze称,xAI发展速度惊人!他透露,xAI位于孟菲斯的巨像数据中心仅用122天建成并全面运营,配备100,000块英伟达H100 GPU。

他感叹:“短短两年内,xAI凭借Grok 4的发布,以精简团队登顶全球最强人工智能之巅。”

黄仁勋曾说这是“超人”之举,只有马斯克能做到!

在人工智能发展进程中,有网友盛赞马斯克和xAI,称他们正以光速推动AI进步。

马斯克还预告,Grok 5训练即将开始。

有网友感叹,92天内容量翻倍并非资本分配的结果,而是采用新运营策略的成效。

有网友表示,这一切就像亲眼见证科幻梦想成真,达到了创新的巅峰!

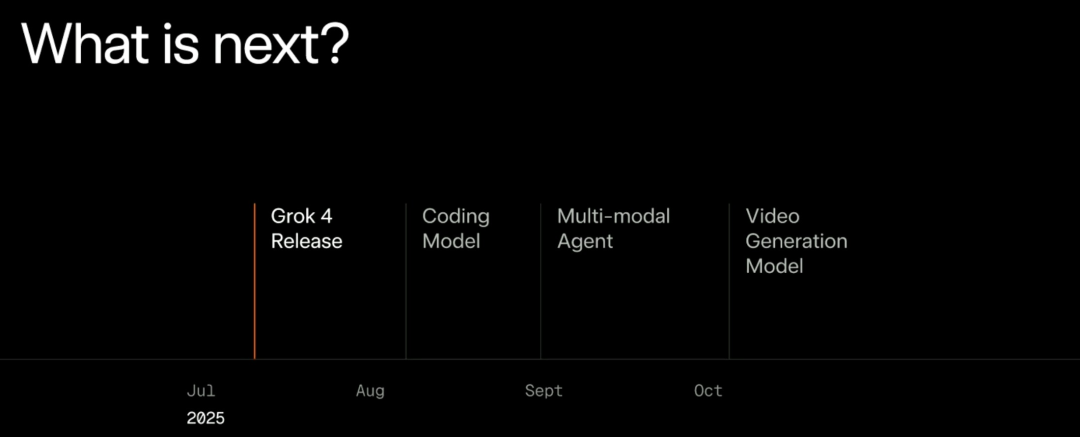

Grok 4发布会上,马斯克预告了下一步路线图:8月发布编码模型,9月发布多模态智能体,10月发布视频生成模型。

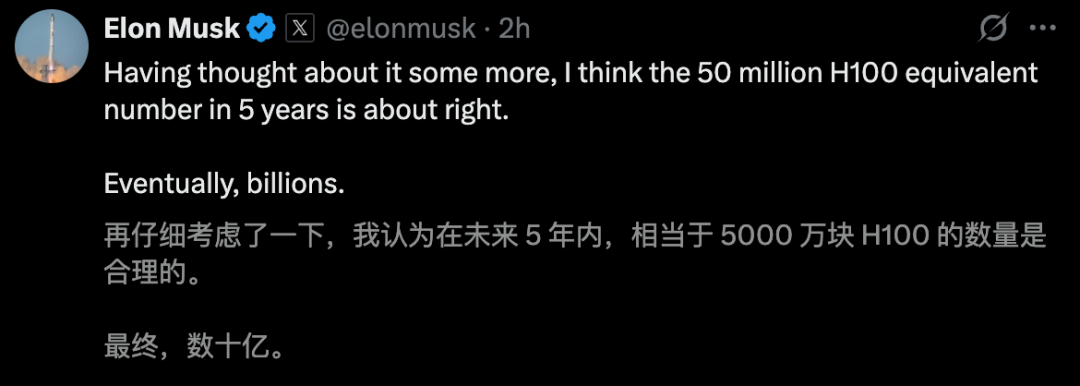

xAI模型能快速迭代,得益于强大的超算中心。预计5年内,xAI将打造出5000块H100巨无霸超算。

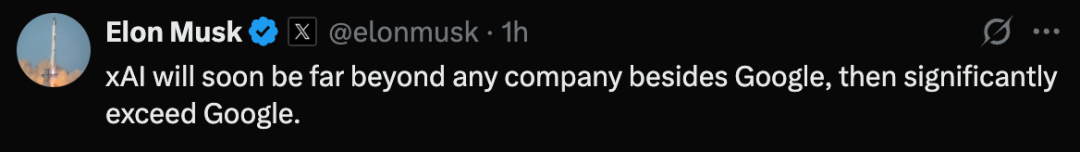

马斯克自信地表示,“xAI很快就能击败除谷歌外的所有对手,超越谷歌也是迟早的事”。

真让人期待,下一个AI帝国即将诞生。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com