“AI教父”辛顿解答:如何让AI助人类而不消灭人类

“没有一个国家希望AI统治世界,如果有一个国家找到办法预防和防止AI操控世界,这个国家肯定很乐意告诉其他国家。所以希望能够有一个AI安全机构构成的国际社群研究技能、培训AI,让他们向善。”

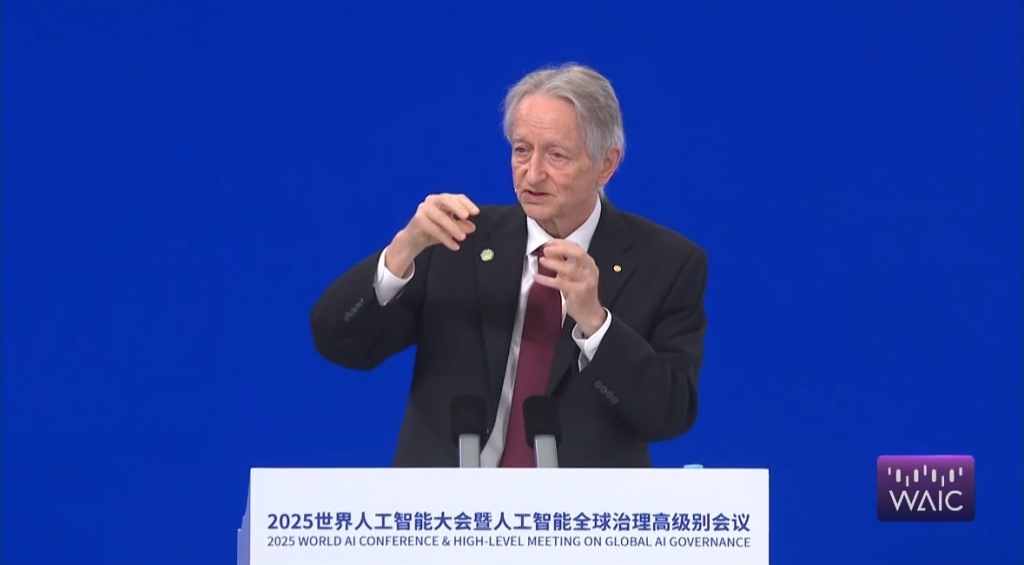

2025世界人工智能大会暨人工智能全球治理高级别会议于7月26日上午在上海世博中心开幕。2024年诺贝尔物理学奖得主、2018年图灵奖得主、加拿大多伦多大学计算机科学名誉教授杰弗里·辛顿(Geoffrey Hinton)作为大会主论坛的首位重量级演讲嘉宾,发表了关于“是否数字智能会取代生物智能”的主旨演讲,对通用人工智能(AGI)的前沿趋势展开探讨与研判。

杰弗里·辛顿(Geoffrey Hinton)

“大语言模型比人类更厉害”

被称为“AI教父”的辛顿,自1985年起就投身于语言模型的研究。大会主持人称他为深度学习泰斗、神经网络之父、人类大脑的探究者。

辛顿表示,60多年来,AI存在两种不同的范式和路径。一种是逻辑型,过去一个世纪都秉持逻辑式范式,认为人工智能的本质在于推理,人们通过符号规则和对符号的表达操作来实现推理;另一种是以生物为基础理解AI,这是图灵和冯·诺依曼所坚信的,即理解是首位的,而后才能学习AI。

“1985年,我做了个小模型,试图将这两个理论结合,以更好地理解人们如何理解一个词。我为每个词设置多个不同特征,记录前一个数字的特征,进而预测下一个数字、下一个词,再预测下下一个词。”辛顿说,如今的大语言模型和人类理解语言的方式相同,都是把语言转化为特征,再完美整合这些特征,这也是AI各层次的工作。

辛顿以乐高积木为例,“用乐高积木能搭建任何3D模型,比如造一辆小车模型。若把一个词看作多维度的乐高积木,可能有几千个不同维度,这种乐高积木可用于多种建模,包括语言建模,每个积木代表一个词。乐高模型相对确定,正方形插在正方形小孔里。”

“但语言不同,每个词都有很多‘手’。若想更好理解一个词,就要让它和另一个词合适地‘握手’。一旦词的造型改变,和另一个词的‘握手’方式就不同,这里存在优化问题。词变形后意思改变,它如何与下一个词‘握手’、理解变化的意思,这是人脑或神经网络理解意思的根本。”辛顿认为,人类理解语言的方式和大语言模型相似,人类也可能像大语言模型一样产生幻觉,因为人类也会创造出有幻觉的语言。

不过,辛顿也指出,大语言模型比人类更厉害,这正是计算机科学的意义所在。在软件里,知识永恒存在,即便毁灭所有硬件,只要软件在,知识随时可复活,从这个意义上说,计算机程式不会死亡。“人的脑子和硬件不同,我们无法永生,而知识软件和硬件可以。”

“必须找一个办法训练AI,让他们不要消灭人类”

谈到人工智能的安全性,辛顿说,现在的情况就像有人把老虎当宠物,小虎仔可爱,但要确保它长大后不伤人,一般来说,养老虎当宠物不是好主意。对待AI,有两个选择:要么训练好它,让它不伤害人类;要么放了它。但我们无法消除AI,因为AI在很多方面表现出色,如医疗、教育、气候变化、新材料等领域,能让各行业更高效。

“我们没办法消除AI,即便一个国家消除,其他国家也不会这么做,所以若想人类生存,必须找到训练AI的办法,让它们不消灭人类。”辛顿强调,“没有国家希望AI统治世界,每个国家都希望人类掌控世界。若有国家找到预防AI操控世界的办法,肯定会告知其他国家。所以希望有一个由AI安全机构组成的国际社群,研究技能、培训AI,让它们向善。训练AI向善的技巧和训练AI变聪明的技术不同,每个国家可自行研究。”

演讲最后,辛顿提议:全球主要国家或AI主要国家应考虑建立一个网络,涵盖各国相关机构,研究如何训练已很聪明的AI,让其不想消灭人类、统治世界,而是乐于做辅助工作。

“尽管AI比人类聪明得多,但我们还不知如何做到。从长远看,这可能是人类面临的最重要问题,好在各国能在这个问题上合作。”辛顿说。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com