中国科技大学突破了图神经网络训练的瓶颈,Capsule 提高系统性能 12 倍

IT 世家 2 月 23 日消息,2 月 11 日本,中国科技大学苏州高等研究院医学影像智能与机器人研究中心 DDL 实验宣布,大规模的神经网络团队(GNN)研究论文在训练系统领域被世界著名的学术会议 ACM International Conference on Management of Data(SIGMOD)2025 录用。

图神经网络(GNN)主流训练框架,如 DGL 和 PyG,运用 GPU 并行处理能力从图数据中获取结构信息,在推荐系统、自然语言理解、计算化学和生物信息学等领域表现出色。

虽然 GPU 在 GNN 在训练中,它提供了强大的计算优势,但是它有限的显存容量很难容纳庞大的图数据,所以目前 GNN 在大规模图数据扩展方面,系统仍然面临挑战。

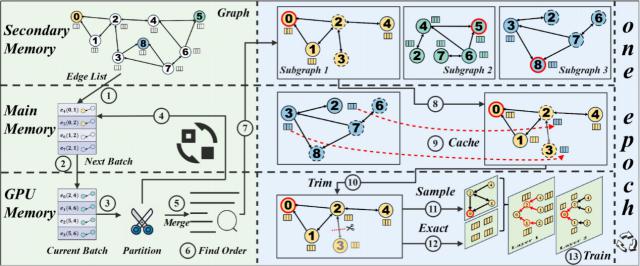

对此,DDL 实验团队提出了一种新的核外核(Out-of-Core)GNN 训练框架 —— Capsule,为大规模图形神经网络训练提供有效的解决方案。

与现有的核外 GNN 不同的框架,该系统通过图片划分和图片切割策略将训练子图的结构及其特点完全放入其中 GPU 从而消除了反向传播过程中的显存 CPU 与 GPU 之间的 I/O 开销,从而显著提高系统性能。

此外,Capsule 进一步优化了基于最短哈密顿电路的子图输入方式和流水线并行策略的性能。同时,Capsule 具有即插即用的特点,可无缝集成到主流开源。 GNN 训练框架。就大规模真实图数据而言,Capsule 与现有的最佳系统相比,它只能使用。 22.24% 最大限度地提供内存 12.02 双重性能提升,并提供了关于训练所得嵌入方差的理论界限。

这一成就标志着中国在图形计算系统领域取得了重大突破,为需要处理超大规模图形数据的场景提供了全新的解决方案,如社交网络分析和生物医学图形构建。

IT 家庭论文链接:

https://doi.org/10.1145/3709669

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com