一个GPU没有用,苹果自研大模型干倒GPT-4?

苹果在当地时间7月29日发布iOS 18.1开发者测试版,上线Apple 第一个版本的Intelligence,同时47页的苹果自研大模型技术报告重磅发布。

Apple 第一个版本的Intelligence推出了以下AI功能:

1、升级Siri。Siri唤起后具有屏幕边缘发光效果,能够理解客户表达不顺畅的指令,并能回答有关苹果商品故障处理的问题。

2、写作工具升级。新版本的iOS提供苹果文本生成服务;同时支持AI生成电子邮件、信息、语音转录摘要等功能。

3、升级视图工具。这个版本提供了更智能的图片搜索和电影回忆制作功能。

仍然有很多苹果在6月份发布的AI功能没有出现在iOS上。 开发者测试版18.1(“苹果AI一夜之间颠覆了一切!Siri史诗级进化,内挂ChatGPT-4o,奥特曼来了,马斯克怒不可遏”),苹果表示计划在明年推出,包括:

1、其它Siri的改进,包含个人信息分析,联动外部应用任务等。

2、图像视觉生成功能,其中包括表情符号的形成,以及自动清理照片等相关视图的能力。

3、ChatGPT在OpenAI下的集成等。

iPadOS 18.1、macOS Sequoia Apple也植入了15.1。 Intelligence是一个新的功能,但是它们目前只对每年支付99美元的注册苹果开发者开放。

苹果在今日发表的论文中透露,两个苹果基本模型(Apple Foundation Model,简称“AFM”)。

论文链接:https://machinelearning.apple.com/papers/apple_intelligence_foundation_language_models.pdf

一个是30亿参数的端侧模型AFM-on-device,在iPhone和其它设备上经过改进可以高效运行;另一种是云模型AFM-server,模型参数尚未公布。

首次向AFM报告模型结构、训练数据、训练过程、推理优化及评估结果解读,并提到背后的模型训练使用的是累计的。谷歌TPU10240,而且没有提到英伟达GPU。

根据论文描述,苹果自主研发模型正在进行指令遵循,文本总结方面检测超GPT-4。

第一,苹果AI首秀:Siri“变身换脑”,写作一键润色

这次,苹果iOS Apple18.1开发者测试版上线 Intelligence功能,主要覆盖Siririgence、写作工具,邮件摘要,照片自然语言搜索等。

1、整个屏幕闪烁着光晕,Siri变身

Siri的变化首先是新的外观,以前屏幕上出现的圆点,被屏幕周围的发光灯所取代,以显示助手处于激活状态。

当开发者不想大声对Siri说话时,开发者可以将键盘从语音命令转换为输入:通过双击iPhone或iPad屏幕底部来输入Siri查询和指令。

Siri已经能够理解多个指令的前后文本。例如,开发者有权要求Siri建立时间表,然后在不重复前面说的话的情况下建立提示。

2、写作工具上线,润色句子,邮件摘要

Apple是写作工具。 Intelligence的一大卖点,支持开发者对语气和措辞提出建议,校对文本,总结要点。

在iOS中,音频转录功能也已经可以体验, 开发者测试版18.1,语音备忘录应用和Notes应用已内置音频转录功能。

写作功能不仅适用于苹果设备的内置应用程序,也适用于标准输入文本系统的第三方应用程序。

目前,电子邮件应用程序将自动识别优先电子邮件,并将提示浮动窗口出现在收件箱的顶部,以提示开发者的特定截止日期,或者避免忘记一些重要的行动。

另外,新版本还支持专注模式,称为“减少影响”(Reduce Interruptions)”,这种模式将使用AI识别过滤的重要通知。

3、自然语言交互搜索照片,AI生成短片

开发者可以用自然语言搜索视频和照片。比如苹果会提供相应的搜索结果,查询“我女儿吃奶酪汉堡的图片”。在不使用更通用的关键词的情况下,在视频中找到特定的图像或准确的时间应该更容易。

新电影回忆(Movie memories)该功能允许开发者输入特定的提醒,使用照片应用中存储的照片和视频来制作电影。

开发者可以输入自己的提醒或使用Apple Intelligence推荐的提示,获得智能电影,电影有明确的章节和主题。

Apple 这些已经上线的Intelligence功能仍然有一些使用限制。

目前,Apple Intelligence只向注册苹果开发者开放,每年只支付99美元,包括面向iOSS的、三个版本的iPad和Mac。开发者需要将设备区域设置为美国,将语言设置为美国英语。

另外,之前六月的报道已经提到,Apple Intelligence要求设备达到iPhone 15 Pro、iPhone 15 Pro iPad和Mac或Mac或Max配置Max。

二、47页论文解读苹果大模型,超GPT-47页文本总结等测试。

与目前各家AI手机相比,苹果自主研发模型的一大特点就是推出了在设备中运行的端侧模型。

据苹果今日发表的最新论文显示,端侧模型名称为AFM-on-device,包含约30亿参数,远远小于OpenAI和Meta等公司模型的千亿参数等级。

苹果还开发了云模型AFM,以执行更复杂的任务。-server。虽然具体尺寸尚未透露,但它的目的是使用“私有云计算”(Private Cloud Compute)为了保证用户信息,系统在苹果的云基础设施中运行。

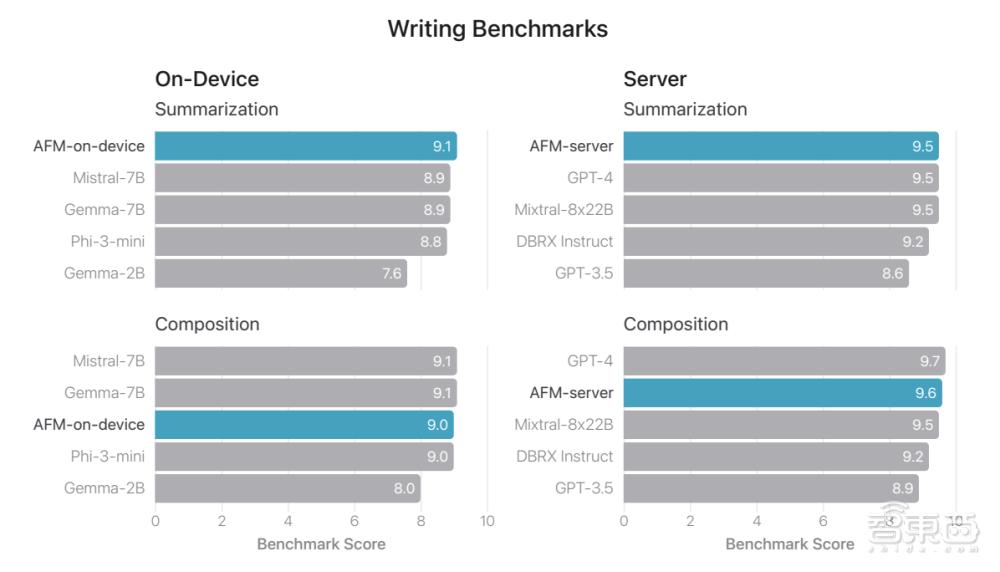

如图所示,AFM-on-在人类检测中,device超越了Phi-3-mini、Mistral-7B、Gemma-开源模型,如2B,接近Llama-3-8B水平。

AFM-在人类检测中,server超过了Llama-3-70B、Mixtral-8x22B、GPT-3.5等闭源模型,接近GPT-4的能力。

与此同时,在指令遵循方面,AFM-超GPT-4的server检测,AFM-on-超越Llama-3-8B的device、Phi-3-mini等开源模型。

AFM两个版本在文本总结方面也是领先的。

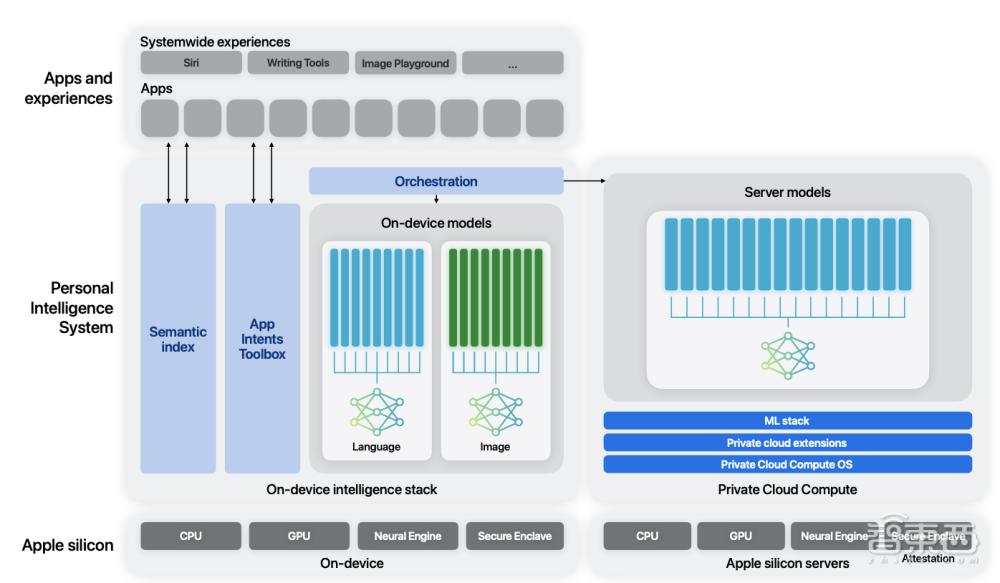

在结构方面,这两个基本模型包括一个基于AFM语言模型的编码模型,用于将智能融入Xcode和一个扩散模型,帮助用户生成一些视觉内容。

在这些模型中,AFM基本模型是一种只有解码器的密集模型,它们基于Transformer架构,并且进行了一些设计优化,包括分组查询注意力。(GQA)、激活SwiGLU函数等。

研究者在文章中解释说,Apple Intelligence由多个高性能生成模型组成,它们快速、高效、专门用于用户的日常任务,并可根据用户操作进行动态管理。

▲Apple Intelligence的架构

Apple展示了其模型开发过程,强调从数据采集到模型部署的每一个阶段,它都遵循负责任的AI原则。

在模型训练方面,苹果云的大模型使用了8192个TPUv4芯片,端面使用了2048个TPUv5p芯片,而英伟达GPU则没有使用。

模型训练后的工作包括一系列数据采集和生成、指令调整和对齐创新,涉及微调监管。(SFT)以及基于人类反馈的强化学习(RLHF)提升模型在指令、推理和写作方面具有两个阶段的优势。

据报道,这些模型是在多样化的数据集中练习的,包括网页、出版商的授权内容、代码存储库和特殊的数学和科学数据。苹果表示,它没有使用个人数据训练模型。

结论:苹果AI首次登陆iPhone,秀自研模型“肌肉”

一个月后,苹果终于推出了第一批Apple。 在Siriri中,Intelligence能力、首先更新写作工具、视图检索等。同时,苹果的两个自研模型被曝光,让我们来看看Apple。 对Intelligence的关键模式有了深刻的认识,并不是媒体传播的“ChatGPT套壳”,而是展现出与其他手机玩家不同的差异化玩法。

然而,目前的Apple 只有部分开发者才能使用Intelligence能力。根据国外媒体的报道,苹果仍然在修复许多新功能的漏洞,因此用户必须等待来检测这一功能。苹果会带来怎样的AI手机体验?我们将拭目以待。

本文仅代表作者观点,版权归原创者所有,如需转载请在文中注明来源及作者名字。

免责声明:本文系转载编辑文章,仅作分享之用。如分享内容、图片侵犯到您的版权或非授权发布,请及时与我们联系进行审核处理或删除,您可以发送材料至邮箱:service@tojoy.com